Vous êtes ici

L’étonnante acceptabilité des deep-fake

Une fois par mois, retrouvez sur notre site les Inédits du CNRS, des analyses scientifiques originales publiées en partenariat avec Libération.

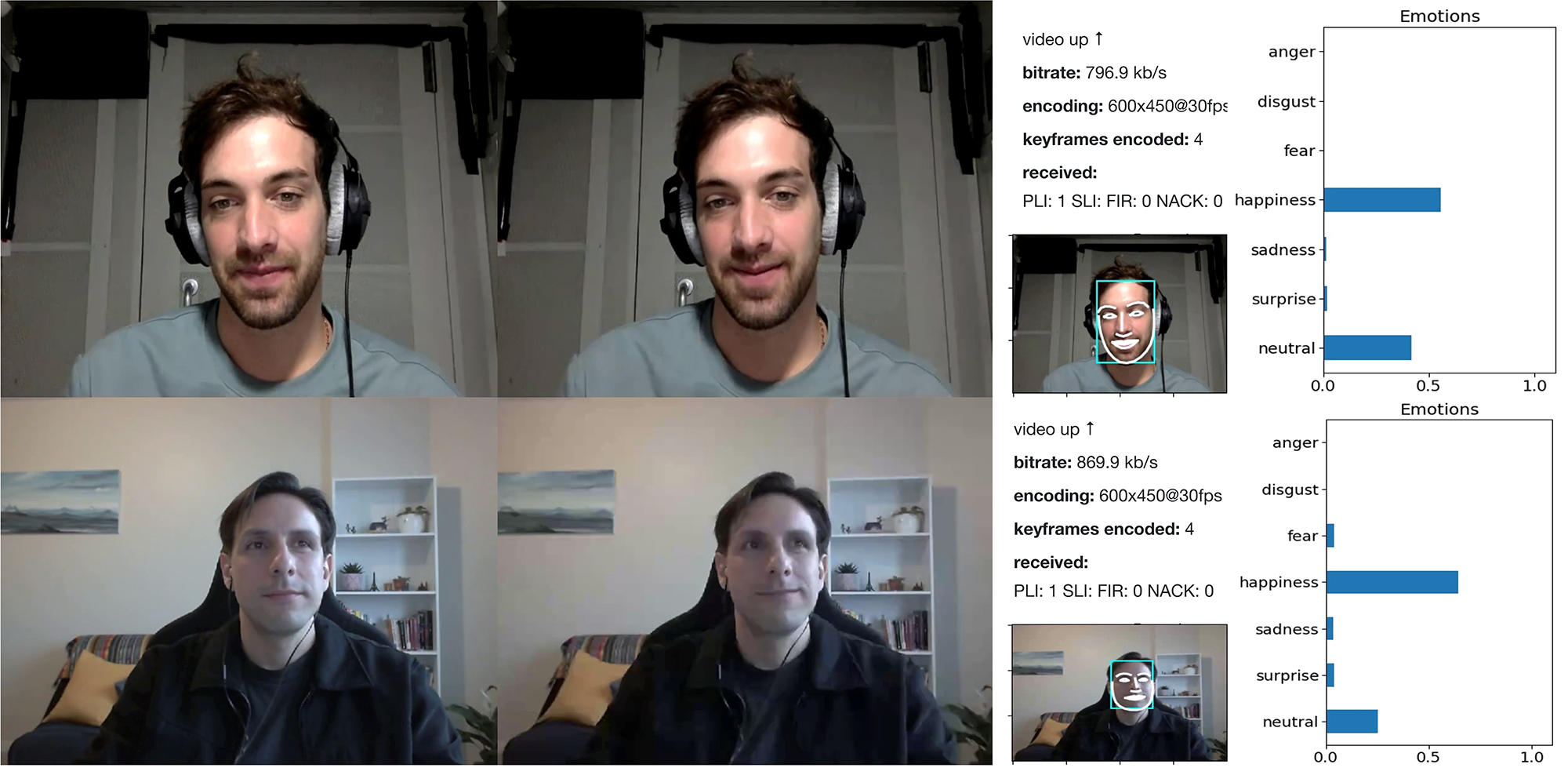

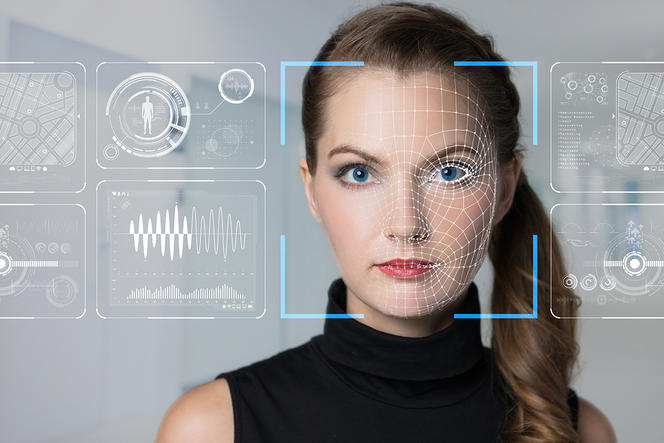

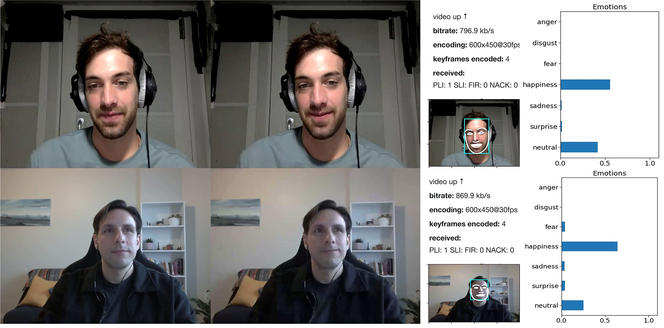

Nous sommes de plus en plus confrontés à des outils de visioconférence, de streaming vidéo ou encore des plateformes interactives, comme Zoom, Tiktok, etc., permettant de modifier notre apparence et notre voix, en direct ou non, grâce à des algorithmes : les fameux « deep-fake ». Aujourd'hui déjà, ou dans peu de temps il sera difficile de savoir si la personne avec qui on parle à distance est réellement telle qu’elle apparaît à l’écran ou si elle utilise un filtre qui transforme sa voix ou son visage.

Malgré l’emballement médiatique sur ces deep-fake, révélés notamment grâce à une bluffante vidéo truquée de Barack Obama qui lui faisait dire, en 2018, que « Donald Trump est un "idiot" », il n'y a pas encore eu d'étude sur la perception morale qu'en a le grand public. Le montage sur Obama, produit grâce au réalisateur et comédien Jordan Peele, et à l’aide d'un logiciel d'intelligence artificielle permettant de coordonner finement les mouvements des lèvres d’une ancienne vidéo avec les mots d’un nouveau doublage vocal, voulait alerter sur les dangers en matière de manipulation des foules. Mais d’autres usages des deep-fake, dans le domaine médical ou la vente à distance par exemple, sont-ils moralement acceptables et dans quelles conditions ?

Pour le savoir, nous avons conçu une étude qui a été récemment publiée dans la revue Philosophical Transactions B de la Royal Society. Nous y expliquons avoir présenté à trois cents Français (majoritairement jeunes, urbains et étudiants, représentatifs des futurs utilisateurs de ces technologies) différents scénarios hypothétiques d'application de transformations vocales émotionnelles.

Des scénarios jugés « moralement acceptables »

Dans ces scénarios « à la Black Mirror », on trouve notamment celui de l’employé de call-center (centre d’appels) qui transforme la voix de ses clients mécontents pour moins souffrir de leur agressivité ; du politicien qui rend sa voix plus convaincante ; mais aussi des situations thérapeutiques comme celle d’un patient dépressif qui rend sa voix plus « souriante » pour ses proches, ou d’une personne stressée qui se calme en écoutant une version apaisée de sa propre voix. Certains de ces scénarios sont d'ailleurs inspirés de nos travaux précédents, sur la façon de parler permettant de paraître le plus honnête possible par exemple, et de ceux de la start-up Alta Voce1. Ce qui était au départ pour nous un simple outil d’expérimentation en laboratoire a pris une dimension beaucoup plus réelle depuis la crise sanitaire et le développement des outils de visioconférence.

Résultats : les personnes testées ont trouvé la majorité de ces scénarios moralement acceptables, y compris, et c'est surprenant, quand l'observateur n’est pas informé que la voix de son interlocuteur est modifiée. Cela vaut pour des situations thérapeutiques, comme nous nous y attendions, mais également pour des situations d'augmentation pure de capacités qui ont pourtant un fort parfum de transhumanismeFermerMouvement international prônant l'usage des sciences et des techniques, comme l’intelligence artificielle et la génétique, ainsi que de croyances spirituelles, afin d'améliorer les caractéristiques physiques et mentales des êtres humains. Il suscite de violentes critiques, notamment de la part de philosophes et de biologistes, qui le qualifient de résurgence de la pensée eugéniste.. Au final, la seule situation qui semble poser problème est de cacher à l'utilisateur le fait que sa propre voix est modifiée algorithmiquement.

Par ailleurs, nos participants ne montrent aucune différence d’acceptabilité entre deux situations opposées : leur avis est le même que les transformations vocales s’appliquent à eux-mêmes ou bien à d’autres personnes qu’ils écouteraient. Alors qu'au contraire, il a été montré que pour des technologies comme les véhicules autonomes, les participants ne voudraient pas acheter une voiture qui épargnerait le piéton plutôt que le conducteur en cas d’accident, tout en reconnaissant que c’est là le choix le plus moralement acceptable. Nous avons aussi montré que plus les utilisateurs sont familiers de ces néo-usages de technologies émergentes, via la littérature ou les films et séries de science-fiction par exemple, plus ils les trouvent moralement acceptables. Tout cela crée donc les conditions pour une adoption massive de ces technologies, à rebours de la tendance manifeste au « techlash » (contraction de backlash – « retour de bâton » ou « réaction violente » en anglais – et technology) observée ces dernières années, comme l’animosité croissante envers les Gafam.

D'évidentes menaces de manipulation

De nombreuses applications sont certes inoffensives, voire vertueuses. C’est le cas par exemple de l'application de transformation de voix dans un contexte thérapeutique pour les patients souffrant de trouble de stress post-traumatique, en cours de développement dans notre laboratoire, ou de transformations de voix rendues « souriantes » pour évaluer les réactions des patients dans le coma2. Mais ces techniques s’accompagnent aussi d’évidentes menaces. Chacun peut craindre, au niveau individuel, l’usurpation d’identité sur les réseaux sociaux, comme le cas de la jeune influenceuse moto dite « @azusagakuyuki » qui s’avéra être un homme de 50 ans, ou encore sur les applis de rencontre. À l’échelle de la société, c’est aussi le risque d’une aggravation des discriminations, avec par exemple des entreprises qui inciteraient leurs employés à masquer technologiquement un accent étranger dans le domaine de la relation client.

L’accélération du rythme de ces innovations nécessite donc une adaptation continue et difficile de la part des usagers, des décideurs et des experts. Il nous semble ainsi indispensable de penser très en amont nos travaux dans le cadre d'une réflexion éthique sur leurs utilisations potentielles et d’accompagner académiquement leur valorisation industrielle, comme nous le faisons avec Alta Voce. À l’heure où le débat public semble alterner entre idéologie technicienne et méfiance généralisée, les sciences humaines et sociales sont donc plus que jamais nécessaires pour étudier notre rapport aux nouvelles technologies et développer une méthodologie plus inclusive impliquant les utilisateurs. ♦

Les points de vue, les opinions et les analyses publiés dans cette rubrique n’engagent que leur(s) auteur(s). Ils ne sauraient constituer une quelconque position du CNRS.

À lire sur notre site :

Des algorithmes contre les images truquées

Voitures autonomes : par quoi serez-vous choqués ?