A la une

L’intelligence artificielle peut-elle nous aider à percer le mystère de l’énergie noire qui booste l’expansion de l’Univers ? C’est possible… La preuve par Deepdip (DEEP learning for large Deep Imaging Programs), un projet qui apporte à l’analyse des images astronomiques une méthode dont la communauté scientifique commence à s’emparer. Et le plus incroyable, c’est qu’une armée d’ados jouant (déjà) trop aux jeux vidéo dans les années 2000 y aura contribué !

Avant d’aller plus loin, il faut mesurer le bond fulgurant de l’astronomie mondiale dans les années 2020. Le lancement des télescopes spatiaux James Webb en 2021 et Euclid en 2023 offre déjà de nouvelles et incroyables capacités d’observation. Les prochaines étapes sont 2025 et 2027, années annoncées pour la mise en service au Nord du Chili de l’observatoire Vera C. Rubin, puis de l’Extremely large telescope (ELT). Le premier sera doté de la plus puissante caméra numérique du monde, le second sera le plus grand télescope terrestre jamais construit.

Avec l'arrivée de ces supers instruments, un tsunami d’images et de mesures d’une qualité inédite va déferler et s’accumuler dans les serveurs de données, portant en elles les germes d’une révolution de nos connaissances du cosmos. « Euclid produit en quelques jours des clichés du cosmos que son prédécesseur Hubble aurait mis des années à réaliser », explique Dominique Fouchez, directeur de recherche au Centre de physique des particules de Marseille (CPPM – Aix-Marseille Université/CNRS), laboratoire qui a contribué à la construction du télescope spatial européen. « Un cliché d’Euclid est 200 fois plus grand qu’un cliché d’Hubble, et on y trouve jusqu’à 100 fois plus d’objets célestes ».

Vue d'Euclid de l'amas de galaxies Persée © ESA/Euclid/Euclid Consortium/NASA, image processing by J.-C. Cuillandre (CEA Paris-Saclay), G. Anselmi

On parle ici de centaines de milliers d’objets… L’une de ces images euclidiennes déjà célèbre, l’Amas de Persée, contient 1 000 galaxies au premier plan et plus de 100 000 en toile de fond. Attachez votre ceinture : l’objectif d’Euclid, c’est d’établir une cartographie 30 000 fois plus grande que ce premier cliché. De même, l’observatoire Vera-C.-Rubin prévoit de réaliser des centaines d’images du ciel de l’hémisphère Sud, chaque nuit pendant 10 ans, dans le cadre du programme Legacy survey for space and time. Soit 10 millions de variations d’objets célestes observées et nouveaux objets identifiés… chaque nuit !

Comment lire cet infini ?

C’est un défi scientifique pour lequel les cosmologues s’aident de réseaux de neurones artificiels couplés à des outils de traitement d’images astronomiques. « Dans ce domaine, le saut technologique a eu lieu dans les années 2000. L'essor de l'industrie du gaming a fait monter en puissance les processeurs graphiques », poursuit Dominique Fouchez. Les scientifiques s’en saisissent dans les années 2010, avec l’objectif d’automatiser et accélérer la reconnaissance et la classification des objets célestes dans les surveys géants. En d’autres termes, faire faire en quelques heures à une machine un travail qui demanderait une année à 1 000 cosmologues.

Les besoins graphiques des jeux vidéos ont contribué au développement de processus puissants utilisés par la cosmologie. © Gorodenkoff - Adobe stock

Mais encore faut-il construire la bonne machine et bien la former pour obtenir des résultats avec la plus grande précision possible. C’est à cela que contribue Deepdip : utiliser le Deep learning pour puiser (to dip) dans l’immensité du cosmos les réponses pertinentes aux questions scientifiques. Le projet consiste donc à développer un réseau de neurones, puis de l’entraîner à l’étude photométrique et au classement de très grands volumes d’objets célestes, directement à partir des images astronomiques.

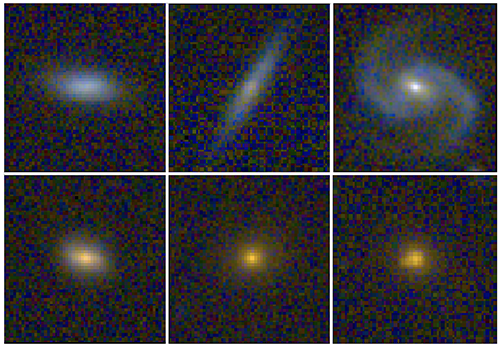

Plus précisément, ce réseau de neurones apprend les lois de l’astrophysique pour reconnaître dans l’image les caractéristiques des galaxies (forme, taille, intensité…) afin de déterminer leur distance et leur vitesse de fuite grâce au « décalage vers le rouge », ou redshift : plus l’objet s’éloigne vite, plus il est lointain et plus il apparaît rouge. À l’inverse, il apparaît bleu.

La machine apprend aussi à classer les objets selon leur courbe de lumière dans une série temporelle, c’est-à-dire l'évolution de leur luminosité au fil du temps. C’est ainsi qu’elle repère les « chandelles standards », ces supernovæ dont on fait des bornes extragalactiques, en comparant la puissance du flash observé pour chacune à la luminosité connue pour toutes.

En haut des galaxies plus proches, plus grandes, plus bleues. En bas des galaxies plus lointaines, plus petites, plus rouges. Le changement de couleur dû à l'éloignement est ce qu'on appelle le décalage vers le rouge. © SDSS (www.sdss.org) J. Pasquet / D.Fouchez (CPPM)

Position, distances et vitesses de fuite des objets, associés dans les diagrammes de Hubble, aident les cosmologues à cartographier la toile cosmique en trois dimensions, étudier l’histoire de l’expansion de l’Univers, remonter jusqu'à son origine… Et chercher à comprendre l’origine de l’accélération de cette expansion, son carburant : la fameuse énergie noire, force d’anti-gravité dont les effets sont observés mais dont la nature reste inconnue…

Deux univers rassemblés

Pour lancer Deepdip, il a fallu approfondir les liens entre la cosmologie et l’informatique. Et apporter une première preuve de concept dans un article publié début 2019 : « Sur la base d’un prototype de réseau neuronal convolutionnel profond, nous avons montré que notre modèle de Deep learning délivrait des mesures de redshifts photométriques plus précis que les méthodes existantes. »

Dominique Fouchez entreprend alors de développer ce modèle en associant les ressources et équipes de quatre laboratoires : le CPPM avec son expertise cosmologique sur les supernovae, le Laboratoire d’astrophysique de Marseille (LAM – Aix-Marseille Université/CNES/CNRS) sur les redshifts, le Laboratoire d'informatique, de robotique et de microélectronique de Montpellier (LIRMM – CNRS/Université de Montpellier) sur le Deep learning, et l’Institut d’astrophysique de Paris (IAP – CNRS/Sorbonne Université) pour le computing (serveurs, matériels, logiciels, accès aux données) et le traitement des résultats.

Dans un premier temps, le réseau de neurones artificiels a appris à lire et traiter une très grande masse de données issues de la première génération de grands surveys via les catalogues du LAM. « Auparavant, on pouvait extraire quelques données d’une image mais on voyait bien qu’on n’exploitait pas toute l’information disponible. Avec le Deep learning, on a confié les données à la machine pour qu’elle explore des milliers de paramètres, retrouve les règles toute seule et automatise des analyses très complexes. Maintenant on lui donne directement une image astronomique dont elle va lire chaque bande spectrale au niveau du pixel pour en extraire les données nécessaires. »

Des hauts et des biais

Au fil de son apprentissage profond, la machine a été mise en application sur différents angles d’études, tant pour tester ses capacités et sa précision (sur les redshifts photométriques par exemple) que pour préparer la réponse à des questions scientifiques ayant trait à l’énergie noire. Les doctorants impliqués dans le projet ont soutenu leurs thèses sur les performances de la méthode fin 2023. Et l’une des plus récentes publications montrent comment l’approche Deepdip permet de mieux réduire et résoudre les biais d’analyses des réseaux de neurones.

Car ils ne sont pas infaillibles ! « La machine apprend de façon semi-supervisée, avec des exemples, mais ces exemples comme la façon dont elle a appris peuvent contenir des biais », explique Dominique Fouchez. « Et quand on mesure quelque chose, le plus important c’est de connaître l’intervalle de confiance. Pendant un temps, notre machine avait du mal à le donner. » C’est le côté obscur de la force de l’IA… Une part du projet Deepdip, c’est la compréhension statistique de cette boîte noire. Et la suite, c’est de toujours mieux « comprendre comment la machine comprend », quitte à la contraindre en lui réinjectant des règles astrophysiques qu’elle s’est appropriée.

Désormais, le monde de l’astronomie prend en main les outils nés de Deepdip. Un catalogue international de centaines de millions de redshifts est en projet. La méthode commence à être disséminée, reproduite, confortée dans sa validité statistique. « La communauté obtient des résultats et des informations nouvelles sur des objets qui n’avaient jamais eu de spectroscopie. Même si on reste prudent sur l’exploitation des données, la méthode développée avec Deepdip est sur le chemin de devenir la référence pour l’analyse de la prochaine génération de surveys. »

--------------------------------------

C’est quoi la cosmologie ?

Au sein de l’astronomie, science de l’observation des astres (étoiles, galaxies, trous noirs, planètes…), l’astrophysique s’intéresse à leurs propriétés physiques (lumière, densité, composition chimique…), tandis que la cosmologie, venue de la physique, étudie l’Univers dans son ensemble pour comprendre la formation et l’évolution des grandes structures de l’Univers depuis le Big Bang. On peut considérer que la cosmologie moderne est née dans la première moitié du XXe siècle, quand les travaux de Hubble et Lemaître notamment ont démontré l’expansion de l’Univers, mettant fin à la théorie de son immobilité.

Pour aller plus loin : https://lejournal.cnrs.fr/articles/matiere-noire-la-recherche-passe-a-laxion

_________

Ces recherches et cet article ont été financés en tout ou partie par l’Agence Nationale de la Recherche (ANR) au titre du projet ANR-Deepdip - AAPG 2018-2019. Cette communication est réalisée et financée dans le cadre de l’appel à projet Sciences Avec et Pour la Société - Culture Scientifique Technique et Industrielle.