Vous êtes ici

Ces lois cachées dans le désordre

Temps de lecture : 14 minutes

C’est quoi le désordre ? Ce n’est pas juste l’état du bureau de votre collègue sur lequel tiennent trois années de dossiers, de courriers, de stylos, de prospectus et de menus à emporter dans un équilibre précaire. Les physiciens vous diront que le désordre est partout. Il dessine aussi bien le cours du café à la Bourse, que le repliement des protéines à l’origine de la diversité du vivant. « Au sein d’un système désordonné, chaque élément participant au collectif a des propriétés différentes des autres constituants, ou peut se trouver dans un environnement différent des autres », décrit Marc Mézard, directeur de l’École normale supérieure - PSL et spécialiste de la physique statistique.

Ce sont, par exemple, les particules d’un nuage qui change perpétuellement de forme. Si parfois rien ne semble justifier le comportement macroscopique de cet amas de gouttelettes en suspension, il existe en réalité une multitude d’interactions complexes à plus petite échelle qui en sont responsables. Est-ce là le reflet d’un ordre sous-jacent, d’une loi cachée dans le désordre ? L’étude de ces interactions est au cœur des travaux de Giorgio Parisi récompensés par le prix Nobel de physique en 2021 pour sa découverte de l'interaction du désordre et des fluctuations dans les systèmes physiques.

Analyse multifractale : un signal en poupées russes

Dans les années 1980, Giorgio Parisi et Uriel Frisch s’intéressent au phénomène de turbulence1, caractéristique du mouvement des fluides. « Dans une rivière, elle prend la forme de tourbillons de toute taille qui apparaissent, disparaissent et semblent interagir tout en donnant une impression d’un grand désordre », décrit Bérengère Dubrulle, physicienne spécialiste de la turbulence au laboratoire Service de physique de l’état condensé2. Les deux chercheurs proposent pour la première fois une description multifractale en vue d’analyser la complexité de ce phénomène.

« Des essais dans la soufflerie de Modane avaient permis de démontrer que l’écoulement d’un fluide turbulent est marqué par une invariance d’échelle. Autrement dit, le signal est compliqué, à toutes les échelles, mais un peu de la même façon à chaque fois », explique Stéphane Jaffard, professeur de mathématiques au Laboratoire d’analyse et de mathématiques appliquées3. Les scientifiques parlent d’autosimilarité statistique : en zoomant à l’intérieur du signal, il est possible de retomber sur un signal similaire. Et avec ces nouveaux outils, c’est le lancement de tout un pan de recherche sur la turbulence.

La turbulence agite les pronostics climatiques

Quarante ans plus tard, les méthodes développées par Parisi et ses collaborateurs servent toujours à l’étude de la turbulence. À grande échelle, elles permettent d’appréhender l’évolution du climat. « Les gros tourbillons atmosphériques ou océaniques ne bougent pas très vite, mais ils ont une propriété chaotique qui fait qu’ils dépendent fortement des conditions initiales », explique Bérengère Dubrulle. C’est l’effet papillon. Imaginez deux atmosphères animées par la même répartition de tourbillons, à l’exception près d’une minuscule perturbation présente dans un seul cas. La modélisation de la dynamique de ces états aboutira à deux situations météorologiques complètement différentes dix jours plus tard.

Cela engendre un paradoxe : nous sommes incapables de prédire la météorologie au-delà de dix jours, alors que le Groupe d’experts intergouvernemental sur l’évolution du climat (Giec)4 réalise des pronostics sur la température qu’il fera dans cinquante ans. « De façon probabiliste, il est possible d’affirmer que l’été sera plus chaud à Toulouse qu’à Brest. Cette prédiction est possible, car il existe un ordre caché dans les équations de la turbulence. Sur une grande échelle de temps, l’ordre se restaure », explique la chercheuse. Des études ont ainsi servi à analyser de façon statistique les circulations à grande échelle de l’atmosphère et de l’océan. Mais surtout, la façon dont un changement brutal sur quelques années risquerait d’influencer le climat en profondeur.

L’analyse de carottes de glace au niveau du Groenland a ainsi mis en évidence une série d’augmentations brutales de température de l’ordre de 5 à 6 °C sur une dizaine d’années5. Celle-ci est attribuée à un changement de la circulation océanique au niveau de l’Atlantique Nord. Circulation qui subit à nouveau un ralentissement aujourd’hui. « Nous commençons à nous demander si ces types de phénomènes ne sont pas la signature d’une transition de phase identique à celle observée en physique statistique lorsqu’une petite variation d'un paramètre peut déclencher une modification drastique (comme lorsque l’eau passe de l’état liquide à solide pour 1 °C de différence) », ajoute Bérengère Dubrulle.

Nos connaissances sur ces sujets progressent, mais les questions sont encore nombreuses. Néanmoins, l’analyse de la complexité et des systèmes désordonnés ne se limite pas à l’étude de la turbulence. Les découvertes réalisées depuis les années 1980 ont largement innervé différentes disciplines des mathématiques et de la physique.

Une ressemblance qui fait des vagues

L’analyse multifractale sert désormais à l’étude de tout type de signaux aléatoires. Stéphane Jaffard et ses collaborateurs l’utilisent pour l’analyse de séries temporelles du rythme cardiaque6. Ces outils permettent alors de distinguer les signaux représentatifs d’une personne saine de ceux d’un sujet ayant un problème au cœur. Cette approche permet donc de distinguer différentes catégories. Un résultat qui a capté l’attention d’utilisateurs surprenants tels que le musée Van Gogh à Amsterdam. « Le conservateur recherchait des outils de traitement d’images pour détecter des faux tableaux », explique le chercheur.

Toujours dans l’art, l’analyse multifractale a également servi à la classification d’importantes collections photographiques du Museum of Modern Art (MoMA) de New York. Le musée possède des séries de clichés pris par des Européens ayant émigré aux États-Unis dans les années 1930. Néanmoins, leurs auteurs ne sont pas toujours identifiés. Pour y remédier, une équipe de recherche, dont a fait partie Stéphane Jaffard, a proposé une classification basée sur l’analyse de la texture du papier utilisé.

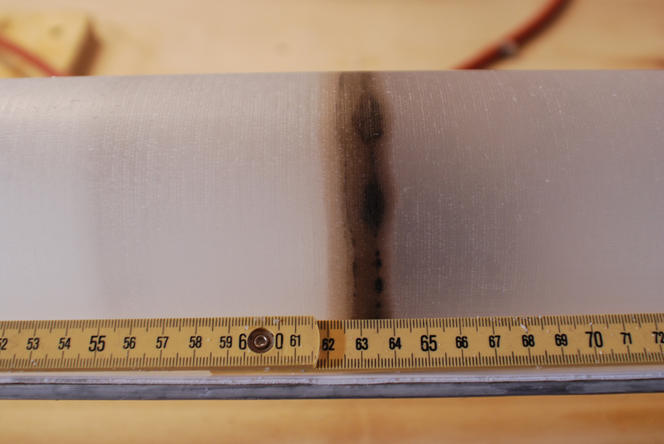

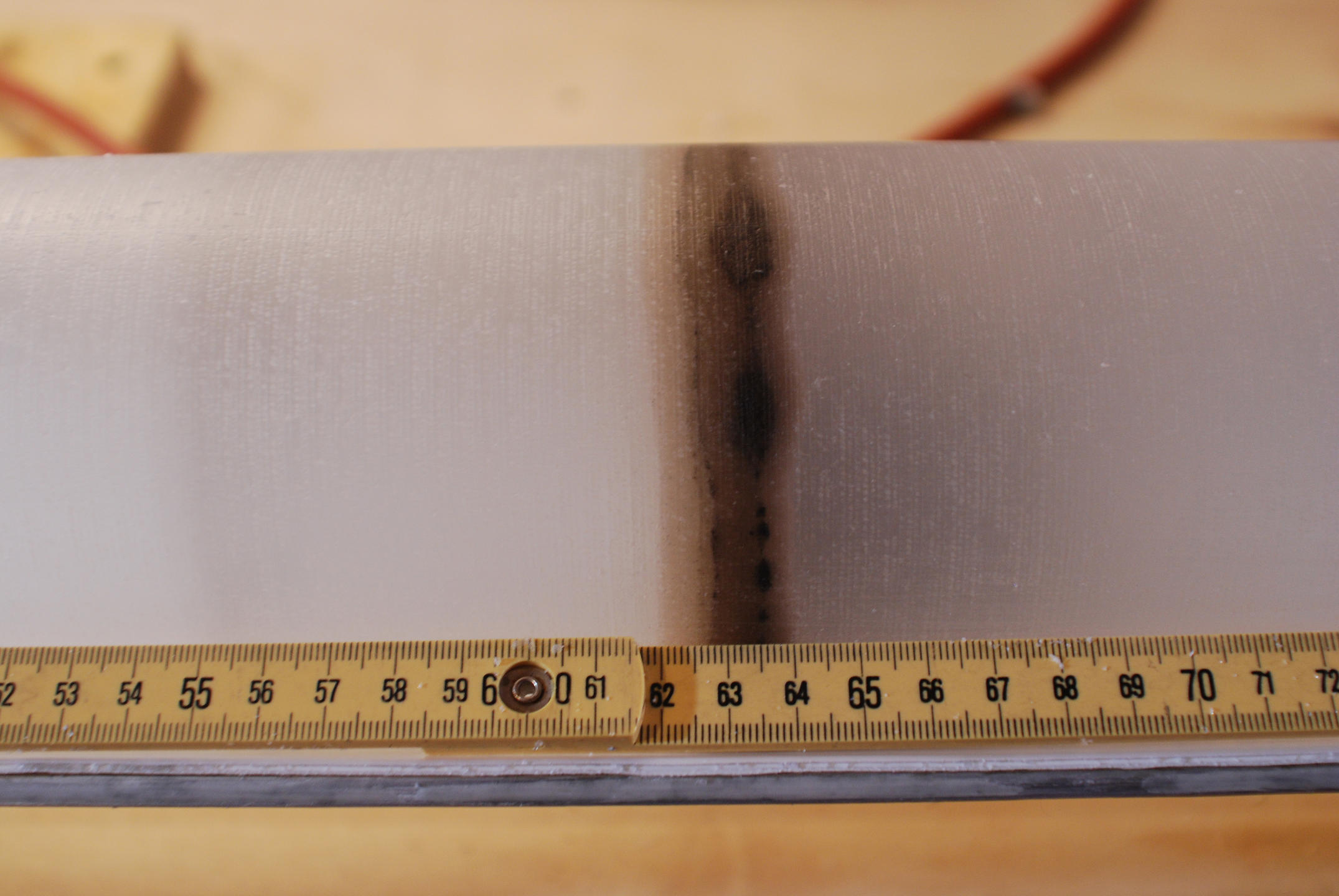

En pratique, les chercheurs prennent des photographies en lumière rasante des marges ou du dos des objets d’étude (peinture ou photographie). La caractérisation de la texture apporte des informations sur les intentions esthétiques et les pratiques de travail des photographes. « Nous avons utilisé des méthodes d’ondelettes consistant à décomposer un signal complexe pour analyser ses composantes à différentes échelles », précise Stéphane Jaffard. Cet outil d’analyse multifractale7 a d’ailleurs bien voyagé depuis ses origines, puisqu’il a d’abord été théorisé dans le cadre de la détection pétrolière !

Que ce soit pour les peintures ou les photographies, ces méthodes sont utilisées en boîte noire. Il n’est pas nécessaire de comprendre pourquoi elles fonctionnent aussi bien. Toutefois, d’autres applications plus sensibles nécessitent une meilleure connaissance des mathématiques sous-jacentes.

Des pixels d’os et des voxels de cerveau

« Nous utilisons l’analyse fractale en lien avec la modélisation aléatoire. Celle-ci est appliquée à des bases de données d’images afin de les comparer et de les séparer en catégories », explique Hermine Biermé, mathématicienne à l’Institut Denis Poisson8. La chercheuse a commencé sa carrière en s’intéressant au traitement d’images médicales afin d’améliorer le diagnostic de l’ostéoporose. Celui-ci est habituellement réalisé grâce à la combinaison de radiographies et d’examens de densitométrie osseuse qui permet d'évaluer la solidité des os. « Le but était alors de discriminer les patients sains de ceux atteints d’ostéoporose uniquement à partir des images de radiographie. Un examen peu cher et facile à mettre en œuvre », explique la chercheuse.

Par la suite, ces méthodes sont étendues à l’analyse de volumes via le traitement de données d’imagerie par résonance magnétique (IRM). Une tâche ardue puisque, plus il y a de dimensions, plus il y a de paramètres aléatoires et inconnus à prendre en compte. L’analyse de texture comme utilisée pour les photographies sert ici à détecter et à localiser des zones tumorales au sein du cerveau9. Or, toutes les tumeurs n’ont pas une forme bien définie et elles peuvent parfois se propager à travers plusieurs structures anatomiques. Leur diagnostic en est d’autant plus compliqué.

La détection consiste donc à dissocier les volumes cérébraux sains ou présentant une pathologie. Un véritable coup de pouce pour le diagnostic. Mais les prouesses des outils de la physique statistique ne s’arrêtent pas là.

La finance des grains de sable

La poursuite de notre voyage au cœur de l’aléatoire nous mène à la bourse. La finance est un système complexe au même sens que la météorologie. De petites causes peuvent donc entraîner de grands ou de petits effets à toutes les échelles sans que l’on puisse déterminer au préalable leur ampleur. « Si l’on cherche à identifier la nouvelle responsable d’une importante variation de prix au niveau des cours de la Bourse, on se rend compte que dans la majorité des cas, il ne s’est rien passé de spécial. Le système s’est affolé tout seul », décrit Jean-Philippe Bouchaud, directeur de la recherche du Capital Fund Management10 et spécialiste de la physique appliquée aux systèmes économiques et aux marchés financiers. La crise de 2008 en est un parfait exemple. Problème initialement confiné au marché des subprimes – un produit financier ne représentant qu’une petite portion des actions des banques américaines –, c’est une perte de confiance collective en la valorisation de ces produits qui a mis à mal la finance, puis l’économie réelle dans la foulée.

C’est pourquoi le chercheur s’intéresse particulièrement aux causes endogènes, c'est-à-dire propres au système financier. Pour l’académicien, la stabilité d’un marché est comparable à celle d’un tas de sable. Le hasard se cache dans l’élément déclencheur, le grain responsable de l’effondrement de la dune. « L’enjeu n’est pas de comprendre cet élément, mais les boucles de rétroactions, c'est-à-dire les interactions entre les acteurs des marchés qui s’ensuivent et entraînent une chute de prix », ajoute Jean-Philippe Bouchaud. Comprendre ce phénomène de cascade permettrait de réguler et de stabiliser les systèmes financiers lorsqu’ils s’emballent. Il serait en quelque sorte possible de changer les règles cachées, en cours de route.

Désormais, l’émergence d’outils d’intelligence artificielle devrait apporter de nouvelles opportunités à ce domaine de recherche. « Le machine learning (apprentissage automatique) permettra de découvrir des structures invisibles à l’œil nu à côté desquelles nous sommes passés jusqu’à présent. Ces nouveaux éléments viendront enrichir les modèles prédictifs existants », note le chercheur. Ironie du sort, les méthodes d’apprentissage automatique qui pourraient aider à mieux comprendre la complexité de la finance sont également des systèmes complexes dont les chercheurs veulent comprendre la complexité.

Boucler la boucle de la complexité

Retour avec Marc Mézard, qui cherche à mieux comprendre le fonctionnement d’algorithmes d’apprentissage. Ces outils d’intelligence artificielle font preuve de performances incroyables allant de l’aide au diagnostic médical à la reconnaissance d’images. Néanmoins, la façon dont ils parviennent à leur résultat est encore mal maîtrisée. Comme dans un système financier, un réseau de neurones profonds est un espace de très grande dimension. Il est composé de centaines de milliers de neurones artificiels dont les interactions sont définies par des milliers de paramètres ajustables. La phase d’apprentissage consiste à trouver la valeur de ces paramètres permettant à l’algorithme de faire une tâche précise : classifier des visages, identifier un chat, etc.

« L’algorithme trouve une valeur idéale pour un million de paramètres, mais on ne sait pas ce qu’il est en train de faire, l’expliquer, le contrôler, etc. Nous avons besoin de justifier ses décisions pour vraiment prendre en compte ses recommandations dans des cas pratiques sensibles », témoigne le chercheur. La théorie doit donc rattraper la pratique qui a fait des bonds de géant au cours des quinze dernières années. Peut-être suffira-t-il d’une toute petite idée pour initier des découvertes phénoménales qui nous permettront de mieux comprendre l’environnement très désordonné qui nous entoure. ♦

À lire aussi sur notre site :

Une même loi de croissance pour tous les êtres vivants ?

- 1. Ces travaux succèdent notamment aux modèles de cascade proposés par Benoît Mandelbrot pour modéliser la turbulence, publiés en 1972.

- 2. Unité CNRS/CEA.

- 3. Unité CNRS/Université Gustave Eiffel/Université Paris-Est Créteil Val de Marne.

- 4. Son sixième rapport d’évaluation s’achèvera en 2022 : https://www.ipcc.ch/languages-2/francais/

- 5. Ce sont les événements de Dansgaard-Oeschger, dont vingt-cinq se sont produits durant la dernière période glaciaire, le dernier remontant à environ 12 000 ans.

- 6. Une série temporelle de l’intervalle entre deux battements de cœur pendant 24 heures.

- 7. Issu d’une idée de Jean Morlet, ingénieur chez Elf Aquitaine dans les années 1980 et de sa collaboration avec des mathématiciens et physiciens dont Yves Meyer et Alain Arneodo.

- 8. Unité CNRS/Université d’Orléans/Université de Tours.

- 9. Ces travaux sont menés dans le cadre du laboratoire commun I3M entre le CNRS, l'université de Poitiers et l’industriel Siemens Healthineers SA.

- 10. Société privée de gestion alternative des portefeuilles financiers, pionnière des stratégies d'investissement quantitatives et systématiques.

Voir aussi

Auteur

Après des études en environnement à l'Université Paul-Sabatier, à Toulouse, puis en journalisme scientifique à l'Université Paris-Diderot, à Paris, Anaïs Culot a été attachée de presse au CNRS et collabore à présent avec différents magazines, dont CNRS Le Journal, I'MTech et Science & Vie.