Vous êtes ici

Des chercheurs à l’assaut du vote utile

Quels sont les problèmes spécifiques posés par les choix sociaux collectifs – quand on doit dégager une opinion « collective » optimale agrégeant les choix d’une foule de gens parmi plusieurs alternatives –, plus particulièrement en ce qui concerne les systèmes électoraux actuels ?

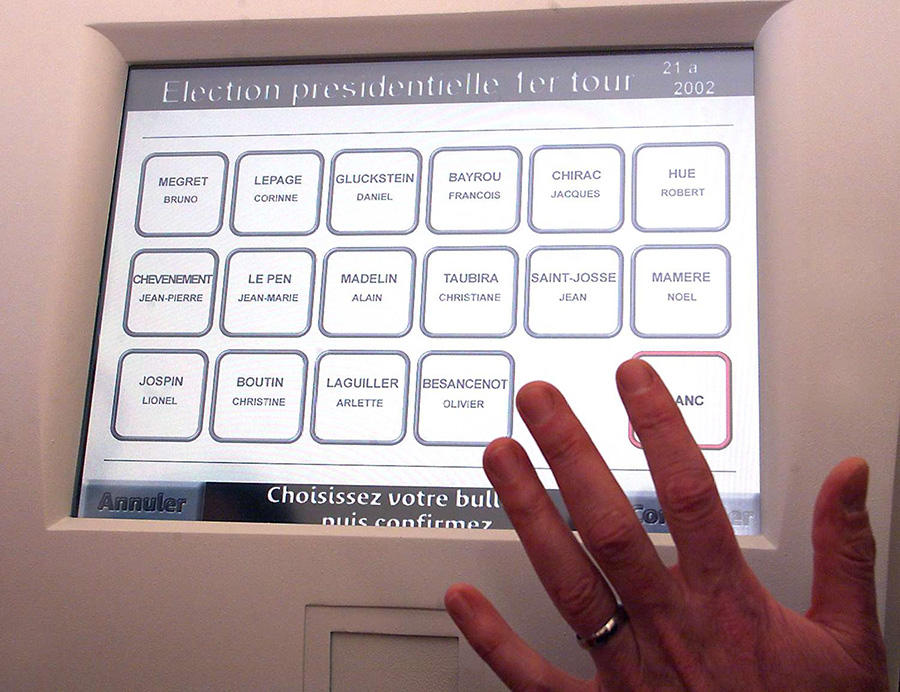

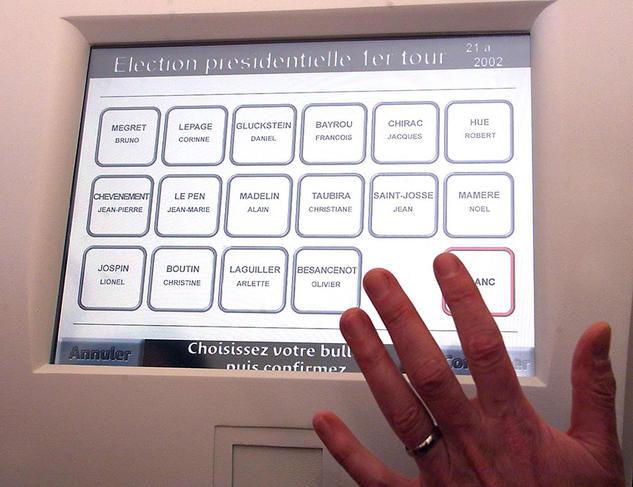

Rida Laraki1 : Notre démocratie est malade selon moi, et l’une des racines du mal est le système électoral qui empêche les électeurs de s’exprimer car il agrège mal les opinions. Quelques exemples suffisent pour le comprendre. En premier lieu, l’élection présidentielle de 2002 : 16 candidats dont 11 de gauche, Lionel Jospin (Parti socialiste) est éliminé au premier tour, victime de la dispersion des voix. Il aurait suffi que l’un ou l'une des « petits » candidats se désiste pour le qualifier au second tour. Depuis 2002, les électeurs sont prisonniers du vote utile. Les suffrages obtenus par un candidat mineur pouvant changer l’issue de l’élection, on sait que voter « honnêtement » est devenu risqué. Les votes pour un candidat ne sont plus des votes d’adhésion mais deviennent le résultat d’un calcul stratégique et facilement manipulable par de faux sondages.

Les partis politiques ont essayé de remédier à ce paradoxe en organisant des primaires. Cela n’a fait qu’empirer les choses, car le Parti socialiste (PS) et Les Républicains (LR) ont élu les candidats les plus radicaux pour leur propre électorat, ouvrant un boulevard au centre. Ainsi, le premier tour de l’élection présidentielle de 2017 a vu quatre candidats autour de 20 % des voix. Si, à gauche, Benoît Hamon s’était désisté, Jean-Luc Mélenchon aurait probablement été qualifié au second tour.

Malgré les affaires le concernant, François Fillon a refusé de se désister et Les Républicains n’avaient d’autre choix que de le soutenir en espérant un miracle. De ce jeu électoral a résulté un second tour inédit, même avec deux candidats très différents, 4 millions de bulletins blancs ou invalides, et 1,5 million d’électeurs de moins qu’au premier tour. Cela montre l’ampleur de la crise et l’intérêt de questionner notre mode de scrutin.

A priori, on pourrait penser que l’élaboration et la sélection des systèmes de vote est une affaire de philosophes et de responsables politiques. Que peuvent apporter les scientifiques et les mathématiciens ?

R.L. : La recherche d’un bon système de vote occupe en fait les chercheurs depuis plusieurs siècles. Ainsi, quelques années après la Révolution française, les académiciens et mathématiciens Jean-Charles de Borda et le Marquis de Condorcet ont déterminé la première étape nécessaire pour qu’un système soit bon : permettre aux électeurs de mieux s’exprimer. Ils ont proposé chacun un système où l’électeur classe les alternatives par ordre de préférence. Ils ont ainsi identifié les premiers paradoxes du vote.

Qu’entend-on au juste par « paradoxe du vote » ?

R.L. : Par exemple, qu’avec les mêmes opinions, changer de système de vote en modifie le vainqueur, ou encore qu’il est possible qu’aucun candidat ne puisse battre tous les autres dans un face-à-face : c’est ce qu’on appelle le paradoxe de Condorcet. Ces travaux ont aussi initié une nouvelle science sociale dont les mathématiques sont la pierre angulaire. Le fameux théorème du Jury de Condorcet2 a été démontré grâce à la théorie des probabilités et au théorème central limite.

Un siècle et demi plus tard, Kenneth Arrow a soulevé un problème encore plus grave en élaborant un outil pour différencier les modes de scrutin. Il a formulé des axiomatiques à partir de principes démocratiques simples. Cette approche était très novatrice, mais elle s’est aussi avérée quelque peu dévastatrice car Arrow y démontre qu’aucun des systèmes existants – hormis ceux relevant de la dictature –, ne permet d’échapper aux paradoxes pointés par Borda et Condorcet… Ce théorème dit « d’impossibilité » lui a valu le prix Nobel d’économie en 1972 ! Depuis ces travaux fondateurs, la recherche académique est extrêmement active en mathématiques, en économie, en informatique et en sciences sociales pour identifier d’autres axiomes et révéler d’autres paradoxes. Mais le test le plus important pour une théorie est sa capacité à résoudre les problèmes auxquels elle est supposée répondre, et il est donc indispensable d’accompagner la théorie de tests et de proposer des méthodes pratiques.

Quel est l’apport spécifique de Michel Balinski à la recherche sur les systèmes de vote ?

R.L. : Avec Michel Balinski, nous avons essayé de proposer une nouvelle approche des choix collectifs pour contourner le théorème d’impossibilité d’Arrow. C’est en parcourant un livre consacré à l’œnologie que nous avons eu l’idée de nous inspirer des pratiques d’évaluation des vins. On peut ainsi améliorer le bulletin de vote proposé par Arrow, Borda et Condorcet en donnant encore plus de liberté à l’électeur. Chaque électeur peut ainsi juger chaque candidat individuellement, en lui attribuant une mention comme les mentions du Baccalauréat : « excellent, très bien, bien, assez bien, passable, insuffisant, à rejeter ».

Grâce à l’approche axiomatique, nous avons isolé une méthode que nous avons appelée « le jugement majoritaire ». C’est la seule qui échappe aux paradoxes d’Arrow et de Condorcet, et qui est robuste face au vote stratégique. Nous avons travaillé en secret sur cette méthode pendant quatre ans avant que nos résultats soient dévoilés pour la première fois au Social Choice and Welfare Meeting à Istanbul en 2006. Notre livre, Majority Judgment, est ensuite paru en 2011 aux presses du MIT.

Qu’est-ce qui vous permet d’affirmer que ce vote par jugement majoritaire serait applicable dans « la vraie vie » ?

R.L. : Pour le valider, nous l’avons testé dans différents contextes : des concours œnologiques, des recrutements universitaires, des attributions de bourses, ou encore à la sortie des urnes durant les élections présidentielles de 2007, 2012 et 2017. Nous l’étudions désormais à plus grande échelle avec l’aide de l’association Mieux voter (dont Michel Balinski était membre fondateur, NDLR). Enfin, le parti La République En Marche (LREM) vient d’adopter le jugement majoritaire pour toutes ses élections internes (de l’élection des représentants locaux à l’élection du délégué du parti).

Par ailleurs ce système peut aussi être utilisé pour les algorithmes de sélection. Michel Balinski a travaillé avec Mourad Baïou3 sur l’affectation des étudiants aux universités, un problème pratique très important qui affecte la vie de milliers d’étudiants. L’association Mieux voter a ainsi proposé une amélioration de Parcoursup en permettant aux étudiants de pouvoir hiérarchiser les vœux avec les mentions « excellent, très bien, bien, assez bien, passable ». Cette modification donnerait plus de choix aux étudiants, accélérerait la convergence de l'algorithme, et améliorerait l’efficacité de l’affectation obtenue.

Quels sont les problèmes concrets que permet de régler la solution du jugement majoritaire que vous avez proposée avec Michel Balinski par rapport aux procédures de sélection politique actuelles ?

R.L. : Le jugement majoritaire échappe au paradoxe d’Arrow : rajouter ou retirer un candidat mineur ne change pas le vainqueur de l’élection. Il évite également le dilemme du vote utile : un électeur peut donner une mention positive à plusieurs candidats (par exemple Benoît Hamon et Jean-Luc Mélenchon en 2017, Lionel Jospin, Christiane Taubira, Lionel Mamère et Jean-Pierre Chevènement en 2002). Il donne aussi plus de choix et donc permet plus de démocratie. Par exemple en 2017, Les Républicains auraient pu proposer François Fillon et Alain Juppé sans risque, car les électeurs de droite auraient pu juger l’un excellent, l’autre très bien. Aussi côté Parti socialiste, Yannick Jadot n’aurait pas été obligé de se désister en faveur de Benoît Hamon.

Ce système permet de remédier à l’abstention en donnant un sens au vote blanc et ce même avec deux candidats comme au second tour de l'élection présidentielle. Avec lui, un électeur abstentionniste peut en effet participer et rejeter les deux, et un électeur qui vote blanc peut s’exprimer en donnant la mention « passable » ou « insuffisant » à l’un et rejeter l’autre. Sa méthode de calcul, une généralisation de la médiane construite grâce à la théorie des jeux, permet ainsi de neutraliser le vote stratégique.

Quelle est votre position sur la possibilité et l’intérêt d’implémenter ces nouvelles procédures dans des algorithmes informatiques, ainsi que sur les problèmes éthiques que cela pose ?

R.L. : L’informatique est primordiale à plusieurs niveaux : avec la méthode bi-proportionnelle utilisée en Suisse, les électeurs votent sur papier mais le calcul nécessite des algorithmes et des outils informatiques. Le jugement majoritaire peut se faire sur papier pour des élections politiques mais pour la vie quotidienne, un logiciel est indispensable.

Grâce à l'association Mieux voter, un logiciel est disponible pour voter en ligne avec la méthode du jugement majoritaire. La version actuelle est en train d’évoluer afin d’intégrer des outils qui garantissent plus de sécurité et d’anonymat sur ces données forcément sensibles, notamment par l’utilisation de Belenios (développé par le CNRS et Inria).

Les électeurs demandent plus de démocratie pour s’exprimer sur différents sujets. Cela nécessite le développement de nouvelles plateformes de vote électronique intégrant des méthodes de votes sophistiquées, et des technologies de pointe comme l’intelligence artificielle, la cryptographie ou la blockchain. L’informatique a un rôle essentiel à jouer pour améliorer notre démocratie et j’espère pouvoir y contribuer. Le jugement majoritaire est un bon début mais qui est loin d’être suffisant.

À lire

Majority Judgment, Measuring, Ranking, and Electing, Michel Balinski et Rida Laraki, MIT Press, 2011, 432 p.

Pour aller plus loin

International Conference on Mathematical Optimization for Fair Social Decisions: A tribute to Michel Balinski, 3 et 4 décembre 2019, au siège du CNRS.

À lire sur notre site

Quelles élections pour une meilleure démocratie ?

Le vote électronique, pour quelles élections ?

Comment l’orientation scolaire renforce les inégalités

- 1. Directeur de recherche CNRS en informatique au Laboratoire d'analyse et modélisation de systèmes pour l'aide à la décision (Lamsade – CNRS/Université Paris-Dauphine).

- 2. D'après ce théorème, dans la mesure où le citoyen moyen a moins d’une chance sur deux de se tromper, quand le nombre d’électeurs est grand, la somme de tous les votes des citoyens a très peu de chance d’être erronée.

- 3. Chercheur au Laboratoire d'informatique, de modélisation et d'optimisation des systèmes (unité CNRS/Univ. Clermont-Auvergne/Mines Saint-Etienne).

Voir aussi

Auteur

Lydia Ben Ytzhak est journaliste scientifique indépendante. Elle travaille notamment pour la radio France Culture, pour laquelle elle réalise des documentaires, des chroniques scientifiques ainsi que des séries d’entretiens.