Vous êtes ici

La science est-elle en crise ?

(Cet article est paru initialement dans le numéro 5 de notre revue Carnets de science)

Les théories du complot et fausses nouvelles, phénomène réinventé ces dernières années sous le nom de fake news, se propagent aujourd’hui grâce aux réseaux sociaux. Sommes-nous actuellement en pleine crise de la connaissance ?

Mathias Girel1 : Non, la science elle-même est plus robuste que jamais dans ses démonstrations, prédictions et applications, mais on peut en effet parler d’une crise de dévalorisation du savoir et de l’expertise. Il y a notamment une certaine défiance à l’égard de la science « réglementaire ». Et je pense que différents phénomènes actuels empêchent la majorité des gens, hors des cercles d’initiés que sont les chercheurs d’une discipline, de distinguer aussi aisément qu’auparavant une science robuste de toute autre démarche qui n’en a que l’apparence.

Qu’est-ce qui, aujourd’hui plus qu’auparavant, entretient le doute chez les non-spécialistes que nous demeurons tous, même en lisant une presse honnête ou en consultant des rapports d’experts ?

M. G. : En premier lieu, il y a un phénomène de surenchère qui consiste à survendre des avancées scientifiques dans certains médias, même sérieux. Quand le public voit une annonce sensationnelle se dégonfler au fil des jours, il devient plus difficile pour lui de savoir que croire par la suite… Une autre raison tient aux conflits d’intérêts dans l’expertise scientifique : les biais de financement y sont parfois criants selon de récentes études. L’une d’elles a révélé que les expertises financées par l’industrie agroalimentaire délivraient des résultats favorables au sponsor quatre à huit fois plus souvent que celles ayant des sources de financement indépendant ! Il y a aussi le phénomène du ghost writing mis en lumière récemment au sujet du glyphosate ainsi que dans l’industrie pharmaceutique : des chercheurs acceptent de signer des publications écrites par d’autres entités, des labos, des firmes, et par là de brader la valeur symbolique de leur institution. Enfin, il y a la question des fondations dites « philanthropiques » – on parle parfois de philanthrocapitalismeFermerMécénat opéré par des acteurs puissants en appliquant les principes du capitalisme. Bill Gates (ancien Pdg de Microsoft), Mark Zuckerberg (Pdg de Facebook), Gordon Moore (cofondateur d’Intel), Eric Schmidt (ex-Pdg de Google) investissent ainsi des centaines de millions de dollars dans des fondations qu’ils ont créées et qui financent la recherche sur les océans, les maladies génétiques, l’écologie, l’astronomie, etc. Ils sont donc devenus de nouveaux acteurs de la production scientifique dans le paysage de la recherche., pour souligner le fait qu’elles adoptent le mode de fonctionnement des entreprises à but lucratif –, certes bien inspirées, puisqu’elles ambitionnent d’éradiquer telle ou telle maladie, comme la poliomyélite, mais dont l’action perturbe en profondeur le jeu ordinaire de la recherche.

Comment ce philantrocapitalisme, financé par le privé, perturbe-t-il le paysage de la recherche aujourd’hui ?

M. G. : L’agenda des recherches est fixé par l’état-major des sociétés philanthropiques. Autrement dit, une poignée de personnes peut décider de se désengager d’un champ de recherche du jour au lendemain si les conditions de visibilité ou d’obtention de résultats à court terme ne sont pas maximales, ce que les acteurs publics de la recherche en France (CNRS, Inserm, Inra, etc.) ne font pas en général, car ils fonctionnent avec des états-majors plus étendus, des comités nationaux et des échéances plus longues. Par ailleurs, vous avez plus de chances d’obtenir un financement de la part de ces mécènes si vous travaillez sur des sujets qui répondent à leurs critères (par exemple une science photogénique ou facile à médiatiser, NDLR), comme les fonds marins, l’astrophysique, le sida ou le cancer. Certains auteurs, mais cela reste à vérifier, considèrent même qu’il y aurait des biais dans les financements selon les maladies : par exemple, aux États-Unis où la philanthropie capitaliste est très forte via les fondations, il serait, selon ces auteurs, plus facile de faire financer des recherches sur le mélanome, qui inquiète les populations blanches, plutôt que sur l’anémie falciformeFermerMaladie génétique liée à une anomalie de l’hémoglobine et donnant aux globules rouges une forme de faucille qui les empêche de passer dans les capillaires, les plus étroits des vaisseaux sanguins. qui touche surtout des populations noires.

Ces phénomènes qui brouillent le discours scientifique (surenchère médiatique, conflits d’intérêts dans l’expertise et philanthrocapitalisme) n’ont-ils pas toujours existé ?

M. G. : Oui, dans une certaine mesure, mais leur ampleur est plus grande aujourd’hui. Ainsi, les réseaux sociaux accentuent le phénomène de surenchère dans la presse, qui en a hélas parfois besoin, ne serait-ce que pour survivre. Les conflits d’intérêts dans l’expertise, certes décrits par le physicien Richard Feynman dès les années 1970, sont sans doute révélés plus massivement au grand public. Quant au financement privé de la recherche par le philanthrocapitalisme, il atteint des niveaux très supérieurs à ceux des XIXe et XXe siècles. Cela permet de comprendre que nous évoluons aujourd’hui dans une sorte de zone grise qui rend difficile l’attribution d’intentions à certains acteurs de la recherche et de sa diffusion. Ou plutôt, nous sommes conduits à nous poser cette question de l’intention, alors que nous ne devrions nous intéresser qu’à la vérité ou la fausseté des publications, expertises ou témoignages.

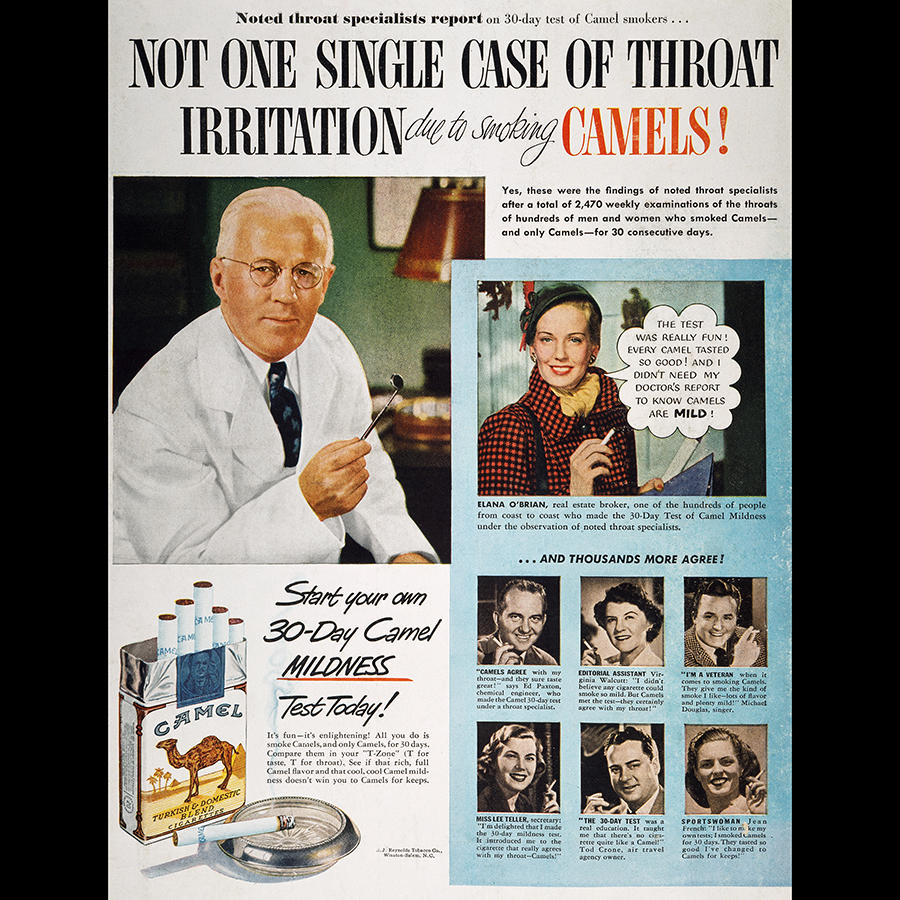

À propos d’intentions cachées, on peut citer l’exemple des cigarettiers : dans les années 1950 et durant des décennies, ils ont réussi à faire douter de la dangerosité du tabac en finançant des études auxquelles on ne peut rien reprocher scientifiquement…

M. G. : Exactement. Pour expliquer le cancer du poumon, ils ont tout simplement financé des recherches sur d’autres causes que la fumée de cigarette : les virus, l’influence des poussières, des déterminants génétiques, etc. Dans Golden Holocaust, publié en 2012, l’historien des sciences Robert Proctor a montré qu’il est très difficile d’attaquer ces études ou de les écarter au nom des arguments traditionnels sur la démarcation entre science et non-science parce que tous les critères classiques sont réunis : les études émanent bien de scientifiques, elles s’appuient effectivement sur un formalisme et une méthode scientifiques, elles sont publiées dans des revues à comité de lecture et donc soumises à l’examen de leurs pairs, elles répondent à l’argument poppérien sur la réfutabilitéFermerPour le philosophe des sciences Karl Popper (1902/1994), une théorie est scientifique si l’on peut déduire de l’ensemble des propositions qui la constituent au moins un énoncé empirique qui la réfuterait s’il était vérifié. Par exemple, « si l’on n’observait pas une déviation au voisinage du Soleil de la lumière provenant des astres lointains, la théorie générale de la relativité serait insoutenable »., etc.

Seule l’intention qui guide ces recherches permet d’en comprendre le caractère « pathologique » : elles ont été financées dans le seul but d’écarter, d’étouffer ou de minimiser la cause la plus importante du cancer du poumon qui est le tabagisme. Ce type de décryptage prend du temps et montre que les critères de scientificitéFermerEnsemble de critères permettant de démarquer une activité scientifique d’une autre qui ne le serait pas. Parmi eux : la réfutabilité, l’évaluation par les pairs, la publication dans des revues à comité de lecture, la réplication des résultats. dont nous disposons aujourd’hui pour distinguer une science pathologique d’une science « normale » sont moins efficaces qu’avant.

La réplication des résultats, qui fait partie des critères de scientificité, connaît justement une crise depuis quelques années…

M. G. : Il y a en effet une crise de la réplicabilité des résultats actuellement, en particulier en biologie, en psychologie sociale et en médecine. Est-ce le résultat de la pression que subissent les chercheurs pour publier vite (l’injonction « Publish or perish ! », NDLR) ? Ou bien est-ce le symptôme d’une détérioration de la qualité des recherches faites aujourd’hui ? Ou encore est-ce le signe que, finalement, la réplicabilité d’une expérience n’est pas un critère aussi déterminant qu’on le croyait pour évaluer la scientificité d’une recherche ? Le phénomène soulève beaucoup de questions. En tout cas, il faut se méfier de certaines interprétations qui n’ont d’autre but que de dénigrer les sciences en général, comme on l’a vu récemment avec des attaques qui ciblaient les agences de protection de l’environnement. Enfin, je crois qu’il faut rappeler que la réplicabilité n’est pas un critère ultime : les campagnes de collecte de données en conditions réelles, hors laboratoire, ne sont pas toujours réplicables, tout comme les études réalisées sur des cohortes, de patients par exemple, durant des décennies. Il serait risqué de les écarter au motif qu’elles ne sont pas réplicables.

Comment améliorer ces critères de scientificité qui permettent de distinguer science et pseudoscience ?

M. G. : Que ce soient des publications, des rapports scientifiques ou des expertises, on ne peut plus se contenter de l’examen d’une publication seule ou d’un rapport isolé. Certes, cela permet de repérer les cas manifestes de sciences fausses, mais je pense qu’il serait utile de reconstituer l’agenda dans lequel les recherches s’inscrivent. Cet agenda permet d’accéder à leur contexte, à savoir si elles appartiennent à un programme qui s’étend sur dix ou vingt ans, si elles comprennent l’exploration d’autres causes, si elles prennent en compte la multifactorialité d’un phénomène, quelle est la trajectoire des acteurs du domaine, ou l’état des connaissances durant les décennies précédentes. Seules les sciences humaines et sociales, en particulier l’approche historique, peuvent combler ce manque des sciences de la nature, et aider à mieux défendre la connaissance et la scientificité d’un domaine. Bien entendu, ces analyses sur le temps long ne sont pas l’apanage des chercheurs : les journalistes d’investigation ont maintes fois réalisé des enquêtes exemplaires.

Les cigarettiers ont fait diversion, le lobby du sucre a accusé les matières grasses au sujet des maladies cardio-vasculaires… Quel autre exemple de production intentionnée de science « pathologique » peut-on citer ?

M. G. : J’ajouterais les denialists (les « négateurs ») du réchauffement climatique qui utilisent les outils mathématiques, notamment les corrélations statistiques, et tiennent des propos qu’on ne peut pas toujours écarter facilement avec des arguments standards sur la véracité de la preuve, même si l’immense majorité de la science publiée les contredit. Parmi eux, le physicien américain Fred Singer s’est employé à trouver des défauts aux travaux du Giec2 ou des autres communautés de climatologues. Il me semble que, lorsque sur une échelle de cinq ou dix ans, un chercheur, un think tank, un laboratoire ou une institution ne produit que de la preuve négative, de la réfutation de preuves scientifiques, sans jamais isoler une cause nouvelle ou conduire à des prédictions inédites, on peut lui attribuer une démarche dénégatrice. L’approche historique que je propose ne se substitue pas aux critères traditionnels utilisés par la communauté scientifique, mais elle fournit un outil supplémentaire d’analyse sur un temps long. La philosophe Elizabeth Anscombe utilise une image pour illustrer la question de l’intentionnalité : un homme bouge le bras pour actionner une pompe qui remplit la citerne d’une maison, or l’eau est empoisonnée et la maison est occupée par des chefs nazis dont la disparition éviterait une partie des horreurs de la guerre. Si on observe la scène en resserrant la focale sur le seul mouvement musculaire de l’homme, on ne peut pas comprendre son action.

Il faut donc élargir la focale pour comprendre les intentions cachées…

M. G. : Oui, mais pas trop ! C’est justement le travers des complotistes : ils ont une vision si large des actions qu’ils n’arrivent plus à en avoir une perception ordinaire. Absolument tout ce qui concerne le sujet auquel ils s’intéressent est relu sous le prisme d’une intention cachée. La signification ordinaire des actions n’existe alors plus pour eux.

Comment alors ne pas tomber dans le travers complotiste ?

M. G. : Je n’ai pas de recette miracle… Mais on peut souvent démonter les théories du complot en revenant à la définition même du complot : il s’agit de l’« action explicitement coordonnée d’un petit groupe agissant en vue de fins moralement ou légalement répréhensibles à l’insu du plus grand nombre »3.

Chaque terme contribue à démontrer que les conspirations de grande envergure sont totalement improbables, et ce pour trois raisons : premièrement, la condition « à l’insu du plus grand nombre » signifie que l’action doit rester secrète (au moins jusqu’à sa réussite), ce qui est d’autant plus difficile que le « groupe » en question est large. Il semble donc improbable que « les francs-maçons », « les juifs », « les médias », etc., figures habituelles agitées par les complotistes, soient en mesure de garder de tels secrets. Deuxièmement, il faut que le collectif en question poursuive « une action coordonnée », donc que ses membres aient une intention commune et la mènent à bien. La comparaison est triviale, mais voyez déjà la complexité pour organiser une fête de famille ! Alors, avec 1 000 ou 10 000 acteurs… Plus sérieusement, cela renvoie à la question de la distribution de l’intention sur le collectif.

Ardent critique des théories du complot, le philosophe des sciences Karl Popper considérait que les phénomènes sociaux ne sont que l’agrégation d’intentions individuelles et ne peuvent pas être expliqués par une intention collective. Il nous faut pourtant reconnaître qu’il existe bien de vastes actions intentionnelles, d’ONG, de gouvernements, etc. et qu’il y a donc des domaines où l’on peut effectivement attribuer des intentions à des collectifs… Ce deuxième critère constitue donc bien une condition improbable, mais pas impossible.

Quelle est la troisième raison pour laquelle les complots d’envergure sont improbables ?

M. G. : Elle réside dans le décryptage mis en œuvre par des personnes extérieures qui veulent savoir au nom de quoi vous agissez. Dans le cadre d’un complot de grande envergure en effet, les actions opérées ont forcément des effets publics. Il est très difficile pour elles de résister à ce type de décryptage. Celui de Robert Proctor, qui a mis au jour les intentions cachées des cigarettiers, repose sur 80 millions de pages d’archives (mises à disposition par les cigarettiers à partir des années 1990) et permet de remonter à des acteurs puissants qui ont financé certains secteurs de la recherche. Face à ces poids lourds, il fallait une démonstration irréprochable : Proctor a été convoqué au tribunal des dizaines de fois en qualité d’expert et n’a jamais été démenti. Bien sûr, rappelons que pour qu’il y ait complot, il faut aussi prouver que les intentions mises en lumière ont causé les faits observés, ce qui n’est pas toujours le cas. Ainsi, si je souhaite très fort, seul devant mon téléviseur, que tel chanteur gagne à l’Eurovision et que cela se produit, mon intention n’est en rien la cause du phénomène observé.

Cette démarche de remise en question de la science ne risque-t-elle pas de nuire à son image déjà dégradée aux yeux du grand public ?

M. G. : Je ne le crois pas. Comme je l’expliquais, il ne s’agit pas de se poser ces questions d’une manière complotiste qui aboutirait à un scepticisme noir où on ne croirait plus quiconque ni aucune autorité. Il s’agit plutôt de réaliser notre chance d’avoir ces organismes de recherche, de protection de la santé, de l’environnement, etc. tout en veillant à identifier leurs faiblesses qui évoluent avec le temps et les différents contextes. La production d’ignorance, qu’il s’agisse de science pathologique, de théories du complot ou de fake news, nous conduit à réfléchir à la place de la connaissance dans nos sociétés, à la valeur que nous lui attribuons et à la manière dont les institutions que nous mettons en place sont conscientes à la fois de leurs angles morts et des types d’attaques qu’elles risquent de subir. Je suis bien entendu convaincu que la connaissance est absolument centrale pour une citoyenneté éclairée qui peut discuter et critiquer de manière rationnelle et raisonnable tout sujet, y compris les mesures politiques. ♦

À lire sur notre site

«L’invention la plus dangereuse de l’histoire»

À lire

►Science et territoires de l’ignorance, de Mathias Girel, éditions Quae, 2017.

►Golden Holocaust – La Conspiration des industriels du tabac, de Robert N. Proctor, éditions des Équateurs, 2014.

Voir aussi

Auteur

Journaliste scientifique, autrice jeunesse et directrice de collection (une vingtaine de livres publiés chez Fleurus, Mango et Millepages).

Formation initiale : DEA de mécanique des fluides + diplômes en journalisme à Paris 7 et au CFPJ.

Plus récemment : des masterclass et des stages en écriture...