Vous êtes ici

Les algorithmes menacent-ils la démocratie?

Naguère inconnu du grand public, le terme « algorithme » cristallise maintenant sur lui les espoirs et les craintes suscitées par la révolution du big data. Pourtant, la notion d’algorithme a été définie et utilisée par les mathématiciens et les informaticiens bien avant de devenir un fantasme médiatique.

Vous avez dit algorithme ?

Un algorithme n’est ni plus ni moins qu’une suite finie d’instructions qui va permettre de résoudre un problème, sans nécessiter de réflexion ou d’inventivité de la part de celui qui l’exécute. Dans notre vie quotidienne, nous utilisons tous des algorithmes sans forcément nous en rendre compte : par exemple, quand nous changeons une roue de voiture ou lorsque nous préparons une pâte à crêpes à partir d’une recette. Les développeurs informatiques ont ainsi à leur disposition des centaines d’algorithmes permettant aux machines de réaliser des calculs géométriques, des simulations d’ondes sismiques, de calculer le plus court chemin entre deux points sur une carte, etc.

Un exemple simple d’algorithmes auxquels mathématiciens, informaticiens et plus récemment les moteurs de recherche ont toujours prêté une attention particulière : les algorithmes de tri. Comme leur nom l’indique, ces derniers sont des méthodes permettant de trier et d’ordonner de manière automatique les éléments d’une liste selon des critères prédéterminés : ordre alphabétique, taille des mots ou toute autre propriété associée aux éléments de la liste, telle que par exemple un score de popularité.

Le plus basique de ces algorithmes est probablement le tri par sélection. Un algorithme de tri alphabétique par sélection d’une liste de noms peut se décrire par cette suite d’instructions :

1/parcourir les noms un par un,

2/trouver celui qui est le premier dans l’ordre alphabétique,

3/l’intervertir avec le premier nom,

4/reprendre l’étape 1 sur le reste de la liste jusqu’à ce que la liste soit entièrement triée.

Appliquons cette méthode au tri de la liste : Jean, Fatima, Kévin, Cécile, Anne. Je parcours les noms un par un, trouve celui qui est le premier dans l’ordre alphabétique (Anne) et l’intervertis avec le premier nom (Jean), j’obtiens Anne Fatima Kévin Cécile Jean. Je m’intéresse maintenant à la liste à partir du second élément, je la parcours, trouve le premier nom dans l’ordre alphabétique (Cécile) et l’intervertis avec le second nom (Fatima), j’obtiens Anne Cécile Kévin Fatima Jean. Je fais de même pour la liste à partir du troisième, puis du quatrième élément. À la fin, ma liste est triée !

Ce tri par sélection fonctionne très bien, mais il nécessite un nombre d’opérations et donc un temps de calcul qui quadruple quand la taille de la liste d’entrée double ! Il existe toutefois des algorithmes de tri bien moins gourmands. L’algorithmique est la science de la conception et de l’analyse des algorithmes : les chercheurs tentent de produire des algorithmes les moins gourmands possible en temps, en mémoire, ou, selon une préoccupation d’actualité, en énergie.

Le choix des critères

Le tri des éléments d’une liste par ordre alphabétique est une opération parfaitement définie mathématiquement. Pourtant, nous attendons de l’informatique des réponses à des questions bien plus floues : quelles sont les pages Web les plus pertinentes sur le gratin dauphinois ? ou sur l’Holocauste ? Qui est probablement un terroriste ou non ? Comment bien répartir les étudiants dans les filières ?

L’élaboration et la sélection de méthodes de tri adaptées à de grandes masses de données – qui constituent un sujet de recherche en soi – ont leur importance, mais le choix du critère de tri est peut-être encore plus crucial. En effet, quel score attribuerons-nous à une page Web pour dire qu’elle est plus pertinente qu’une autre ? Chaque moteur de recherche a sa propre recette. Parmi les critères les plus utilisés pour établir la qualité d’une page, il y a le nombre et la réputation des pages pointant dessus – l’idée étant qu’un document est probablement intéressant si de nombreux documents intéressants le mentionnent.

Un tel classement donne une impression d’objectivité, mais il est important de ne jamais oublier qu’à un moment ou un autre, ce sont des gens qui choisissent les critères de classement en fonction de leurs intuitions… et de leurs préjugés. L’apparente technicité du procédé peut ainsi masquer des choix politiques, ou encore des bricolages peu réfléchis. Des entreprises spécialisées en stratégie de référencement, ou « search engine optimization », proposent d’ailleurs des méthodes pour améliorer artificiellement le classement des pages, et les moteurs changent continûment leurs critères afin de les contrer.

L’apprentissage automatique

Il existe aussi des cas où les critères de classement ne sont plus directement fixés par les concepteurs du système, mais par apprentissage automatique. Par exemple, sur le Web, on peut observer les réactions des utilisateurs aux choix proposés et affiner automatiquement les critères.

À l’extrême, on trouve les techniques d’apprentissage profond (deep learning), où le modèle, très complexe, a un très grand nombre de paramètres qui sont ajustés au vu d’exemples représentatifs des propriétés que l’on désire apprendre. Par exemple, on montre au système un ensemble de photos associées à des noms d’objets qui y figurent. Au terme de l’apprentissage il est alors capable, à partir d’une photo qu’il n’a jamais vue, d’en fournir une description.

Là encore, en dépit d’une certaine objectivité des critères – qui ne sont cette fois pas choisis par un individu mais « émergent » des données –, la façon de présenter les données, le choix et l’ajustement des méthodes d’apprentissage ont une influence importante sur le type de classement que l’on obtiendra et sont l’affaire de spécialistes qui doivent maîtriser tant l’apprentissage automatique que le domaine d’application. Même pour des spécialistes, il n’est d’ailleurs pas forcément possible de comprendre et d’expliquer les critères qui ont été effectivement retenus par l’apprentissage automatique.

Une transparence nécessaire

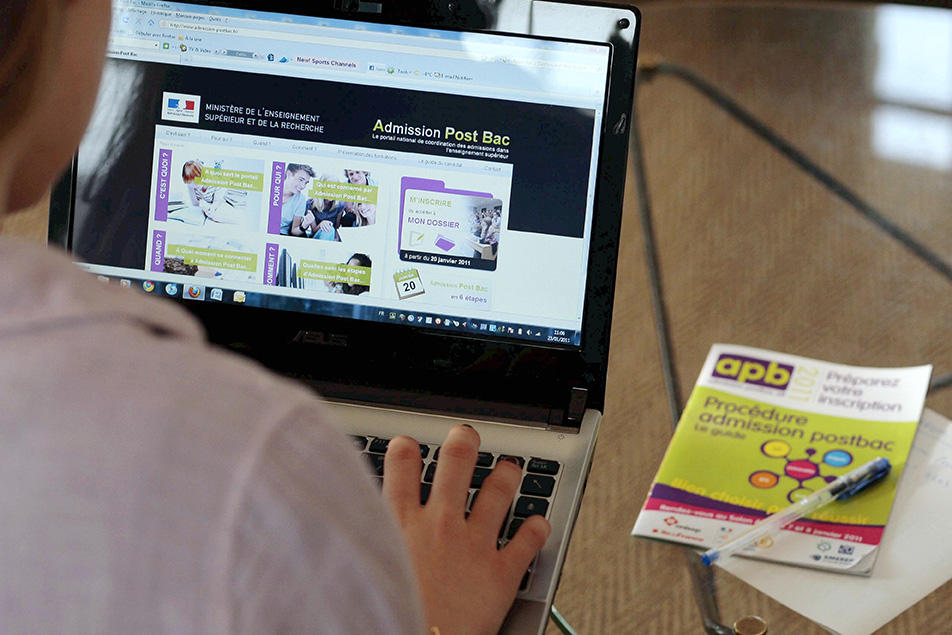

L’État de droit suppose que le citoyen connaisse d’avance les règles qui lui seront appliquées et qu’il puisse contester la façon dont elles sont appliquées, ce qui devrait exclure l’utilisation d’algorithmes opaques opérant sur des données indisponibles. Pourtant, on vient de le voir, il existe quantité de cas où un traitement automatisé obscur détermine ce à quoi nous avons accès, qu’il s’agisse par exemple de l’admission des étudiants après le baccalauréat ou du choix des passagers aériens soumis à contrôle de sécurité approfondie. Le citoyen est alors privé de tout contrôle.

Le principal danger réside dans l’attrait que les solutions magiques ont pour les décideurs… mais aussi parfois pour les citoyens. On promet une méthode automatique, où il suffirait de collecter des données et d’appuyer sur un bouton pour avoir les réponses. La perspective de traiter de grands volumes avec de faibles coûts en personnel est alors si séduisante qu’on en omet les biais possibles, et les ajustements qu’ils nécessitent… ! Ainsi, dans le cas du repérage automatique de comportements suspects, on oublie souvent que, pour de simples raisons statistiques, une méthode même très précise appliquée à une population non ciblée, où les personnes recherchées sont rares, tend à produire plus de faux positifs (innocents soupçonnés à tort) que de vrais positifs.

L’application aveugle de critères déduits par apprentissage automatique peut conduire à des résultats indésirables. Par exemple, l’apprentissage pourrait établir (éventuellement par des critères indirects) que les auteurs de vols avec violence sont plus souvent issus de milieux défavorisés que de milieux fortunés, et donc qu’il faut éviter d’embaucher les personnes issues de milieux défavorisés. À grande échelle, il s’agirait évidemment d’une politique contre-productive (chômage renforcé dans certaines populations, donc exclusion et pauvreté, donc délinquance aggravée dans un cercle vicieux).

Il est vrai que nos administrations n’ont pas attendu l’informatique pour exiger des informations non pertinentes ou appliquer des décisions arbitraires et qu’un moteur de recherche, malgré ses imperfections, est une solution incomparablement plus puissante que les catalogues d’antan. Néanmoins, la transparence des critères de choix est une condition nécessaire du débat démocratique. Dans ce contexte, l’algorithme, le « c’est la machine qui a décidé » ne doit pas conduire à dissimuler des choix politiques inavoués.