Vous êtes ici

Vers un nouveau continent de la physique ?

La physique des particules est à un tournant de son histoire. D’un côté, le modèle standard (MS), l’édifice théorique qui décrit les particules élémentaires et les interactions qui constituent la matière en une poignée d’équations, et qui a vu ses prédictions vérifiées les unes après les autres avec un luxe de détails inouï. De l’autre, des physiciens convaincus que cette extraordinaire construction formelle ne peut constituer l’ultime théorie de la matière.

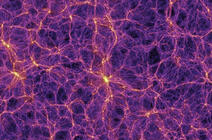

En effet, dès l’élaboration du modèle standard, dans les années 1970, ils ont compris que celui-ci souffrait d’importants problèmes de cohérence interne et qu’il contenait un trop grand nombre de paramètres fixés arbitrairement. On a ainsi découvert que les neutrinos, ces particules élusives dans lesquelles baigne l’Univers, ont une masse, ce que le MS ne peut actuellement expliquer. En outre, les cosmologistes ont montré que 95 % de l’énergie totale contenue dans l’Univers échappe totalement aux mécanismes et entités décrits par la théorie : on désigne ainsi comme matière noire et énergie sombre ces manifestations cosmologiques non expliquées par le modèle standard. Enfin, demeure le mystère de l’antimatière que l’on devrait observer dans les mêmes quantités que la matière, mais dont on ne détecte que des traces.

Dernier problème : l’incompatibilité formelle radicale entre la théorie quantique des particules avec la théorie einsteinienne de la gravitation, laissant apparaître un fossé théorique problématique entre les descriptions de l’infiniment grand et de l’infiniment petit. Afin de pallier les carences du MS, les physiciens cherchent de nouvelles pistes théoriques. Ils traquent désormais des observations non prédites par la théorie afin de les guider dans leur quête de nouvelles lois décrivant l’Univers matériel au-delà du MS.Dans ce contexte, établir un écart, même le plus ténu, avec les prévisions théoriques a le potentiel de révolutionner toute la physique.

Or l’un de ces signes s’est peut-être manifesté tout récemment dans le creuset de l’expérience Muon g-2, actuellement en cours au Fermilab, aux Etats-Unis. Le but de cette expérience : déterminer le moment magnétique – ou aimantation interne – d’une particule appelée muon, une sorte de cousin obèse de l’électron. Résultat, rendu public début avril : alors que la valeur de cette aimantation est désormais mesurée avec une précision supérieure à 0,5 partie par million (!), il s’avère qu’elle diffère de celle prédite à partir des équations du MS.

Certes, à ce stade, ce résultat n’est pas définitif. Mais s’il manque encore de signifiance statistique, il a pour lui sa double robustesse. Robustesse expérimentale tout d’abord, dans la mesure où il est compatible avec celui obtenu dans le courant de la précédente décennie auprès d’une autre expérience, en même temps que les physiciens du Fermilab sont parvenus à un summum de raffinement en termes de précisions de mesure. Et aussi robustesse théorique. De fait, calculer théoriquement le moment magnétique du muon relève de la gageure. Précisément, cette quantité dépend de l’interaction de la particule avec la myriade de particules dites virtuelles qui, à chaque instant, surgissent des soubresauts de l’espace-temps quantique et disparaissent avant même de s’être totalement matérialisées. Et nécessite pour être déterminée de prendre en compte l’effet de toutes les forces connues.

Pour y parvenir, plusieurs physiciens, dont Michel Davier, professeur émérite à l’Université Paris-Saclay au sein du Laboratoire de physique des 2 infinis - Irène Joliot-Curie (IJCLab)1 et membre de l’Académie des sciences, ont mis au point depuis 20 ans une méthode astucieuse couplant calculs et données expérimentales avec une précision sans cesse améliorée. Et pour être sûr de ne rien omettre, 130 spécialistes internationaux du domaine ont mis leurs efforts en commun au sein d’un groupe informel de recherche, dont les estimations les plus récentes, publiées en décembre 2020, ont servi de référence pour comparer au résultat expérimental. Ainsi, comme l’indique l’académicien, « notre prédiction théorique du moment magnétique du muon fait l’objet d’un très large consensus, ce qui rend le résultat de l’expérience Muon g-2 très excitant. Précisément, il n’y a qu’une chance sur 40 000 que la différence observée entre théorie et expérience soit le fruit d’un hasard statistique. »

Pour autant, la prudence reste de mise. D’une part, les physiciens des particules ne s’accordent sur le résultat d’une mesure qu’à la condition que le risque d’une fluctuation malencontreuse des données faussant cette mesure soit inférieur à 10-6. Autrement dit, pour conclure, il faudra au moins attendre que soient analysées les données prises par l’expérience après 2018. D’autre part, un autre groupe de théoriciens, dont Laurent Lellouch, au Centre de physique théorique2 de Marseille, par une méthode fondée sur des simulations numériques est parvenu tout récemment à une valeur du moment magnétique du muon plus proche de la valeur de Muon g-2. Selon Michel Davier, « cette valeur alternative, moins consensuelle, devra être confirmée, ou infirmée, de façon indépendante. En attendant, un enthousiasme prudent est donc de mise. » A suivre donc !

Traquer des écarts minimes

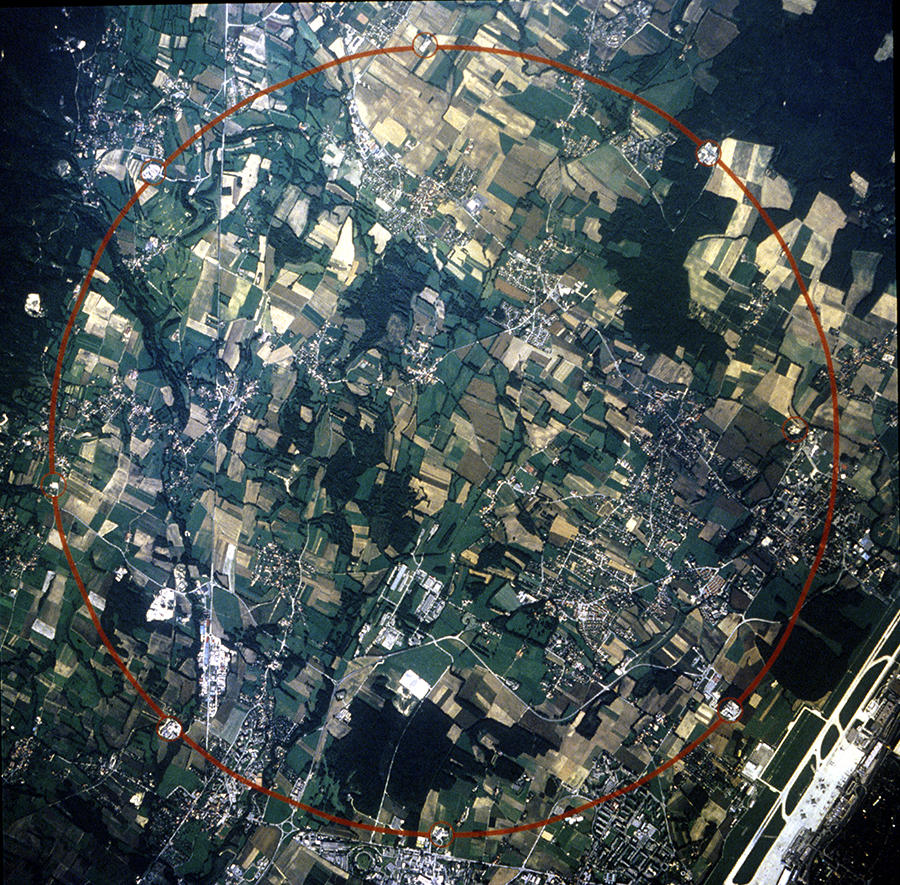

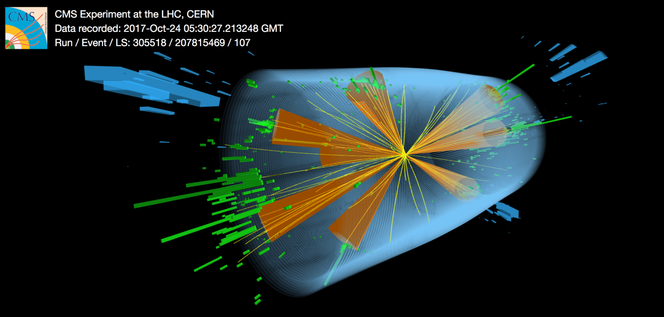

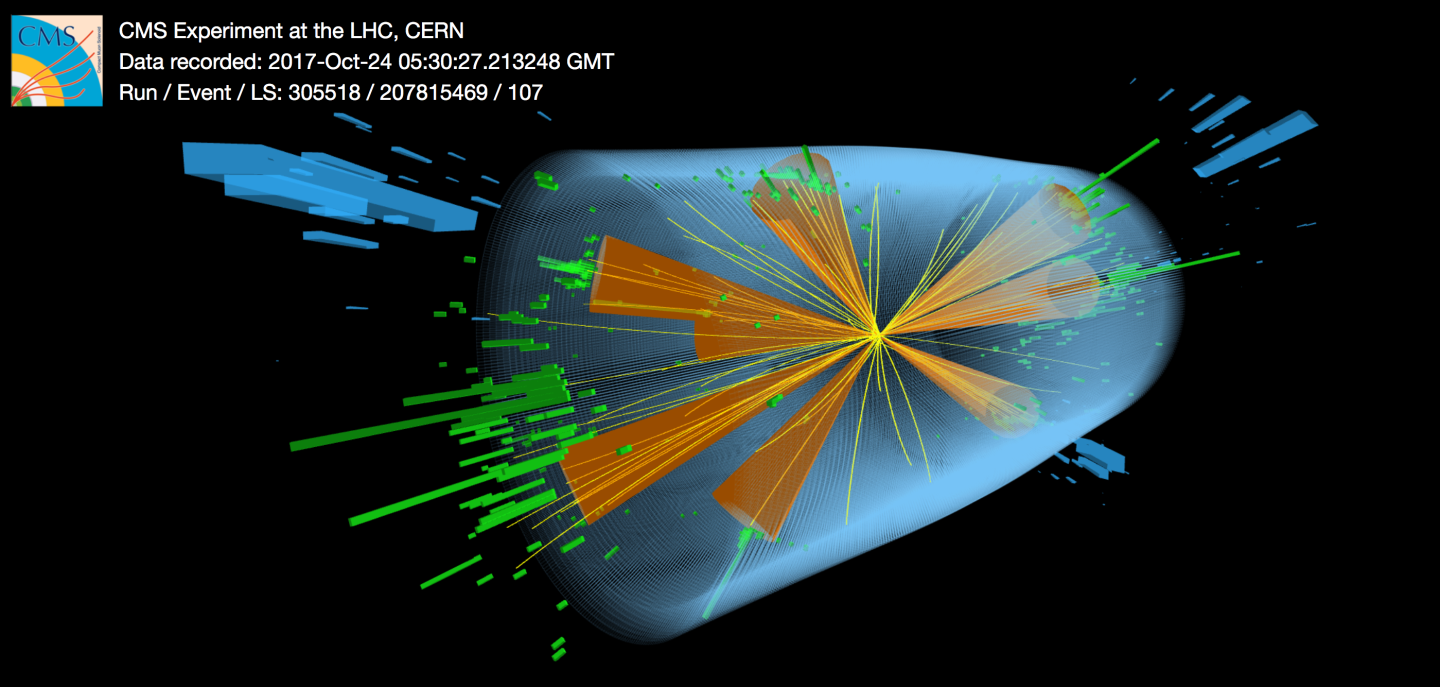

En attendant, les spécialistes du moment magnétique du muon sont loin d’être les seuls à traquer les failles du MS. C'est entre autres à établir ce genre d’écart que travaillent d’arrache-pied les physiciens du LHC (pour Large Hadron Collider, ou grand collisionneur de hadrons), l’accélérateur géant de particules du Cern, situé près de Genève à la frontière franco-suisse. Dans cet anneau de 27 kilomètres de circonférence, enterré 100 mètres sous terre, des protons accélérés à une vitesse proche de celle de la lumière entrent en collision environ 40 millions de fois par seconde avec un objectif : transformer l’énergie du choc en matière, en vertu de l’équivalence entre masse et énergie, et faire surgir du néant de nouvelles particules attestant l’existence d’une physique inconnue.

Dès 2012, les expériences Atlas et CMS, du nom de deux détecteurs géants installés sur le trajet des faisceaux de l’accélérateur, ont permis de découvrir le boson de Higgs. Elles ont ainsi parachevé le programme entamé quelque cinquante ans plus tôt visant à mettre en évidence la totalité des particules prédites par le MS. Le boson de Higgs, imaginé en 1964 pour expliquer l’origine de la masse de toutes les autres particules, avait besoin des énergies colossales mises en jeu au LHC pour pouvoir être observé. Mais dans l’esprit des promoteurs de l’accélérateur, la découverte du Higgs n’était que la première partie du programme imaginé pour le LHC. L’idée a été dès l’origine de pousser cette incroyable machine dans ses retranchements afin d’esquisser les contours d’un nouveau continent physique qui n’existe pour l’heure qu’au travers des spéculations des théoriciens.

Rechercher de nouvelles particules

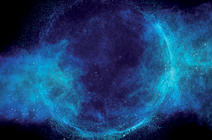

Pour cela, plusieurs stratégies sont actuellement mises en œuvre en parallèle dans Atlas et CMS. La première, la plus directe, consiste à rechercher dans leur creuset de nouvelles particules prédites par des théories qui vont au-delà du modèle standard. Lesquelles ? Certaines particules sont des candidates au statut de matière noire, d’autres permettent de corriger, sur le papier, certains défauts du MS, d’autres encore sont associées à de nouvelles symétries censées régir l’Univers, ou bien à l’existence de dimensions d’espace ou de temps supplémentaires. Et parfois tout cela à la fois ! Mais pour l’heure, les détecteurs sont restés muets.

Une deuxième stratégie consiste à étudier le plus précisément possible le boson de Higgs : la façon dont il interagit avec les autres particules ou avec lui-même, celle dont il se désintègre… dans le but de mesurer de petites différences par rapport à ce qui est attendu dans le strict cadre du MS. Ces dernières années, les expérimentateurs ont ainsi commencé à observer comment le Higgs se couple aux quarks bottom et top, au lepton tau, sorte de cousin obèse de l’électron, et aux bosons W et Z qui véhiculent l’interaction dite « faible ». Enfin, une dernière façon de pousser le modèle standard au-delà de ses limites est encore d’affiner les mesures de processus a priori parfaitement « standards », mais qui pourraient eux aussi révéler quelques désaccords entre théorie et expérience. Tout récemment, les expérimentateurs ont ainsi commencé à observer la production de quatre quarks top lors des collisions entre protons, un phénomène rarissime mais qui pourrait permettre d’accéder à une nouvelle physique.

Affiner les statistiques

Car en physique des particules, tout est affaire de statistiques. Pas d’autre solution que d’accumuler les collisions entre protons en attendant que, eu égard au caractère probabiliste de la mécanique quantique, les processus annonciateurs d’une physique « non standard » se soient produits en une quantité suffisante pour qu’un hypothétique signal émerge du bruit expérimental. L’accélérateur passera à plein régime entre 2022 et 2025, ce qui permettra de multiplier par un facteur deux à trois la quantité de données déjà accumulées. « On devrait ainsi commencer à entrevoir d’éventuelles différences entre la manière dont le Higgs se désintègre soit en paires de muons, soit en paires de leptons tau », s’enthousiasme Yves Sirois, directeur de recherche au Laboratoire Leprince-Ringuet (LLR)3 et membre de la collaboration CMS.

« Il est probable que l’on commence à avoir des mesures un peu plus précises sur la production de quatre quarks top », ajoute Marie-Hélène Genest, chercheuse au Laboratoire de physique subatomique et de cosmologie4, membre de la collaboration Atlas. Pour autant, les grandes manœuvres ne débuteront qu’à partir de 2027. D’ici là : mise à jour de l’accélérateur dans le but de quintupler le nombre de collisions par seconde, renouvellement ou ajout de détecteurs, changement des électroniques pour faire face au flux de données, évolution des stratégies d’analyse… le LHC sera soumis à une cure de jouvence qui le muera en HL-LHC ou LHC haute luminosité. À la clé : dix ans de fonctionnement supplémentaire qui démultiplieront les données disponibles ! « Aujourd’hui on ne dispose que de 5 % des données », note Yves Sirois. Le meilleur est incontestablement à venir !

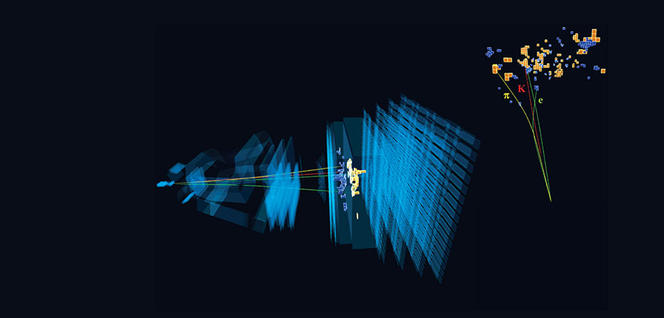

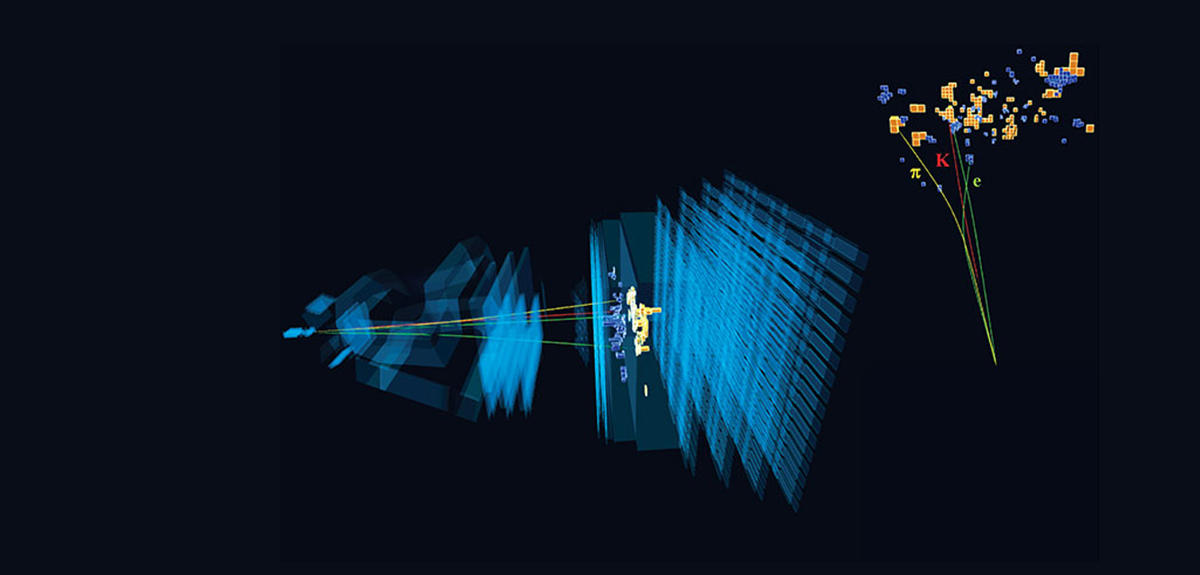

LHCb étudie les désintégrations exotiques

Outre Atlas et CMS, une autre expérience en cours au LHC tirera parti de la mise à jour des installations. Il s’agit de l’expérience LHCb, spécialement conçue pour étudier la désintégration de particules appelées mésons B, composées d’un quark bottom et d’un antiquark d’une des cinq autres saveurs possibles (up, down, charm, strange ou top). Les théoriciens s’attendent en effet à ce que les désintégrations de ces particules soient sensibles à des phénomènes non prévus par le MS. De fait, depuis sa mise en service, LHCb a mis en évidence un faisceau de phénomènes étranges, sous la forme de différences dans la manière dont certains mésons B se désintègrent en muons ou en électrons. « D’après le modèle standard, les deux processus devraient être parfaitement équivalents, ce qui d’après nos données n’est pas exactement le cas, explique Renaud Le Gac, directeur de recherche au Centre de physique des particules de Marseille (CPPM)5 et responsable de l’expérience LHCb pour la France. À ce stade, ces différences ne sont pas encore significatives, mais nous avons bon espoir de pouvoir conclure dans les prochaines années. »

Dernière bizarrerie en date, publiée en mars dernier : le résultat de la comparaison entre la désintégration d’un méson B en une particule appelée K accompagnée, soit de deux muons, soit d'une paire électron-positron. En intégrant les données accumulées entre 2010 et 2016, à celles collectées de 2017 et 2018, on cosntate qu'il n’y a qu’une chance sur 1 000 que la différence observée entre les deux processus résulte d’une fluctuation statistique sans signification. Les physiciens, habitués aux facéties du hasard, restent néanmoins prudents à ce stade : « Pour intrigantes qu’elles soient, ces différences ne sont pas encore suffisamment significatives, prévient Renaud Le Gac. Mais nous avons bon espoir de pouvoir conclure dans les prochaines années. »

Belle II : collisions propres et faisceaux de particules ultrafins

Pour y aider, les physiciens du Cern peuvent désormais compter sur leurs collègues de l’expérience Belle II, commencée au Japon en 2018. Tout comme LHCb, l’expérience vise à étudier la physique associée aux mésons B, mais avec une différence notable : plutôt que d’être engendrés par des collisions entre protons, les mésons de Belle II résultent de collisions entre des électrons et des positrons accélérés dans l’anneau du collisionneur SuperKEKB. Or ceux-ci, à l’inverse des protons qui sont composés de quarks, sont de véritables particules élémentaires. Résultat : des collisions beaucoup plus « propres », dont les « débris » sont beaucoup plus faciles à analyser qu’au LHC.

De plus, Belle II a la possibilité de créer des faisceaux de particules d’une extrême finesse – quelques dizaines de nanomètres contre quelques microns en général. Cela a permis l’année dernière d’établir le record mondial de collisions par seconde et par centimètre carré, d’où des perspectives inouïes en termes de quantité de données. En revanche, Belle II ne peut pas rivaliser avec le LHC quant à l’énergie impliquée dans les collisions, si bien que certains mésons B ne peuvent être étudiés actuellement qu’au LHC. Mais comme le résume Isabelle Ripp-Baudot, directrice de recherche à l’Institut pluridisciplinaire Hubert Curien6 et membre de la collaboration Belle II, « Belle II et LHCb sont absolument complémentaires et pourront ainsi, le cas échéant, s’appuyer l’une sur l’autre en cas de découverte extraordinaire. »

Belle II et LHCb vont également s’attaquer à ce que les spécialistes appellent la violation de la symétrie CP : une toute petite différence observée depuis les années 1960 entre certains processus impliquant des particules de matière et leur équivalent impliquant des particules d’antimatière. La problématique est d’importance car l’existence de cette minuscule asymétrie pourrait expliquer pourquoi notre Univers n’est composé que de matière, alors que le MS prédit une production égale de matière et d’antimatière. « Belle II et LHCb permettront d’atteindre des précisions ultimes dans ces mesures », prévient Isabelle Ripp-Baudot. Toutefois, les expériences Babar et Belle menées dans les années 1990 ont montré que la violation de CP au niveau des quarks est trop faible pour expliquer la totalité du déséquilibre observé entre matière et antimatière.

T2K en renfort sur la violation de symétrie CP

Pour résoudre cette énigme, les physiciens regardent désormais du côté des neutrinos, ces particules si élusives que 60 milliards d’entre elles traversent chaque centimètre carré de notre planète par seconde, sans laisser la moindre trace. En 1998, les physiciens ont mis en évidence que les trois neutrinos connus – électronique, muonique et tauique – ont l’étrange propriété de se transformer les uns dans les autres. On dit qu’ils oscillent. Cette propriété est aussi une condition nécessaire pour que ces particules violent la symétrie CP.

Plusieurs expériences se sont donc attaquées à la mesure de la violation de CP dans le secteur des neutrinos, en particulier l’expérience T2K, conduite au Japon. Dans un dispositif s’étendant sur plusieurs centaines de kilomètres, celle-ci observe la transformation de neutrinos muoniques en neutrinos électroniques.

Les derniers résultats, publiés en avril 2020, indiquent que les neutrinos oscillent plus souvent que les antineutrinos du même nom. Ainsi, en l’absence de violation de CP, les expérimentateurs s’attendaient à détecter 68 neutrinos et 20 antineutrinos ; or ils en ont détecté respectivement 90 et 15. Comme l’explique Michel Gonin, directeur de recherche CNRS au LLR et responsable France de T2K : « Ces résultats, s’ils ne constituent qu’une indication, semblent montrer non seulement qu’il y a bien violation de CP dans le secteur des neutrinos, mais que de surcroît cette violation pourrait prendre la valeur maximale possible. »

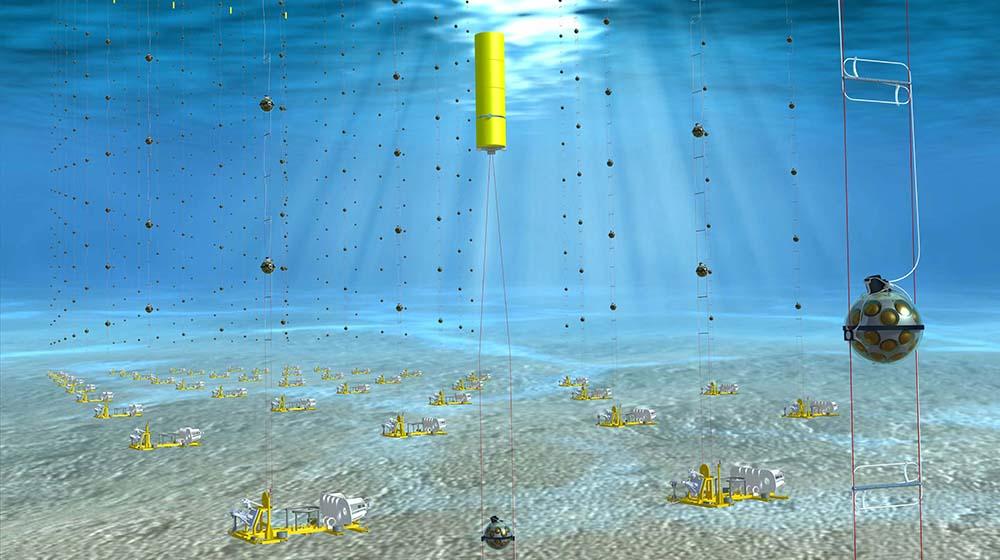

KM3NeT-ORCA mesure la hiérarchie de masse

Quoi qu’il en soit, l’expérience qui succédera à T2K est en cours de préparation depuis avril 2020. Bénéficiant d’un accélérateur producteur de neutrinos plus puissant et surtout du volume de détection de 1 000 millions de litres du détecteur Hyper-Kamiokande (contre 50 millions pour Super-Kamiokande, le détecteur utilisé dans T2K), l’expérience commencera en 2027 et devrait permettre de conclure dans le courant de la prochaine décennie. Les neutrinos n’auront pas pour autant livré tous leurs secrets. De nombreux chercheurs considèrent en fait que ces particules constituent aujourd’hui la principale voie d’accès à une physique radicalement nouvelle. Et pour cause : si les neutrinos se transforment les uns dans les autres, la théorie est formelle, c’est qu’ils possèdent une masse. Or d’après le MS, c’est tout simplement impossible. Cette masse est si minuscule qu’il semble difficile de pouvoir la mesurer directement.

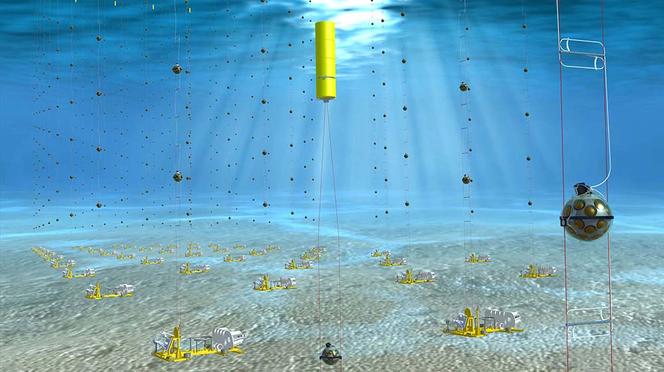

Dans un premier temps, les physiciens visent à déterminer ce qu’ils appellent la hiérarchie de masse, c'est à dire savoir quel neutrino est le plus lourd et quel neutrino est le plus léger. De la nature de cette hiérarchie dépendent les extensions possibles au MS permettant d’expliquer la violation de symétrie CP. L’objectif de l’expérience KM3NeT-ORCA, qui commence à enregistrer ses premières données, est donc d’étudier cette hiérarchie de masse des neutrinos. Ainsi, lorsqu’elle atteindra son plein régime, plus de 66 000 capteurs de lumière immergés à 2 450 mètres de profondeur et à 40 kilomètres au large de Toulon, auront pour tâche de capter les neutrinos produits dans l’atmosphère terrestre de « l’autre » côté de la Terre, après leur traversée de notre planète ! Comme le détaille Mathieu Perrin-Terrin, chercheur au CPPM et membre de la collaboration KM3NeT, « l’oscillation des neutrinos lors de leur traversée d’une couche de matière dépend de la hiérarchie de masse, et ce d’autant plus que l’épaisseur de cette couche est importante. D’où la configuration de l’expérience ».

SuperNEMO et la double désintégration bêta

Par ailleurs, les scientifiques voudraient comprendre la nature du mécanisme à l’origine de la masse des neutrinos. Selon certains théoriciens, cette masse est d’une manière ou d’une autre liée au boson de Higgs, comme c’est le cas pour les autres particules. Les neutrinos appartiendraient alors à la classe des particules de Dirac, dont la particule est différente de l’antiparticule. D’autres pensent que les neutrinos sont leur propre antiparticule, ce qui les rangerait dans la classe des particules de Majorana et impliquerait l’existence de neutrinos dits « stériles », indétectables, mais ultra-massifs, qui auraient joué un rôle dans la disparition de l’antimatière aux tout premiers instants de l’Univers.

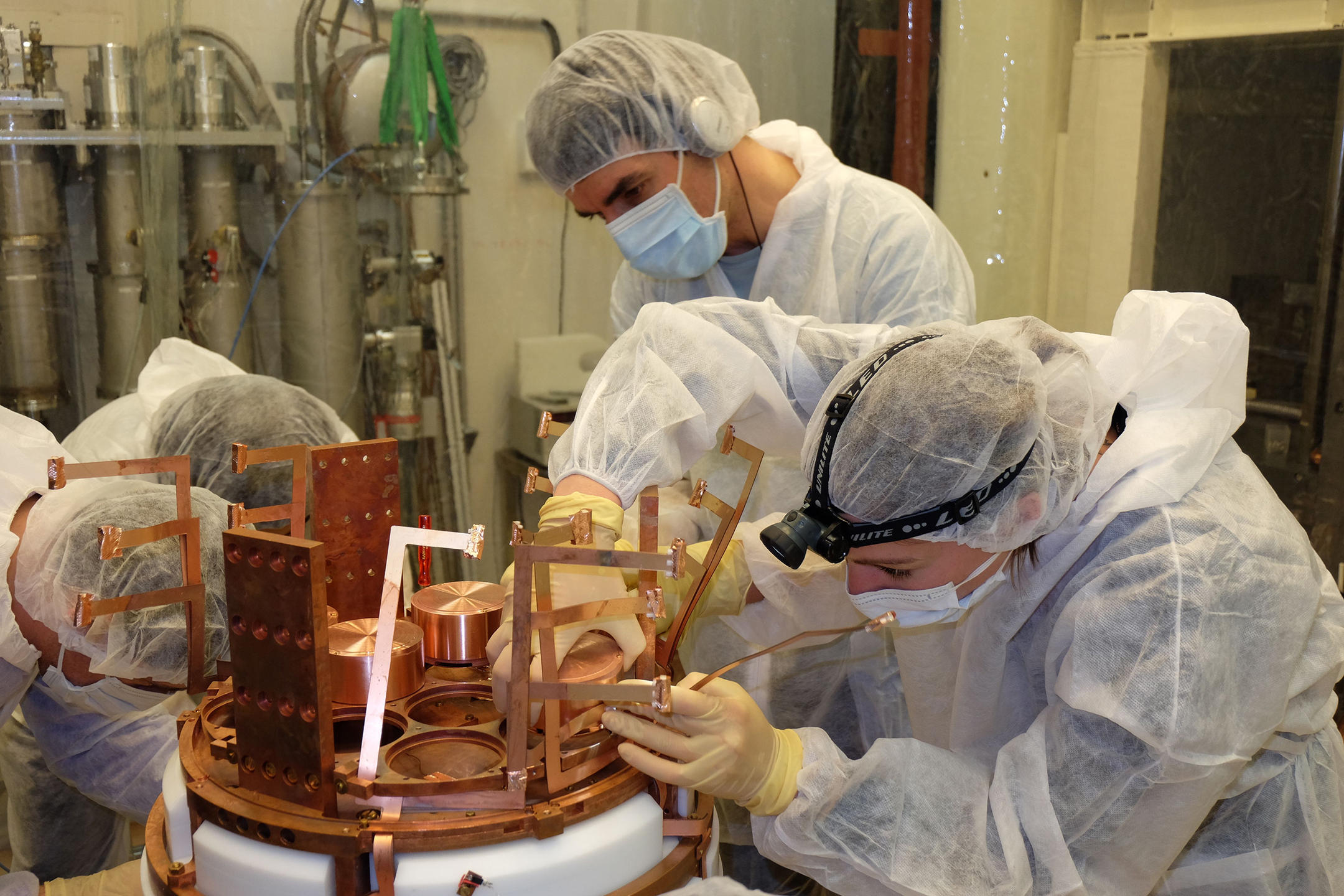

Si les neutrinos sont des particules de Majorana, la théorie prévoit qu’à l’issue de la double désintégration bêta de certains noyaux atomiques radioactifs, qui s’accompagne habituellement de la production de deux électrons et de deux neutrinos, les neutrinos ne soient pas émis. Pour vérifier l’existence du phénomène, des expérimentateurs terminent actuellement la mise en place de l’expérience SuperNEMO, au sein du Laboratoire souterrain de Modane7. Elle consiste en 6 kilos de sélénium sous la forme de feuilles de 300 microns d’épaisseur, entourées de près de 15 000 fils et de plus de 700 détecteurs permettant de visualiser la trajectoire des particules et mesurer leur énergie. L’ensemble est protégé de tout rayonnement parasite par une épaisse couche de fer et d’eau et par les 1 700 mètres de roches sous lesquels se trouve le laboratoire. De quoi mettre en évidence cette fameuse réaction de double désintégration bêta sans émission de neutrino. « SuperNEMO est une expérience offrant une approche de détection unique au monde qui pourrait permettre de révéler la nouvelle physique à l’origine de cette désintégration interdite par le modèle standard », précise Christine Marquet, porte-parole de l'expérience SuperNEMO et directrice de recherche au Centre d’études nucléaires de Bordeaux Gradignan8.

EDELWEISS-SubGeV et XENON 1T à la recherche de matière noire

En attendant, installée dans le même laboratoire que SuperNEMO, l’expérience EDELWEISS-SubGeV va s’attaquer à un autre phénomène non expliqué par le modèle standard : la nature de la matière noire. Même si elle n’a jamais été détectée directement, les astrophysiciens sont persuadés de son existence car ils en observent les effets gravitationnels à toutes les échelles du cosmos. EDELWEISS est constituée de détecteurs solides au germanium ultra-sensibles refroidis à une température proche du zéro absolu. « Une fois optimisée, EDELWEISS-SubGeV nous permettra de détecter d’hypothétiques particules de matière très légères », explique Corinne Augier, professeure à l’Institut de physique des deux infinis de Lyon9 et membre de la collaboration EDELWEISS...

En parallèle, d’autres expériences traquent sans relâche la matière noire sous la forme de particules plus massives. C’est notamment le cas de l’expérience XENON 1T, installée dans le laboratoire souterrain du Gran Sasso, en Italie. L’année dernière, ses 3,2 tonnes de xénon liquide ont détecté un premier signal. Celui-ci ne correspond pas aux caractéristiques attendues pour la matière noire telle qu’elle est recherchée par cette expérience, mais pourrait correspondre à une particule hypothétique appelée axion, qui serait émise par le Soleil. Si cette observation était confirmée, ce qui sera possible d’ici quelques années avec sa successeuse XENONnT, elle deviendrait alors la première expérience à mettre en évidence un phénomène physique « non standard ».

ALPHA-g, AEgIS et GBAR pour peser l’antimatière

À moins que la révolution n’éclate finalement dans l’enceinte du Cern… mais pas au LHC. C’est en tout cas l’espoir des physiciens opérant les trois expériences ALPHA-g, AEgIS et GBAR. Leur ambition : déterminer si, dans un champ de pesanteur, l’antimatière se comporte de la même manière que son alter ego, la matière, ou bien différemment, tel que le prévoient certaines théories.

Le principe de ces expériences est le même que celui des expériences de Galilée réalisées il y a quatre siècles : lancer une particule d’antimatière et mesurer sa trajectoire en chute libre. À ceci près que le moindre contact entre un grain d’antimatière et la matière environnante se traduit par une annihilation mutuelle. D’où l’extrême difficulté de réaliser une telle expérience, d’autant plus qu’afin d’échapper aux incontournables perturbations électromagnétiques, beaucoup plus fortes que l’effet gravitationnel, les scientifiques ne pourront pas utiliser des antiprotons ou des positrons, électriquement chargés, mais devront d’abord assembler ces particules pour créer des atomes d’antihydrogène neutres.

Et ce ne sera pas tout puisque comme le précise David Lunney, directeur de recherche au Laboratoire de physique des deux infinis-Irène Joliot Curie10 : « Le plus difficile sera in fine de réduire la vitesse initiale de ces antiatomes, sans quoi il ne sera pas possible d’observer une éventuelle différence de temps de chute avec l’hydrogène. » Il est possible qu’ALPHA-g produise ses premiers résultats cette année, suivie de ces consœurs l’année prochaine. Selon certains scénarios théoriques, il est envisageable que l’antimatière anti-gravite, auquel cas les antiatomes du Cern, plutôt que de tomber, « s’envoleront » dans le champ de pesanteur ! La physique fondamentale se retrouverait alors cul par-dessus tête, mais serait-ce vraiment un problème au regard des vertigineuses questions sans réponse auxquelles elle doit aujourd’hui faire face ? ♦

Événements

Rendez-vous sur Twitch le 14 avril, de 14h à 16h, pour une émission spéciale à suivre en direct pour les 50 ans de l'IN2P3 :

www.twitch.tv/ccin2p3

Et découvrez tous les évenements prévus en 2021, dans toute la France, pour cet anniversaire sur : https://50ans.in2p3.fr/

- 1. Unité CNRS/Université Paris-Saclay/Université Paris-Sorbonne. L’équipe de Michel Davier comprend des membres de l’JCLab, du Cern et du LPNHE (Unité CNRS/Univ. Paris-Sorbonne).

- 2. Unité CNRS/Aix-Marseille Université/Université de Toulon.

- 3. Unité CNRS/École polytechnique.

- 4. Unité CNRS/Université Grenoble-Alpes.

- 5. Unité CNRS/Aix-Marseille Université.

- 6. Unité CNRS/Université de Strasbourg.

- 7. Unité CNRS/université Grenoble-Alpes.

- 8. Unité CNRS/Université de Bordeaux.

- 9. Unité CNRS/Université Claude-Bernard Lyon 1.

- 10. Unité CNRS/Université Paris-Saclay.

Voir aussi

Auteur

Né en 1974, Mathieu Grousson est journaliste scientifique. Diplômé de l’École supérieure de journalisme de Lille, il est également docteur en physique.