Vous êtes ici

Préserver les données de la recherche à l’ère du Big Data

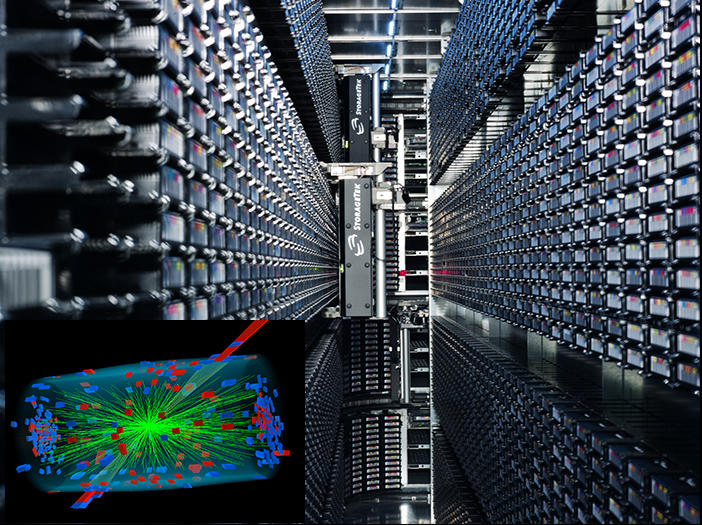

Connaissez-vous le « projet valise » ? C’est l’histoire d’une équipe de chercheurs en physique des particules qui souhaite analyser les données d’une expérience vingt ans plus tard avec de nouveaux outils et découvrent ces données enregistrées sur de vieilles bandes magnétiques, elles-mêmes stockées dans une vieille valise oubliée dans le recoin d’un bureau. S’ensuit un laborieux travail de récupération, de lecture et de compréhension des données.

Fort heureusement, l’histoire se termine bien, et les chercheurs découvrent même une nouvelle dépendance de l’énergie dans les interactions fondamentales. Mais il n’en va pas de même pour toutes les tentatives de recherche incluant des données anciennes. Il est courant de se trouver face à des supports anciens inutilisables faute de machine en état de les lire ou, pire, de ne pas du tout retrouver les données car elles ont tout simplement été jetées une fois le projet terminé et les articles publiés.

Une communauté dédiée à la préservation des données

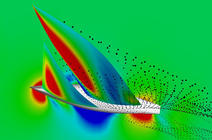

À mesure que les instruments et les outils d’analyse se perfectionnent, la quasi-totalité des disciplines fait face à une explosion du volume de données produites chaque année. Et ces données sont précieuses, car elles sont très souvent issues d’expériences complexes et coûteuses comme en physique des hautes énergies, ou sont le fruit d’observations ponctuelles sur une longue période de temps à l’instar du suivi de la position des objets stellaires ou des relevés démographiques.

du volume de

données issues

des expériences

menées au Cern

nous a conduits

à mener une

réflexion autour de

leur préservation.

C’est dans ce contexte qu’est né en 2012 le projet interdisciplinaire Predon, sous l’impulsion de Cristinel Diaconu, directeur de recherche au CNRS1 : « L’explosion du volume de données issues des expériences menées au Cern nous a conduits à mener une réflexion autour de leur préservation. Nous avons dans un premier temps structuré notre communauté autour d’une organisation internationale nommée Data Preservation and Long Term Analysis in High Energy Physics. Par la suite, nous nous sommes aperçus que nombre de disciplines étaient confrontées à la même préoccupation. C’est de ce constat que nous est venue l’idée de former une communauté interdisciplinaire autour de la question de la préservation des données scientifiques. »

Au sein du forum, les participants échangent donc autour de questions telles que « Comment conserver les données à long terme ? », « Comment garantir qu’on saura les lire dans dix ou vingt ans ? » ou encore « Comment permettre à la prochaine génération de chercheurs de comprendre les données archivées ? » afin d’adapter les stratégies de préservation à leur propre secteur.

Ces questions deviennent d’autant plus importantes que la présentation d’un Data Management Plan (plan de préservation des données) est demandée dans le cadre d’un projet pilote du programme européen pour la recherche et l’innovation Horizon 2020 et qu’elle a vocation à se généraliser.

L’astronomie, discipline pionnière dans le domaine

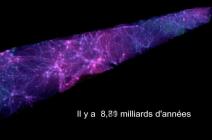

Le secteur pionnier en matière de préservation et de partage des données est sans nul doute celui de l’astronomie. Si des catalogues structurés apparaissent dès le XIXe siècle, c’est parce que les scientifiques accumulent de plus en plus de données d’observation essentielles à la compréhension du ciel et de son évolution. Le partage d’informations est donc incontournable pour la recherche.

« Pour comprendre les phénomènes physiques à l’œuvre en astronomie, nous avons besoin de rassembler des observations obtenues par différentes techniques et de travailler à partir de données obtenues par d’autres instruments et d’autres équipes », détaille Françoise Genova, chercheuse à l’Institut national des sciences de l’Univers du CNRS et au Centre de données astronomiques de Strasbourg (CDS)2.

Pour répondre à ce besoin d’échange et de préservation des données, la communauté astronomique internationale s’est structurée autour de l’Observatoire virtuel, un ensemble de services qui permet de retrouver l’information utile parmi toutes les données astronomiques ouvertes aux chercheurs grâce à un grand répertoire et à des standards partagés.

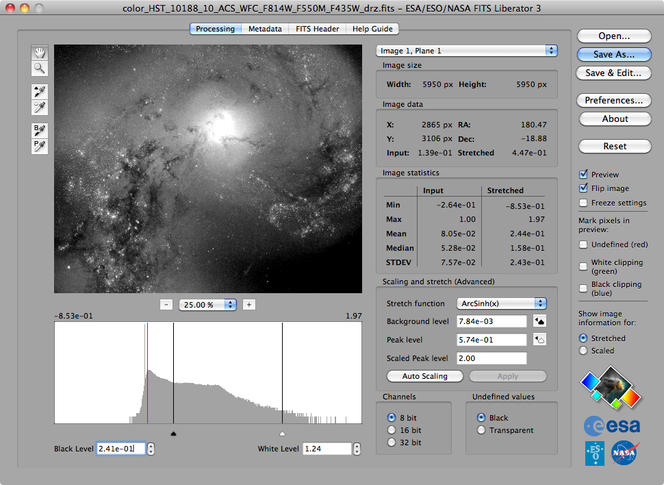

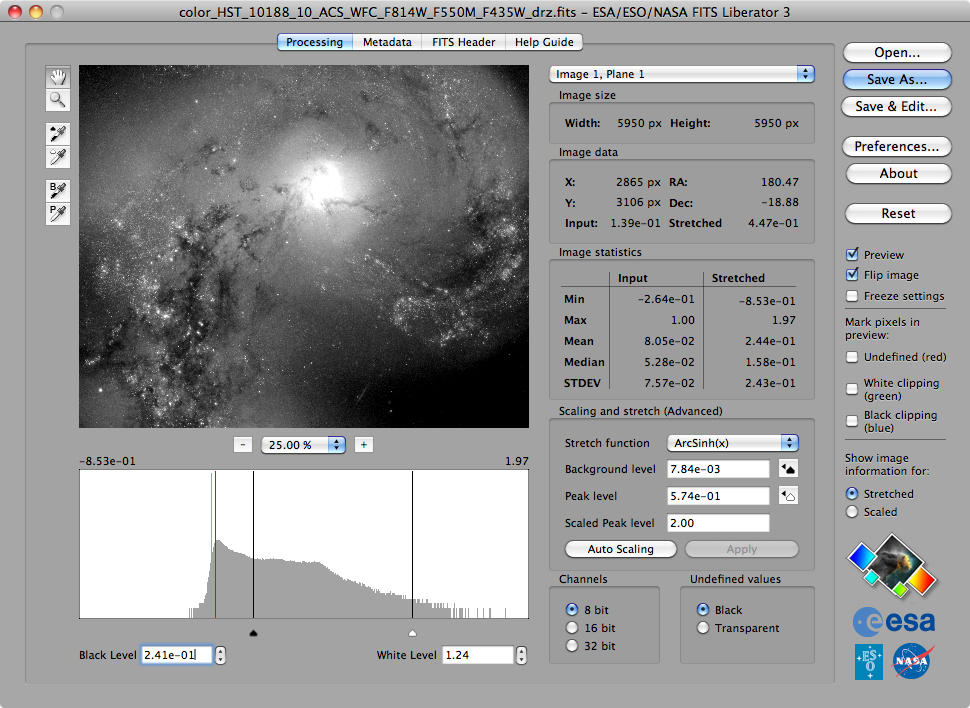

« Au CDS, nous standardisons les documents en formats pérennes pour leur conservation et nous leur attribuons les métadonnées reconnues par la discipline. Ces métadonnées peuvent être présentes dans les documents reçus (fichiers Fits, Flexible Image Transport System) ou ajoutées par des documentalistes du CDS », explique Gilles Landais, ingénieur au CDS. Ces données sont ensuite dupliquées sur huit sites miroirs situés dans différents pays.

Documenter les données pour le futur

Les métadonnées – ces étiquettes qui décrivent le contenu des données elles-mêmes – jouent en effet un rôle central dans toute entreprise de préservation pérenne : ce sont elles qui vont permettre de récupérer rapidement et d’exploiter de manière fiable des résultats recueillis des années auparavant par des équipes et des instruments différents. En photographie, par exemple, les métadonnées renseignent sur le modèle d’appareil photo, différents paramètres de prise de vue et, parfois, les coordonnées de géolocalisation lorsque l’appareil photo est doté d’un GPS.

important travail

sur la qualité

des données qui

concourt au fait

qu’elles seront

réutilisées.

Ainsi, aux problématiques liées au stockage matériel et à la sélection des données, s’ajoute le souci de rendre ces dernières intelligibles (et exploitables) dès leur réception : « Nous menons un important travail sur la qualité des données qui concourt au fait qu’elles seront réutilisées, note Gilles Landais. Par exemple, les données doivent intégrer des informations contextuelles telles que le système de coordonnées qui a permis de calculer telle position ou l’instrument qui a servi à l’observation, etc. Si ces informations manquent, ce sont nos documentalistes qui vont les rechercher. Ce travail confère beaucoup plus de pertinence aux données et permet de rechercher de l’information de manière très précise. »

La conservation et le partage des données sont inclus dès le départ dans les projets de grande échelle. Dernier exemple en date, le satellite d’observation Gaia, dont la mission est de cartographier plus d’un milliard d’objets célestes. « En prévision du grand volume de données, le projet a simulé les catalogues et élaboré un plan de préservation et de restitution à la communauté avant le lancement de la mission », explique Françoise Genova.

Ces bonnes pratiques se diffusent naturellement au sein de Predon : « Nous y avons surtout expliqué notre utilisation des métadonnées, indique Gilles Landais. Il s’agit d’une information cruciale dans la préservation et les différentes disciplines rencontrent certaines difficultés communes. » Le partage des méthodes de préservation rencontre un écho particulier dans les domaines qui voient émerger de grandes masses de données comme la cristallographie ou la génétique.

Standardiser les formats

De la bonne pratique à l’échelle d’une unité de recherche à la stratégie globale, il n’y a qu’un pas. Les sciences humaines et sociales se sont dotées d’une Très grande infrastructure de recherche, la TGIR Huma-Num 3, pour gérer la diffusion et la préservation de leurs données numériques. Ce service est proposé en partenariat avec le Centre informatique national de l’enseignement supérieur (Cines), qui fournit les outils et l’expertise nécessaires à l’archivage.

« Ce partenariat offre plusieurs avantages, relève Marion Massol, responsable du département de l’archivage au Cines. D’abord, la TGIR gère les priorités entre les différents projets et accompagne les laboratoires dans la réalisation de l’archivage. Ensuite, cela nous permet d’accompagner les producteurs dans la fabrication d’outil de génération et d’organisation de données vers les installations du Cines. Enfin, le processus est quasiment transparent pour les chercheurs. »

Depuis 2006, le Cines prend en charge l’archivage pérenne des données de toutes les disciplines sur la base du volontariat. « Nous essayons de nous adapter aux capacités de la personne qui verse les données. C’est à la fois du sur-mesure et du mutualisé », précise Marion Massol.

Au-delà des aspects techniques du stockage, le Cines poursuit des actions de lobbying auprès des acteurs du marché afin que leurs formats de fichiers soient encore lisibles dans plusieurs années. Une équipe d’ingénieurs est engagée dans une course permanente contre l’obsolescence en veillant à ce que les logiciels ou lecteurs matériels puissent en permanence accéder aux données. La plateforme Facile recense la palette de formats actuellement pris en charge par le Cines.

« Nous partageons ces bonnes pratiques au sein de Predon afin d’aider les communautés scientifiques à se structurer et à définir des formats standards en fonction de leurs particularités », ajoute Marion Massol.

Parmi les communautés qui ont entamé ce travail d’ouverture, les chercheurs qui ont effectué les simulations climatiques dans le cadre du Groupe d’experts intergouvernemental sur l’évolution du climat (Giec) ont été confrontés au découpage de leurs expériences entre différents laboratoires et pays. « La contrainte qu’ils avaient de réharmoniser les résultats afin de les comparer et de les partager entre eux a obligé les climatologues à convenir de l’utilisation de formats standards pour les données et les métadonnées », confie Marion Massol.

Des archives peu coûteuses

La question des métadonnées est au centre des préoccupations de Cristinel Diaconu : « Réaliser une manipulation quelconque sur des données dont on ne connaît ni le type ni la structure n’a aucune chance de fonctionner. Il est indispensable que tout soit documenté. Les métadonnées sont habituellement le point faible : chacun connaît sa manip par cœur et ne ressent aucun besoin de la décrire suffisamment. Mais, lorsque la personne passe à autre chose, les données sont perdues. Aujourd’hui, on ne sait pas conserver des données complexes qui sont la propriété d’une communauté fermée afin qu’elles soient réutilisables dans le futur. »

conserver des

données complexes

qui sont la

propriété d’une

communauté

fermée afin qu’elles

soient réutilisables

dans le futur.

La question de la survivance des données à la communauté qui les a produites se pose donc. La réponse unanime est de rendre les données publiques, ouvertes, et de travailler sur les formats pour qu’elles soient intelligibles, simples à lire et que le format soit pérenne.

Mais, pour Cristinel Diaconu, la perte de données semble être le lot commun : « Quand on veut accéder aux données, ou on ne les trouve plus, ou on les trouve, mais on ne sait pas quoi faire parce qu’on ne comprend pas ce que c’est. Pire, certaines données ont parfois été détruites par les chercheurs qui les jugeaient inutiles à l’issue d’un projet. Sur le coup, on ne s’en rend pas compte mais, dix après, le projet en cours peut avoir une résonance avec le projet précédent et le potentiel de découverte est perdu car il n’y a plus de financement pour refaire ces manipulations. »

Pourtant, ces données archivées représentent une vraie manne. Cristinel Diaconu s’est livré à un calcul de rentabilité de ces données pour son domaine : « Nous nous sommes rendu compte avec mon équipe que le coût supplémentaire dédié à la préservation des données est de l’ordre de 1/1 000 du budget total. Or la publication de nouveaux articles issue de l’exploitation des archives dans les cinq années suivantes représente un bénéfice de 10 %. C’est de la recherche qui ne coûte presque rien ! Si on n’a pas de stratégie de préservation des données, on passe à côté de découvertes potentielles et de recherche à bas coût. Une fois qu’elles sont bien préservées, les données ne coûtent presque plus rien. »

Voir aussi

Auteur

Formé à l’Institut de journalisme de Bordeaux et à l’école de photographie Efet, Guillaume Garvanèse est journaliste et photographe, spécialisé dans les domaines de la santé et du social. Il a notamment travaillé pour le groupe Le Moniteur.