Vous êtes ici

Un logiciel qui décrypte la politique

Vous venez de recevoir un Google Award pour votre projet « Event thread extraction for viewpoint analysis », une application capable de détecter, analyser et représenter graphiquement les opinions des différents courants politiques et de leurs membres sur des thèmes de société précis. Pouvez-vous nous expliquer ce qu’est le traitement automatique des langues ?

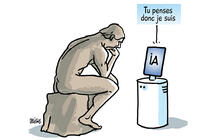

Xavier Tannier : Il s’agit d’une discipline de l’intelligence artificielle à mi-chemin entre l’informatique et la linguistique, qui a pour but d’analyser le langage humain, et dans ce cas, le texte. Des exemples d’applications sont la traduction automatique, la correction orthographique, le résumé automatique, l’extraction d’information, la fouille de texte. Mon laboratoire, le Limsi1, travaille sur presque tous ces domaines, ainsi que sur le traitement du langage parlé. Mon travail est plutôt tourné vers l’extraction d’information et la fouille de texte. Je m’attache à l’analyse de grandes quantités de documents textuels (typiquement, plusieurs millions) pour en extraire des informations pertinentes pour une situation donnée. On parle d’intelligence artificielle dès qu’on essaie de faire faire par la machine une tâche qui nécessitait de l’intelligence humaine auparavant, et qui n’est pas du calcul pur. Dans le traitement automatique des langues (TAL), on essaie de simuler les compétences langagières d’un humain, que ce soit en termes de production, de traduction ou de compréhension. C’est le cas de cet outil qui permet d’organiser des textes écrits de façon à mieux décrypter les opinions et les rapports de force dans le monde politique.

Comment est née l’idée de ce projet « Event thread extraction for viewpoint analysis » ?

X. T. : Il s’agit d’une collaboration avec Ioana Manolescu, de l’Inria de Saclay, et l’équipe des Décodeurs du journal Le Monde, dirigée par Samuel Laurent, qui se consacre au fact checking. Cette pratique aujourd’hui très répandue dans les journaux consiste à vérifier, parfois en temps réel, la véracité des déclarations factuelles d’un homme politique par exemple. Il peut s’agir d’une information chiffrée – baisse du chômage ou dépenses engagées sur un budget – dont on vérifie l’exactitude, ou encore des affirmations qui peuvent contredire des déclarations précédentes.

automatique

des langues est

particulièrement

adapté à l’analyse

des articles

de presse.

L’équipe travaille également sur de la visualisation de données, essentiellement pour le site Web du journal. Le traitement automatique des langues est particulièrement adapté à l’analyse des articles de presse. Je travaille par exemple sur la notion d’événement et j’essaye, à partir d’une grande masse de textes, de construire une chronologie d’événements importants qui se sont déroulés sur un thème précis. Par exemple, si l’utilisateur veut la liste des événements importants sur le Printemps arabe, sur les événements en Irak ou sur une personne, le système va chercher automatiquement les articles de journaux et va essayer de déterminer ce qui est le plus important sur ces questions et va fournir une chronologie à l’utilisateur (projet ANR Chronolines).

Quel est le progrès par rapport à un simple moteur de recherche ?

X. T. : Il y a une hiérarchisation de l’importance de l’article cité, effectué grâce à un grand nombre de données et d’articles. Pour prendre l’exemple d’une thématique telle que « la laïcité », nous allons disposer d’une base de données très importante, avec les dix ou quinze événements marquants sur le domaine, où les informations temporelles ont une grande importance. Nous allons attribuer des coefficients d’importance en prenant en compte les aspects liés aux rumeurs ou aux tendances politiques. Deux critères principaux sont divisés ensuite en sous-critères : la redondance, c’est-à-dire le nombre d’article reprenant un événement, et l’analyse temporelle, qui estime que si l’on en parle encore longtemps après, c’est un événement important. L’écriture journalistique est très appréciée parce que les contenus sont nombreux et parce que ce n’est pas du tout-venant comme sur les blogs : il n’y aura pas de fautes d’orthographe, les phrases seront bien construites, etc. Cela nous pose un problème de moins à résoudre. On travaille sur l’ensemble du Web, mais on privilégie surtout les sites de presse pour traiter les données compliquées avec moins d’éléments disparates.

Quel type d’informations traitez-vous ?

X. T. : Nous collectons un maximum de données pour étudier ces phénomènes parmi des articles de presse, des déclarations des hommes politiques, ainsi que leurs sites Web et leurs comptes Twitter. On va se concentrer sur la politique parce que c’est ce qui intéresse le plus les gens du Monde : par exemple, ils visent les régionales qui approchent, ou encore les primaires à droite ou plus tard les présidentielles. Le but étant, soit sur un événement précis, soit sur un sujet donné, de collecter les déclarations politiques et de les répartir sur l’échiquier politique : de l’extrême-gauche, gauche, centre, droite, jusqu’à l’extrême-droite et de disposer d’une visualisation qui permette de décoder assez rapidement quel est le vocabulaire utilisé et l’opinion portée par chacun de ces partis. Ainsi nous allons distinguer des tics de langage ou des postures sans vrai contenu politique. Il y a de nombreux partis politiques en France et en leur sein est diffusée l’opinion portée par le parti ou au contraire par des gens qui s’en éloignent un petit peu. Nous allons nous concentrer sur les éléments de langage, ou sur les commentaires et réactions des partis qui sont assez diserts sur les événements sensibles, et repérer ainsi ceux qui s’écartent du discours imposé à des fins de stratégie politique. Souvent, on a un courant principal affiché par un parti politique et finalement deux ou trois personnalités qui vont tenir un langage complètement différent au sein de ce même parti. Sur le sujet de la laïcité par exemple, on peut le mesurer, et c’est encore plus visible sur des sujets tels que le mariage pour tous. C’est ce que nous avons dénommé des « expressions dissonantes ».

permettra

de remarquer

comment

des partis que

tout oppose

en apparence

adoptent en fait

la même ligne.

Votre matériel de départ est toutefois très formaté et déjà homogène ?

X. T. : En effet, même si certains tweets s’en éloignent un petit peu ; mais nous ne prenons pas en compte tous les tweets, seulement ceux qui restent liés aux comptes des personnalités politiques. Le vocabulaire y est un tout petit peu plus débridé, mais cela reste relativement contrôlé. On pourrait imaginer que ce type d’outil participe à l’uniformisation de la pensée, mais on constate déjà que le fact checking pratiqué depuis quelques années empêche les politiques de transmettre des chiffres erronés. Ils sont alors obligés de mentir de manière plus fine. Le but de cette application est d’aider les journalistes et les citoyens à comprendre comment et pourquoi les hommes politiques ne disent pas ce qu’ils pensent, mais répètent ce qui est formaté selon chaque parti. Le but n’est pas prédictif : il s’agit uniquement de décoder le discours politique et d’aider à le visualiser. Typiquement, ce projet permettra de remarquer, par exemple sur une question européenne, comment des partis que tout oppose en apparence adoptent en fait la même ligne.

Quel est l’état d’avancement du projet et sera-t-il commercialisé ?

X. T. : Le Google Award, contrairement à ce que le nom semble indiquer, n’est pas une récompense pour un travail achevé, mais un soutien financier sur un an pour un travail en cours (avec l’Inria et Le Monde). Nous n’en sommes encore qu’à la phase de collecte de fonds, qui commence plutôt bien puisque l'Agence Nationale de la Recherche (ANR) vient d'accepter de financer ce programme (projet ANR ContentCheck). Les travaux que nous avons effectués sont préalables : notre travail sur les « chronolines », les chronologies journalistiques que nous étudions depuis quelques mois sur les dépêches de l’AFP2, est à présent terminé. Mais le projet récompensé en tant que tel n’existe pas encore. Je pense que l’application sera gratuite, elle n’a pas vocation à être commercialisée dans l’immédiat, car il s’agit pour l’instant d’un travail de recherche, et Google ne s’ingère pas dans nos travaux, mais collecte plutôt des idées. Symboliquement, ce prix est très important pour nous, mais nettement moins que l’ANR en termes de retombées financières. Il nous permet juste de financer un ingénieur pendant un an.

Sur le même sujet, lire aussi: A la recherches des émotions dans nos SMS

Voir aussi

Auteur

Lydia Ben Ytzhak est journaliste scientifique indépendante. Elle travaille notamment pour la radio France Culture, pour laquelle elle réalise des documentaires, des chroniques scientifiques ainsi que des séries d’entretiens.