Vous êtes ici

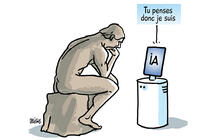

Les algorithmes peuvent-ils détecter l’humour, les émotions ou les discours haineux ?

Temps de lecture : 9 minutes

Qu’est-ce que le langage évaluatif et comment est-il étudié ?

Farah Benamara1. Le langage évaluatif couvre tout ce qui est utilisé pour exprimer les sentiments, points de vue, souhaits, attentes et intentions futures. Il concerne ainsi le domaine du ressenti et des émotions, et se retrouve donc beaucoup dans les contenus en ligne tels que les réseaux sociaux. Le terme de « langage évaluatif » est très présent en linguistique, mais l’informatique ne s’en est pas encore complètement emparée. Il englobe pourtant des phénomènes allant bien plus loin que la seule analyse des sentiments.

La recherche s’y intéresse depuis la fin des années 1990, en identifiant automatiquement les adjectifs porteurs d’expressions subjectives du langage. Dans la décennie suivante, le développement de la linguistique computationnelle a permis de créer des lexiques de mots polarisés selon qu’ils dégagent un aspect positif ou négatif.

On s’est ensuite rendu compte que cela ne suffisait pas, puisque le ton global d’un texte dépend énormément du contexte. Les connexions entre les mots et les phrases découlent de nombreuses informations qui ne sont pas écrites. Par exemple, l’adjectif « long » peut exprimer une opinion négative ou positive selon le contexte : « une longue durée de vie » contre « une longue attente ». On peut très bien dire « super, il fait beau ! » alors qu’en fait, il pleut. L’ironie et le sarcasme empêchent d’analyser les mots de façon trop simple et directe. De même, lorsque l’on souhaite détecter automatiquement des messages racistes ou sexistes, les propos sont souvent atténués par de l’humour, ce qui complique la tâche.

Quels outils sont utilisés par les chercheurs ?

F. B. Nous partons de la langue elle-même, en l’étudiant d’un point de vue linguistique. Ces approches doivent ensuite être automatisées, par exemple en entraînant des intelligences avec des méthodes d’apprentissage supervisé de type deep learningFermerTechnique d’apprentissage machine, en intelligence artificielle (IA), utilisant des réseaux de neurones (fonctions mathématiques). Ceux-ci sont capables d’extraire/analyser/classer des caractéristiques abstraites des données qui leur sont présentées, sans production explicite de règle. On ignore pourquoi le système parvient au résultat, c’est une « boîte noire ». Alors que la démarche symbolique, autre grande approche utilisée en IA, utilise des règles logiques rédigées par l’humain programmeur, et donc parfaitement connues (« boîte transparente »).. Cela demande de réunir de grandes quantités de données étiquetées, c’est-à-dire à qui on a attribué une valeur ou une qualité. Ces éléments sont assez disponibles en anglais, mais beaucoup moins dans les autres langues, comme le français.

Comment vous êtes-vous intéressée à ce domaine ?

F. B. J’ai commencé par la détection du langage évaluatif dans les critiques de films et de restaurants, ainsi que sur les commentaires de la presse en ligne. Il est fascinant de voir que les internautes s’adaptent au site sur lequel ils écrivent, et adoptent ainsi un langage plus soutenu, comme dans les commentaires sur des articles de presses. La détection automatique du langage évaluatif doit intégrer ces changements.

Le modèle classique consiste à compter les mots positifs et négatifs, puis à en calculer la différence. Cela ne suffit pas, car de nombreuses critiques vont énumérer les aspects négatifs d’un film, mais conclure qu’ils ont quand même passé un bon moment au cinéma. Or c’est cela que les lecteurs vont retenir avant tout. Dans la même lignée, j’ai coencadré une thèse de doctorat sur la détection de l’ironie et du sarcasme en 2013, car ces phénomènes impactent grandement sur les performances des systèmes de détection de la polarité d’une phrase.

En collaboration avec l’université de Turin et l’université polytechnique de Valence, nous avons ensuite étudié la portabilité des modèles de détection de l’ironie dans un cadre multilingue. Nous avons plutôt observé des tendances similaires en français, anglais, espagnol et italien, puis nous sommes sortis du cadre des langues indo-européennes avec l’arabe et ses nombreux dialectes.

Vous travaillez aussi sur les discours haineux. Comment sont-ils abordés par la recherche ?

F. B. Je me suis en effet attaquée à la détection automatique de tels messages, en particulier ceux qui visent les femmes. Je codirige d’ailleurs une thèse sur le sujet. Nous voulons développer des modèles capables de modérer les contenus de manière semi-automatique. Avec des linguistes de l’Institut Jean Nicod2 et des chercheurs en sciences de la communication du Laboratoire d’études et de recherches appliquées en sciences sociales de l’université Paul Sabatier, nous avons élaboré une classification des messages et un modèle capable de distinguer quand un acte est célébré ou, au contraire, rapporté pour être critiqué. En effet, les personnes qui racontent leurs propres expériences vont citer les termes haineux qu’ils ont reçus et les situations qu’ils ont vécues.

Ce modèle étant principalement destiné à détecter la haine envers les femmes, nous nous sommes alors posé la question de sa portabilité vers d’autres types de problèmes. Nous voulons donc voir si un modèle spécialisé contre le racisme peut détecter facilement du sexisme, ou si l’identification de haine anti immigrants peut être rapidement adaptée à l’islamophobie. Nos résultats sont encourageants. À long terme, notre objectif consiste à entraîner efficacement des intelligences artificielles (IA) sans avoir à systématiquement recréer des corpus de données étiquetées à la main, un procédé cher et fastidieux.

Dans le cadre du projet européen Sterheotypes3, nous allons encore plus loin pour tenter de repérer le racisme dans un contexte multilingue.

Comment cela se passe-t-il avec une langue comme l’arabe, très employée dans le monde, mais sous de nombreuses formes différentes ?

F. B. Dans les faits, les internautes utilisent rarement l’arabe littéraire pour communiquer en ligne. Alors qu’il y a beaucoup de demandes pour le traitement du langage évaluatif, nous ne disposons que de très peu de ressources pour le traitement des différents dialectes. Nous avons commencé par travailler sur la détection de l’ironie dans les dialectes de l’arabe sur Twitter. Au départ, nous avons choisi de ne pas prendre en compte les différences entre les dialectes, et entraîné nos algorithmes par deep learning sans nous poser la question.

Avec des collègues de l’Université des sciences et de la technologie d’Alger, nous avons analysé plus précisément les performances des modèles, tout en variant les dialectes. Malgré une forte variabilité, nous avons montré que ces modèles d’IA arrivaient à des résultats honorables même en mélangeant les dialectes. Le but est là encore d’obtenir une détection de qualité sans avoir à étiqueter des données spécifiques pour chaque dialecte. C’est un challenge global, qui va au-delà du cadre de l’arabe.

Quelles sont les autres applications possibles ?

F. B. Les travaux que j’ai décrits concernent surtout des commentaires et des messages en ligne, qui expriment des points de vue plus ou moins passés. Le langage évaluatif peut cependant aussi servir à détecter des intentions et des souhaits.

Dans le cadre du projet Intact4, nous développons des modèles adaptés aux crises et catastrophes écologiques. Nous avons constaté que, après un ouragan ou des inondations, beaucoup de gens utilisaient les réseaux sociaux pour demander de l’aide ou signaler des blessés, plutôt que d’appeler des pompiers souvent débordés. La France manque d’un algorithme capable de sonder les messages publics pour mieux orienter les secours.

En dehors de mes travaux, l’analyse du langage évaluatif peut aussi servir pour la prédiction de votes, ou pour vérifier si les gens sont satisfaits après des échanges électroniques, par exemple avec un chatbot. Les modèles vont également se rendre compte si quelqu’un commence à s’énerver ou à décrocher d’une conversation, afin d’aider son interlocuteur à réagir en conséquence. De même, les départements de marketing s’y intéressent pour mieux connaître l’avis des clients sur leurs produits. D’une manière plus connexe, ces techniques peuvent participer à la détection de faux profils, qui seraient chargés de poster en masse des commentaires positifs, ou négatifs s’ils visent la concurrence. ♦

Informations

« Intelligence artificielle : l’ordinateur passe la barrière de la langue », cycle de conférences grand public proposé par le Groupement de recherche « Traitement automatique des langues », porté par le CNRS, mardi 12 janvier 2021, de 9h à 17h.

Les conférences sont en ligne sur https://webcast.in2p3.fr/live/gdr-tal

- 1. Maître de conférences HDR à l’université Paul Sabatier de Toulouse et coresponsable de l’équipe MEthodes et ingénierie des Langues, des Ontologies et du Discours (MELODI) à l’Institut de recherche en informatique de Toulouse (IRIT – CNRS/Toulouse INP/Université Paul Sabatier).

- 2. Unité CNRS/ENS Paris.

- 3. Studying European racial hoaxes and stereotypes, en partenariat avec les universités de Barcelone, de Turin et de Rome.

- 4. Intention detection, predicting actions, en collaboration avec l’Institut Jean Nicod et financé par le FIESPI.

Voir aussi

Auteur

Diplômé de l’École supérieure de journalisme de Lille, Martin Koppe a notamment travaillé pour les Dossiers d’archéologie, Science et Vie Junior et La Recherche, ainsi que pour le site Maxisciences.com. Il est également diplômé en histoire de l’art, en archéométrie et en épistémologie.