Vous êtes ici

BigScience voit grand pour les modèles de langue

Pouvez-vous nous expliquer ce qu’est BigScience, « modèle de langue » dont la livraison vient d'être annoncée ?

Claire Gardent1. BigScience représente une avancée majeure pour les modèles de langue. Ces modèles permettent de calculer la probabilité d’une séquence de mots, puis génèrent du texte en enchaînant les mots qui ont le plus de probabilités de se suivre. Les anciens modèles de langues étaient limités à des contextes restreints, typiquement cinq mots d’affilée. Mais ceux basés sur des réseaux de neurones ont levé cette limitation et sont capables de prendre en compte un contexte, en principe, illimité. En pratique, ils ont véritablement révolutionné le domaine de la génération de texte en produisant du texte quasiment parfait d’un point de vue grammatical. Sur un texte court, il est très difficile de différencier leur prose de ce qu’aurait écrit un humain. Mais jusqu’à présent, ces modèles étaient surtout développés en anglais et par de grandes multinationales, qui les mettaient à disposition mais ne communiquaient ni les détails de leur apprentissage ni les données exploitées pour y parvenir. L’idée derrière BigScience est de créer de nouveaux modèles de langue, avec en plus une démarche multilingue et open source inédite.

BigScience présente aussi un aspect collaboratif très intéressant. Bien que coordonné par une entreprise privée, Hugging Face, le projet a rassemblé une communauté académique internationale de haut niveau. Une grosse partie du travail d’ingénierie a cependant été accomplie par Hugging Face.

Comment se construisent les modèles de langue ?

C. G. Ce sont des réseaux de neurones qui s’auto-entraînent sur de grandes quantités de textes. Ils prennent le premier mot d’une phrase et essayent de prédire le second, puis le troisième… Chaque prédiction est comparée avec le mot présent dans le texte et, en cas d’erreur, les poids du modèle sont adaptés par un mécanisme dit de rétropropagation. L’apprentissage se poursuit en boucle jusqu’à ce que le modèle converge, c’est-à-dire jusqu’à ce que ses prédictions soient stables.

Quels verrous et difficultés ont dû être surmontés par BigScience ?

C. G. Pour apprendre ces probabilités, le modèle a besoin de puissance de calcul, fournie par le supercalculateur Jean Zay2, et de données. BigScience a aussi dû gérer le passage à l’échelle que représente son caractère multilingue. Un gros travail de réflexion et d’ingénierie a été nécessaire, d’une part pour créer des données d’apprentissage de bonne qualité et d’autre part pour entraîner ces méga modèles. Les données utilisées sont en effet récupérées automatiquement sur Internet. Cela pose peu de difficultés si on se cantonne à l’anglais, où de larges corpus de textes sont déjà disponibles. En revanche, BigScience gère quarante-six langues, plus ou moins présentes en ligne. Il faut donc accumuler beaucoup de données dans des langues où il n’y en a pas forcément assez, et pas toujours de bonne qualité. En travaillant sur le breton, j’ai par exemple observé qu’un corpus qui avait été créé automatiquement pour la traduction automatique incluait des textes qui étaient en fait en anglais ou en chinois. Il faut pouvoir éviter cela sur d’énormes volumes de données, et également veiller à minimiser la présence de biais et de contenus offensants.

Quelles sont les principales applications possibles ?

C. G. Toutes les tâches qui relèvent de la génération de textes. La traduction automatique reste l’application phare, mais la simplification, la paraphrase ou le résumé de textes sont également importants. Les modèles de génération sont aussi utilisés pour convertir des bases de connaissances ou des données numériques en texte, par exemple pour produire un bulletin météo à partir de données météorologiques brutes. S’il est entraîné sur des dialogues, un modèle de langue peut aussi être intégré dans un agent conversationnel. Enfin, les modèles de question/réponse passent souvent par la génération pour proposer une réponse, à partir de cette question et d’informations pertinentes extraites d’Internet.

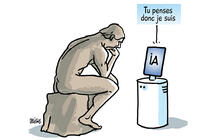

Un ingénieur de Google AI a récemment affirmé que le modèle de langue sur lequel il travaillait, LaMDA, était devenu conscient. Quelle est votre réaction à de telles déclarations ?

C. G. La question de l’intelligence des modèles de langues revient régulièrement. Ils ont des capacités vraiment étonnantes et certains cas montrés en exemple sont, de fait, remarquables. Cela ne signifie toutefois pas que le programme comprenne ce qu’il dit. La compréhension de la langue naturelle implique des raisonnements complexes et variés (spatial, temporel, ontologique, arithmétique), basés sur des connaissances et permettant de relier forme et sens (objets, actions dans le monde réel). Si quelques exemples choisis peuvent suggérer que les modèles de langue sont capables de tels raisonnements, on voit aussi tous les cas incorrects quand on travaille quotidiennement avec.

Avec Angela Fan de Facebook AI Research Paris, j’ai travaillé sur un algorithme qui génère des pages Wikipédia. Le texte est parfaitement écrit et semble rédigé par un humain. Cependant, si la forme est correcte, le contenu est rempli d’erreurs factuelles. Sur la page d’un basketteur, il est désigné par moments comme un joueur de tennis, certaines dates sont fausses et l’université où il a étudié n’est pas la bonne. Passé quelques lignes, un texte généré automatiquement finit souvent par se contredire. Si les modèles de langue étaient capables de compréhension, ils ne généreraient pas de telles incohérences. Il faut se méfier des effets de buzz créés par quelques exemples bien choisis.

La recherche doit continuer à créer des tâches et des benchmarks qui visent à réellement tester la capacité langagière des modèles de traitement automatique des langues. Ils doivent être évalués sur des tâches de raisonnement, multidomaine, multilingue et en interaction avec le monde, par exemple, par des systèmes où l’ordinateur doit répondre à des questions sur le contenu d’une image, d’une vidéo ou d’une conversation. Il y a d’autres objectifs essentiels, comme la capacité de généralisation des modèles, c’est-à-dire s’assurer qu’ils fonctionnent également bien sur du texte journalistique, technique, littéraire, etc. Il faut aussi concevoir des modèles pour les langues dites moins dotées. En collectant des données et en développant des modèles pour quarante-six langues, BigScience fait un pas majeur dans cette direction. ♦

A lire

Claire Gardent : une médaille d’argent du CNRS pour le traitement automatique du langage

A lire sur notre site

Supercalculateurs: les enjeux d’une course planétaire

L'intelligence artificielle au défi du langage (dossier)

Les androïdes de la saga Alien sont-ils pour 2093 ? (entretien axé sur le traitement automatique des langues)

Voir aussi

Auteur

Diplômé de l’École supérieure de journalisme de Lille, Martin Koppe a notamment travaillé pour les Dossiers d’archéologie, Science et Vie Junior et La Recherche, ainsi que pour le site Maxisciences.com. Il est également diplômé en histoire de l’art, en archéométrie et en épistémologie.