Vous êtes ici

Sciences numériques versus Covid-19

Que faire pour aider à combattre la pandémie de Covid-19 quand on n’est ni médecin ni épidémiologiste ? C’est ce que se sont demandé des spécialistes du numérique au CNRS, guidés par l’intuition que les outils qu’ils développent en temps normal pour étudier la propagation d’une rumeur sur Internet, optimiser la prise de décision en entreprise ou superviser un processus industriel complexe pourraient tout aussi bien être mis au service de la lutte contre l’épidémie. Illustration avec trois projets en cours, proposés dans le cadre de la plateforme Modcov19 mise en place en mars par le CNRS (lire ci-dessous).

Des modèles multi-agents pour prédire l’évolution de l’épidémie

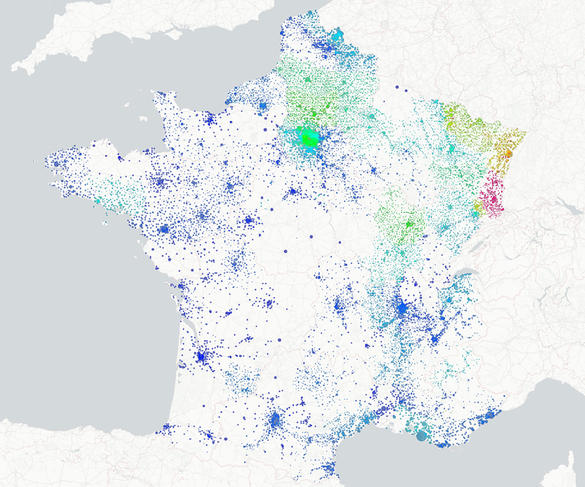

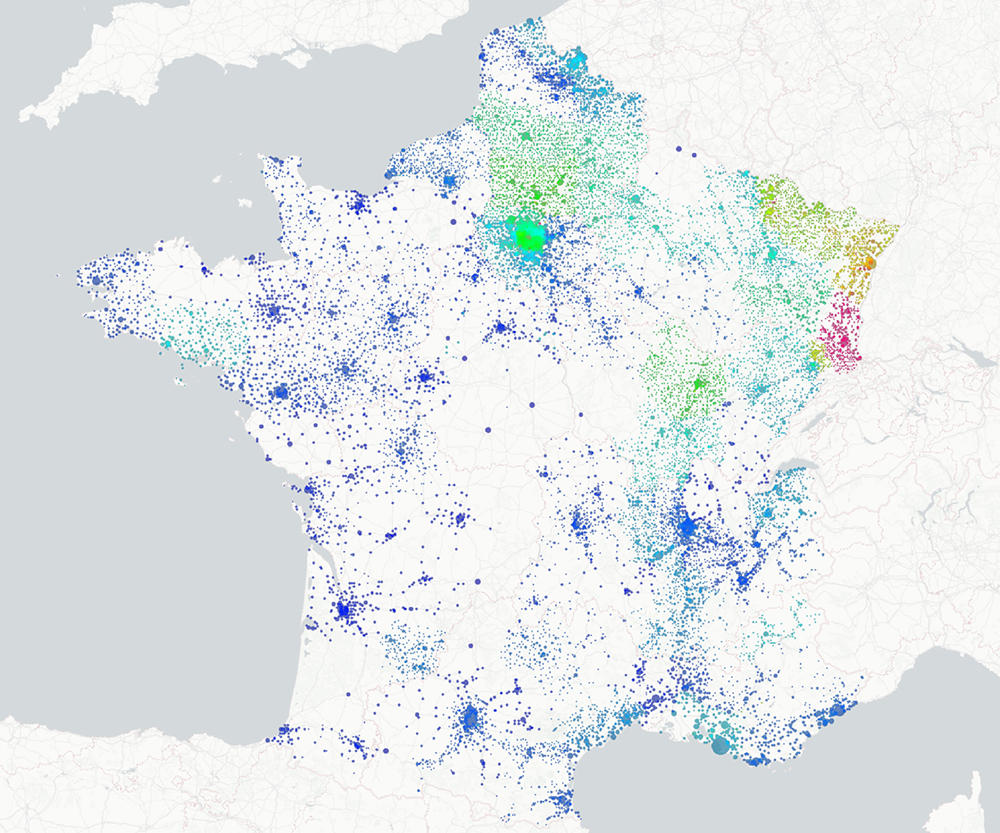

Au Gipsa-lab1 de Grenoble, Didier Georges est spécialiste des systèmes à dynamique spatio-temporelle qu’il modélise en recourant à des équations aux dérivées partielles, avec notamment des applications pour la surveillance de systèmes naturels ou industriels complexes. « Très vite, en discutant avec des collègues au sein de mon laboratoire, nous nous sommes rendu compte que nous pourrions peut-être proposer quelque chose », raconte le scientifique. Rapidement, un petit groupe de neuf chercheuses et chercheurs2 se met en place. Objectif : combiner plusieurs approches afin de proposer un modèle spatio-temporel multi-échelles de la pandémie qui permettrait de suivre son évolution avec une résolution variable allant de la commune à l’ensemble du territoire national.

Comme le détaille le chercheur, « à l’échelle de communautés réduites, notre idée est d’utiliser des modélisations multi-agents où les interactions sociales entre individus, qui sont fondamentales en matière de propagation de l’épidémie, sont reproduites par une série de règles comportementales auxquelles on ajoute une part de hasard. On peut alors en déduire une série de lois statistiques qui serviront ensuite à calibrer les paramètres d’entrée du modèle d’évolution de l’épidémie. Avec celui-ci, le comportement d’une population et l’évolution de l’épidémie sont alors analysés à une échelle macroscopique ; de la même manière que les équations de la mécanique des fluides, à grande échelle, considèrent un liquide ou un gaz comme un milieu continu, sans modéliser le comportement de chaque molécule. » Didier Georges ajoute : « Outre son caractère multi-échelles, la spécificité de notre approche réside dans un traitement différencié des classes d’âge au sein de la population, à quoi s’ajoute la possibilité d’une prise en compte fine de la mobilité des populations sur le territoire. »

Alors que le projet a démarré il y a un mois, outre l’activité de développement du modèle, les chercheurs ont consacré une part importante de leur temps à collecter les données de santé publiques nécessaires à sa mise en œuvre. « Nous avons commencé son implémentation et la calibration du modèle sur ordinateur et espérons ainsi avoir de premiers résultats sur l’évolution de l’épidémie d’ici la fin juin », indique Didier Georges.

Au-delà, dans la perspective d’une crise dont on pressent qu’elle s’étalera peut-être sur de longs mois, l’objectif des chercheurs est de faire de leur modèle un outil de surveillance. À partir de données « de terrain » : tests de contamination, comportements individuels, messages sur les réseaux sociaux, flux de population… par nature parcellaires, l’objectif est de formuler des alertes sur les risques de redémarrage de l’épidémie. « Ce type d’approches est par exemple utilisé dans l’industrie pour anticiper des pannes, ou encore dans le cadre de la prévention des incendies de forêt où il s’agit, sur la base de relevés de différents capteurs, d’identifier un départ de feu et de prédire l’évolution spatio-temporelle de celui-ci », complète le scientifique.

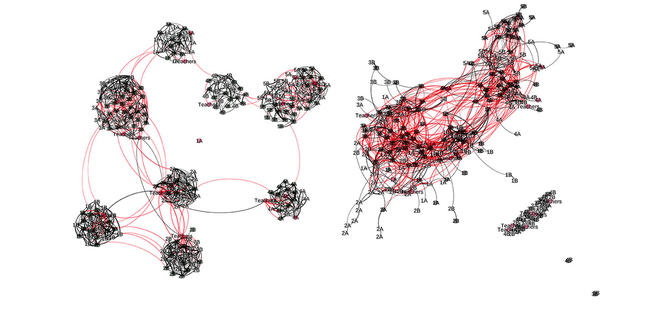

Des graphes pour améliorer le déconfinement

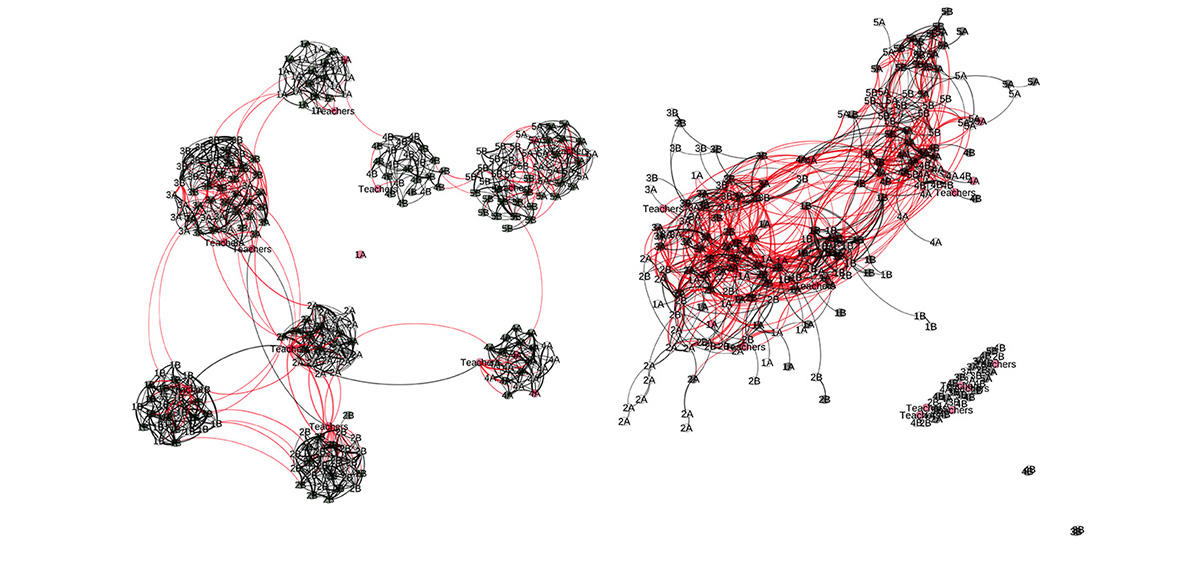

Dans un esprit similaire, Claire Mathieu et ses collègues Laurent Viennot et Vincent Cohen-Addad, à l’Institut de recherche en informatique fondamentale3, ont très vite eu l’idée que leurs travaux sur les graphes pourraient avoir un intérêt pour étudier la propagation du virus à l’échelle des petites structures sociales : famille, école, entreprise… L’objectif étant d’aider à la mise en place de stratégies de déconfinement/reconfinement.

Comme l’explique cette spécialiste des algorithmes, « un graphe est un réseau de points appelés nœuds, reliés par des liens. Dans le cadre d’une épidémie, chaque nœud représente une personne se trouvant à un stade infectieux donné (saine, infectée ou guérie) et chaque lien entre deux nœuds matérialise une interaction sociale entre deux individus. L’ensemble fournit une sorte de carte de l’ensemble des contacts sociaux au sein d’un groupe. À partir de ce réseau, on se donne ensuite une probabilité pour la transmission du virus lors d’une interaction entre deux personnes du réseau, à partir de quoi on peut étudier la façon dont l’infection se propage au sein de la population. »

Par des modélisations similaires, les chercheurs en informatique ont par le passé étudié la façon dont une information se propage au sein d’un groupe. Il en ressortait par exemple l’importance des individus très connectés, ainsi que de ceux qui appartiennent à plusieurs communautés simultanément. On en avait ainsi déduit que pour propager une information, il faut privilégier ces individus. À l’inverse, ce serait eux qu’il faudrait isoler en premier pour contenir une épidémie.

À ce jour, le projet comporte deux aspects. Le premier consiste à exploiter les données collectées en 2011 au sein d’une école primaire par des physiciens dans le cadre du projet SocioPatterns, soit la totalité des interactions de l’ensemble des élèves et enseignants pendant deux jours : qui croise qui, quand, où, combien de temps ? Comme l’explique Claire Mathieu, « il en résulte un graphe dynamique qui comprend 250 nœuds et plusieurs centaines de milliers de liens dont on peut, en analysant les propriétés de propagation, essayer de définir les meilleures stratégies de réouverture d’une école : faut-il ouvrir la moitié du temps ? Séparer les élèves en plusieurs groupes ? Si oui, quel serait leur la taille optimale ? Les enfants doivent-ils ou pas déjeuner dans leur classe ? N’est-il pas préférable de déplacer les professeurs de collège et de lycée de classe en classe plutôt que les élèves ? Une analyse quantitative rigoureuse peut aider à répondre à ces questions. »

Par ailleurs, les chercheurs envisagent de modéliser les réseaux représentatifs de différentes situations (dans une famille, un hôpital ou une entreprise) à partir desquelles conduire des analyses similaires. L’idée est de lier entre eux les différents graphes correspondants afin de comprendre par quels « chemins » passe une épidémie. « Nous pourrions peut-être alors aider à éclairer la réflexion sur les différents scénarios de déconfinement étudiés à l’échelle d’une ville ou d’un quartier, en indiquant concrètement quels sont les liens les plus pertinents à maintenir inactifs », envisage l’informaticienne.

Des modèles pour optimiser les coûts

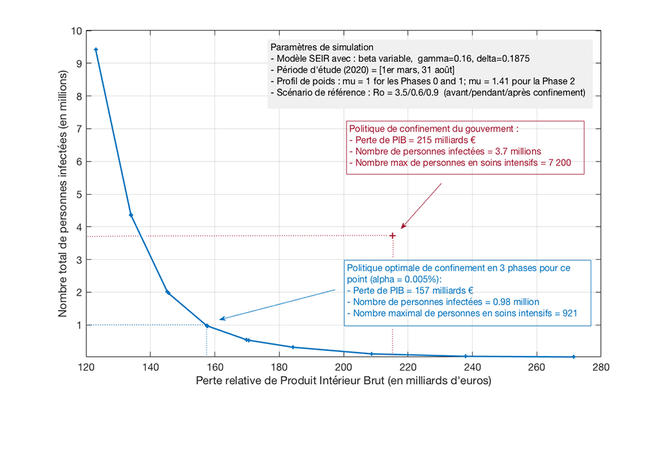

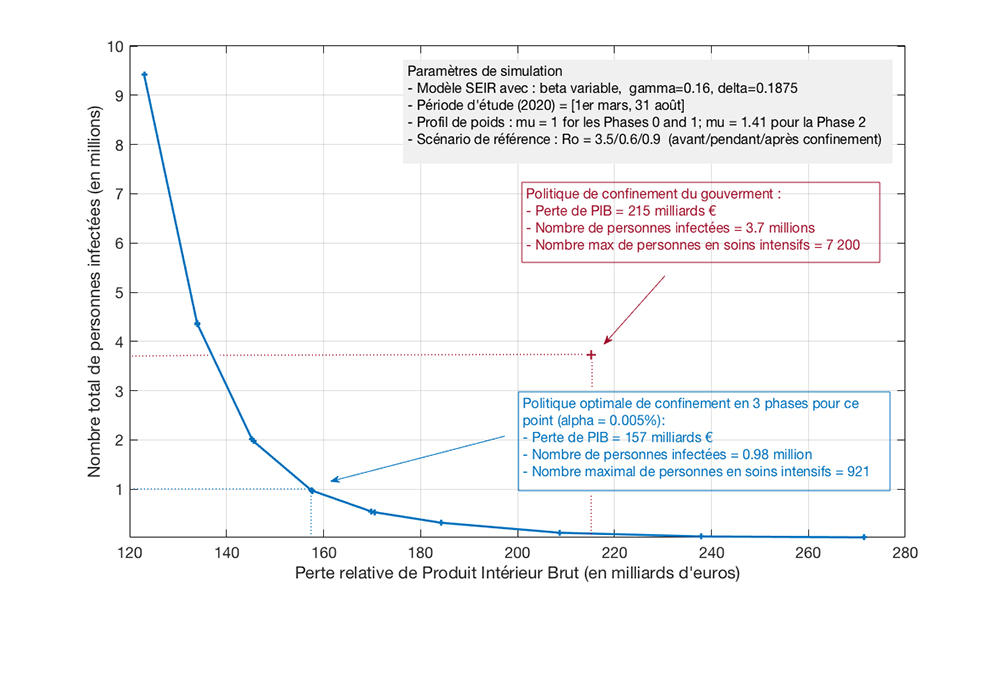

Samson Lasaulce, spécialiste en optimisation pour l’aide à la décision au Centre de recherche en automatique de Nancy4, explique que « typiquement, les algorithmes que nous élaborons permettent d’allouer une ressource en fonction d’un objectif donné et de contraintes propres au problème posé. » Par exemple, dans le cas du marketing viral, il peut s’agir de distribuer un budget publicitaire global entre différents influenceurs afin d’assurer qu’une marque touchera un maximum de clients potentiels. Le lien avec le Covid-19 ? « De la même manière, on peut se demander par exemple quelles sont les règles de confinement optimales à appliquer sur une zone géographique (dates de début et de fin, et intensité) en fonction d’un coût économique et sanitaire global sur l’ensemble du territoire. »

Ainsi, Samson Lasaulce et ses collègues Vineeth Varma et Constantin Morarescu ont commencé par plancher sur un modèle réaliste simplifié permettant de déterminer un calendrier de confinement optimal en fonction d’un ratio donné entre perte économique et coût sanitaire. À partir de là, « notre algorithme balaie toutes les possibilités afin de déterminer celle qui permet un coût minimal », précise l’informaticien. Résultat ? Les scientifiques ont ainsi pu évaluer de combien aurait pu être réduit le coût économique et sanitaire si le confinement avait démarré en France dès le début du mois de mars par rapport à celui auquel on s’attend pour les six prochains mois. Samson Lasaulce commente : « Il ne s’agit pas là de critiquer une décision politique prise dans un contexte de grande incertitude, mais de montrer comment, bien utilisé, notre outil peut aider à optimiser une décision lorsque l’objectif est clairement identifié. »

En ce sens, et pour aller au-delà d’un résultat à caractère rétrospectif, les chercheurs travaillent désormais sur une nouvelle version de leur algorithme permettant de prendre en compte non pas un, mais plusieurs niveaux de décision distincts. « Dans ce cas, on peut envisager la problématique de plusieurs pays dont les gouvernements ont posé des stratégies différentes en termes de coûts économique et sanitaire, pour lesquels on se demande quel niveau de reprise des échanges est envisageable compte tenu de ces objectifs distincts », conclut le spécialiste. ♦

_________________________________________

Une plateforme pour coordonner les compétences en modélisation

En mars, l’Institut national des sciences mathématiques et de leurs interactions (INSMI) du CNRS a lancé la plateforme Modcov19. Son but : coordonner les actions impliquant de la modélisation autour de la maladie Covid-19. Rapidement, plusieurs centaines de réponses sont parvenues, issues des communautés des mathématiques, de la physique, de la biologie, de l’informatique, des sciences de l’environnement, de l’ingénieur ou des sciences humaines. Aucun d’entre eux ne prétend détenir de solution miracle. Mais en mobilisant de nombreuses équipes sur un large front scientifique, la possibilité est ouverte de mettre sur pied des réponses originales et novatrices. Les résultats et outils susceptibles d’éclairer la décision politique sont ensuite transmis à Care, le Comité analyse, recherche et expertise chargé par le gouvernement de donner un avis éclairé sur les propositions faites par les scientifiques. La crise en cours est ainsi l’occasion de poser les premiers jalons de travaux dont les résultats permettront d’être mieux préparé pour faire face à d’autres vagues de Covid-19 ou de futures pandémies.

À lire sur le site du CNRS

"MODCOV19 : la modélisation pour mieux lutter contre la pandémie", entretien avec Jean-Stéphane Dhersin et Emmanuel Royer, directeurs adjoints scientifiques de l'INSMI.

À lire sur CNRS le journal

Des graphes pour planifier le déconfinement ?

Covid-19 : comment sont conçus les modèles des épidémies ?

- 1. Grenoble image, parole, signal automatique (CNRS/Université Grenoble-Alpes).

- 2. Carole Adam (Laboratoire d’informatique de Grenoble – LIG, CNRS/Inria/Université Grenoble-Alpes), Julie Dugdale (LIG), Clémentine Prieur (Laboratoire Jean Kuntzmann – LJK, CNRS/Inria/Université Grenoble-Alpes), Pascal Bellemain (Gipsa-lab), Didier Georges (Gipsa-lab), Christophe Prieur (Gipsa-lab), Emmanuel Witrant (Gipsa-lab), Fabrice Rastello (Inria), Reza Semani (Université de Shiraz, Iran).

- 3. Unité CNRS/Université de Paris.

- 4. Unité CNRS/Université de Lorraine.

Voir aussi

Auteur

Né en 1974, Mathieu Grousson est journaliste scientifique. Diplômé de l’École supérieure de journalisme de Lille, il est également docteur en physique.