Vous êtes ici

Supercalculateurs: les enjeux d’une course planétaire

Financé par la société civile Genci1 et installé à l'Institut du développement et des ressources en informatique scientifique (Idris), centre de calcul intensif du CNRS, le superordinateur Jean Zay prend sa place dans une course mondiale effrénée où capacité de calcul disponible rime avec puissance et compétitivité des nations. Mais avant tout, qu’est-ce qu’un supercalculateur ?

Stéphane Requena : Un supercalculateur, ou superordinateur, est un assemblage très dense de serveurs empilés les uns sur les autres et fédérés par un réseau très rapide. Il permet de traiter des problèmes inaccessibles pour un PC de bureau, en parallélisant les calculs, c’est-à-dire en donnant à chaque serveur un petit bout d’un problème à traiter. Sa puissance est mesurée en pétaflops2, c’est-à-dire en millions de milliards d’opérations par seconde. En d’autres mots, c’est un accélérateur de science et surtout un outil qui sert à toute la société.

Quels en sont les usages et que va permettre le nouveau supercalculateur Jean Zay ?

Jamal Atif3 : Les supercalculateurs permettent de faire du calcul haute performance (HPC)4, c’est-à-dire des simulations dédiées plutôt aux grands challenges scientifiques tels que les sciences du climat, les problèmes d’ingénierie au sens large, etc. Mais actuellement, il y a un besoin important de superordinateurs dédiés à l’intelligence artificielle (IA) dont les applications peuvent couvrir tous les champs disciplinaires, notamment la voiture autonome, la médecine ou encore les sciences humaines et sociales. Le nouveau supercalculateur, Jean Zay, sera une machine convergée : dédiée à la fois aux HPC et à l’IA.

S.R. : Le monde fait face à une explosion des volumes de données à traiter. Elles sont produites par les grands instruments scientifiques (satellites, télescopes, séquenceurs, etc.) mais aussi les supercalculateurs via les simulations numériques. Le milieu académique arrive aux limites de ce qu’il sait faire par des méthodes traditionnelles d’analyse des données et il faut déployer de nouvelles méthodes avec l’IA.

J. A. : En plus de l’accélération des calculs apportés par la machine, il y a surtout des problématiques scientifiques qu’on ne pouvait pas imaginer ou adresser auparavant. Dans une démarche classique, un chercheur conçoit un algorithme sur son ordinateur avant de le déployer à grande échelle. En IA, l’accès à un superordinateur est une condition sine qua none pour concevoir de nouveaux algorithmes. On change la façon dont on conçoit la science.

Quels grands domaines scientifiques en bénéficieront ?

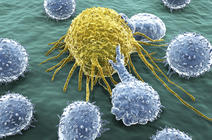

J. A. : La médecine de précision est un enjeu important des années à venir. Les technologies omiquesFermerTechnique qui permet l’analyse de quantités massives de données sur le vivant à l’échelle moléculaire, par exemple un ensemble de gènes (génomique), de l’ARN (transcriptomique), de protéines (protéomique), etc. génèrent beaucoup de données par exemple. Il y a une attente sur les algorithmes pour découvrir de nouveaux liens et connexions entre différents paramètres de santé. Un des objectifs du domaine est la conception de dosages de médicaments adaptés à des profils de personnes qui seront alors plus efficaces que des médicaments généralistes. Autres enjeux : les sciences humaines et sociales, la cybersécurité, les sciences de l’Univers ou encore les sciences du climat.

S.R. : Cela va permettre de réduire la taille des maillages pour les modèles de prévision climatique en passant à des modèles globaux précis au kilomètre contre vingt actuellement. Les modèles seront davantage prédictifs et le suivi du développement des événements extrêmes, comme des cyclones, sera affiné. C’est aussi la porte ouverte à des progrès technologiques très importants dans le domaine des nouveaux matériaux, des véhicules autonomes, de la santé/biologie et, de façon plus générale, pour l’industrie qui représente 15 % des projets bénéficiant des supercalculateurs français déjà existants. Jean Zay va également servir au domaine émergent de l’aide à la décision : comment ces supercalculateurs peuvent-ils aider les pouvoirs publics à agir suite à des risques naturels ?

Le supercalculateur Jean Zay sera-t-il amené à évoluer ?

J. A. : C’est une machine qui a une durée de vie d’environ six à sept ans. Comme le domaine évolue très vite, les machines doivent pouvoir répondre à ces évolutions pour des intérêts compétitifs.

S.R. : D’ailleurs, déployer une telle infrastructure demande un travail de veille technologique important et une préparation de presque deux ans. C’est une quincaillerie un peu complexe où chaque composant doit être validé un par un. Pour Jean Zay, nous avons un plan d'évolution des capacités de la machine avec l’ajout de technologies complémentaires dans les deux prochaines années notamment concernant la partie dédiée aux simulations numériques. Mais il faudra en faire autant côté IA avec d’autres financements de la part des pouvoirs publics. Si nous nous arrêtons au milieu du développement de cette machine, nous perdrons les efforts qui auront été déployés et tous les avantages de cet investissement initial.

Comment se situe la France par rapport au reste du monde dans le domaine des supercalculateurs ?

S.R. : La recherche française dispose de trois autres centres de calcul5. Celui qui était déjà présent à l’Idris avait une puissance de 1,5 pétaflops. La nouvelle machine aura une puissance de calcul 10 fois plus importante (14 pétaflops au lancement et 17 pétaflops fin 2019). Cette nouvelle configuration est indispensable dans un contexte de forte compétitivité européenne et mondiale. Toutes ces technologies, l’IA, le HPC et l’ordinateur quantique sont stratégiques pour les États. Et les pays investissent massivement dans les supercalculateurs qui deviennent convergés. Une course sans fin à la puissance est surtout très forte entre la Chine et les États-Unis, leader actuel avec son superordinateur Summit dont la puissance est supérieure à 200 pétaflops.

J. A. : Cette lutte sans merci doit mener au déploiement, en 2021, de machines dites « Exascale » capables de réaliser un milliard de milliards d'opérations à la seconde. C’est l’équivalent de 60 fois plus que Jean Zay. Les Américains installeront deux machines convergées IA-HPC dans deux ans qui feront 1 500 pétaflops. C’est un autre niveau mais le modèle choisi par la France est depuis longtemps adopté aux États-Unis, au Japon et en Chine.

Qu’en est-il de l’Europe ?

J. A. : Quand on regarde la stratégie IA de chaque pays au cours des deux dernières années, on distingue 40 drapeaux démontrant la mobilisation des États européens. Chacun a son plan mais on ne parvient pas encore à transformer tous ces drapeaux en un seul qui pourrait être celui de l’Union européenne. Indépendamment de la stratégie propre à chaque pays, il est nécessaire d’établir une « superstratégie », la plus globale possible. Toutefois, l’Europe manque encore d’exemples de réussite sur lesquels s’appuyer. Un projet commun autour de l’IA est peut-être une démarche qui démontrera qu’elle peut peser dans la balance, car aucun pays européen n’y arrivera seul.

S.R. : Au moment de la création de Genci (en 2007, NDLR), chaque pays a compris qu’il fallait une infrastructure européenne afin de concurrencer les grosses puissances du domaine (États-Unis, Chine, Japon). Prace, sorte de Genci européen, a ainsi été créé en 2010 grâce notamment aux apports de quatre États membres (Allemagne, France, Italie et Espagne) mais sans impulsion financière européenne suffisante pour soutenir cette ambition. Cela a changé avec le lancement, fin 2018, de l’initiative européenne EuroHPC dotée d’un milliard d’euros pour sa première phase. Elle coordonne ainsi les efforts de R&D et le déploiement de premiers supercalculateurs de classe mondiale dédiés à la recherche. Trois machines dites «pré-exascale» (autour de 200 à 300 pétaflops) vont être installées en Espagne, en Italie et en Finlande.

Dans une deuxième phase, le programme soutiendra le développement de machines Exascale (vers 2022/2023) pour lesquelles la France et l’Allemagne se sont portées volontaires pour l’hébergement. Maintenant, c'est à nous d’instituer une équipe de France regroupant tout l’écosystème des supercalculateurs avec Genci, le CNRS, le CEA, les universités, Inria et le ministère de la Recherche en vue de convaincre EuroHPC de nous confier cette machine.

L’Europe peut-elle s’inspirer des développements mis en place par les leaders mondiaux du domaine ?

J. A. : Globalement, la puissance de l'État fait avancer les choses plus vite. C’est pourquoi, il est question de « guerre stratégique ». On considère souvent que les États-Unis ont une IA business principalement développée par les mastodontes du numérique. Mais les mentalités changent et il y a une sorte de conscience collective qui émerge sur des enjeux autour de la donnée. L'Europe a toujours occupé une position délicate de barycentre. Mais il est possible de concevoir une IA compétitive, qui génère du business, tout en étant éthique. L'IA reste un domaine de recherche. Il faut mesurer les avancées qui ont été réalisées : des algorithmes performants qui savent reconnaître un chat d'un chien ou jouer au Go. Les déployer dans des domaines critiques comme la santé, la cybersécurité demande encore beaucoup de recherches. Il y a notamment un modèle économique et sociétal à développer autour de la notion de confiance. L’Europe peut faire du machine learning qui accroît la confiance, travailler sur la transparence des algorithmes et préparer des IA éthiques à condition de s’y atteler.

S.R. : Néanmoins, un des enjeux est de ne pas subir les évolutions de l’IA comme cela a été le cas avec le numérique. Il faut se doter de tous les moyens : humains, matériels dont les supercalculateurs et un circuit de prises de décisions politiques agiles afin de ne plus subir ces changements.

De quoi a besoin l’Europe pour devenir un acteur important dans cette course à la puissance de calcul ?

S.R. : Il y a clairement un enjeu qui consiste à marier à la fois de la technologie européenne à des infrastructures très puissantes au service des applications scientifiques européennes. Actuellement, le seul producteur européen de supercalculateur de classe Exascale est l’entreprise française Atos-Bull. S’émanciper des autres puissances du calcul nécessite une industrie européenne forte et indépendante. Dans les affrontements entre les leaders mondiaux, les États-Unis imposent par exemple des embargos sur des processeurs à la Chine. L’Europe n’est pas à l’abri d’une telle manœuvre.

J. A. : Il y a une guerre technologique alors que le numérique commissionne tout, il faut maîtriser les technologies de bout en bout. Cela va du hardware jusqu'à la conception d’algorithmes. Autrement l’Europe continuera à subir. Il en va de notre souveraineté car dépendre des autres puissances c’est aussi prendre du retard, être moins compétitif en termes d’innovation, de recherche et pour l’économie de manière générale.

D’autres acteurs que les États sont-ils impliqués dans cette course ?

J. A. : La course aux supercalculateurs n’est pas uniquement entre des puissances étatiques mais aussi avec des puissances privées que sont les Gafam6 américains et les BATX7 chinois. Ces dernières détiennent des avancées en IA et ont des capacités de calcul auxquelles la recherche est loin d’avoir accès. Ce serait une erreur vis-à-vis de nos concitoyens de laisser l’IA, et tous les enjeux sociétaux qui en découlent, se développer dans un cadre privé. Il est impératif de rester dans la course à la production d’algorithmes.

S.R. : Il y a aussi des industriels comme Total (avec sa machine IBM Pangea III qui est classée 11e au dernier top 500 de juin 2019), EDF, Airbus, Safran, Renault… qui investissent fortement dans le calcul intensif en termes de moyens de calcul et d’applications. Disposer à la fois d’infrastructures publiques mais aussi de moyens opérés par des industriels, sans oublier aussi, dans le domaine du Cloud, un acteur comme OVH8, constitue un véritable atout pour notre pays. ♦

- 1. Grand équipement national pour le calcul intensif

- 2. Le préfixe péta signifie 10 puissance 15, c’est-à-dire un million de milliards, et flops est l’acronyme de FLoating point Operations Per Second, « opérations à virgule flottante par seconde ».

- 3. Jamal Atif, professeur à l’Université Paris-Dauphine, travaille au Laboratoire analyses et modélisation de systèmes pour l’aide à la décision (CNRS/Université Paris-Dauphine), et à l’Institut des sciences de l’information et de leurs interactions du CNRS.

- 4. Pour High Performance Computing.

- 5. Occigen est installé au Centre informatique national de l’enseignement supérieur (Cines), à Montpellier (3,5 pétaflops), Joliot-Curie installé au sein du Très Grand Centre de calcul du CEA (TGCC), à Bruyères-le-Châtel (Essonne), et Jean Zay à l'Idris.

- 6. Acronyme des géants du Web (Google, Apple, Facebook, Amazon et Microsoft).

- 7. Sigle qui désigne les géants du Web chinois dans les années 2010 (Baidu, Alibaba, Tencent et Xiaomi).

- 8. Entreprise française spécialisée dans les services de Cloud Computing («informatique en nuage»), fondée en 1999 par Octave Klaba, qui propose des solution de stockage et d'exploitation des données.

Voir aussi

Auteur

Après des études en environnement à l'Université Paul-Sabatier, à Toulouse, puis en journalisme scientifique à l'Université Paris-Diderot, à Paris, Anaïs Culot a été attachée de presse au CNRS et collabore à présent avec différents magazines, dont CNRS Le Journal, I'MTech et Science & Vie.