Vous êtes ici

Ces constantes qui donnent la mesure

En physique, comme dans la vie quotidienne, mesurer revient à déterminer le rapport entre deux quantités de même nature dont l’une – supposée constante – fait office d’étalon ou d’unité. Le corps humain a longtemps fourni des étalons pratiques et toujours disponibles pour, par exemple, mesurer en pieds, en pouces ou en coudées, la distance entre deux objets. L’ennui avec ce genre d’étalon est que si tout le monde a un pied, tout le monde n’a pas la même pointure. Pour rendre fiables et comparables les mesures, mais aussi faciliter les échanges, il faut assurer un minimum de constance… On a donc fini par adopter des étalons de longueur fondés sur un pied invariant, connu et reconnu par le plus grand nombre – en l’occurrence, en France, celui du roi. Le défaut majeur de ce système était que selon le pays, la région ou même l’époque, l’étalon pied n’était pas le même : le pied romain était plus court que le pied anglais, lui-même moins grand que le pied du roi français. Le problème était d’ailleurs le même avec les unités de poids et de volume, qui elles aussi reposaient sur des étalons anthropomorphiques tels que la livre ou la poignée. Avec l’essor des sciences et des échanges internationaux, le besoin d’unités plus précises et plus universelles s’est fait de plus en plus sentir tout au long du siècle des Lumières.

Du système royal à la mécanique quantique

Les révolutionnaires français, qui comptaient parmi eux de nombreux scientifiques et qui venaient de couper la tête de Louis XVI, ont donc dans la foulée aboli le pied du roi. Près de 800 unités alors en usage sur le territoire ont été remplacées par un tout nouveau système d’unités décimales : mètre, kilogramme et seconde. Celles-ci ne se référaient plus à des étalons anthropomorphiques, mais pour la première fois à des valeurs astronomiques mesurées précisément et que l’on considérait alors comme constantes, naturelles et universelles telles la durée d’un jour terrestre ou la longueur d’un méridien. Depuis, le système métrique a connu de multiples évolutions et redéfinitions, mais il s’est toujours, même indirectement, reposé sur des constantes physiques. « Un système d’unités est une construction humaine et les définitions du Système international se sont donc à l’origine appuyées sur la physique classique. Les changements successifs de définition ont découlé de la volonté d’utiliser des mesures plus stables et plus fondamentales, accompagnant ainsi les progrès de la physique », explique Jean-Philippe Uzan, physicien à l’Institut d’astrophysique de Paris1. Pas étonnant dès lors que la future révision du Système international (SI) fasse la part belle aux constantes issues de la mécanique quantique et de la relativité.

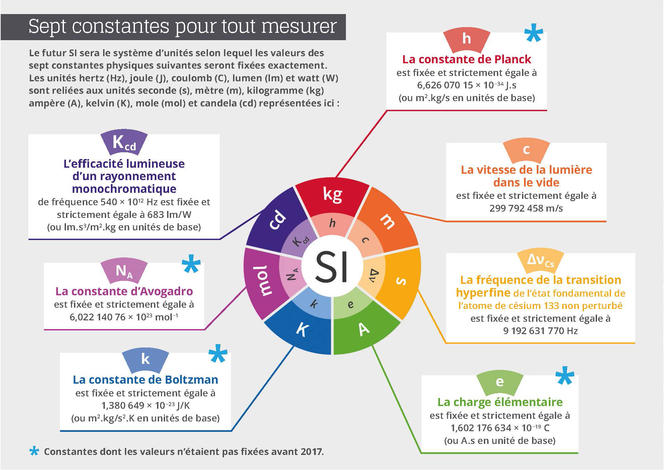

Des unités nées des constantes

La redéfinition des sept unités de base (mètre, kilogramme, seconde, ampère, kelvin, mole et candela) reposera donc sur une formulation à constante explicite, c’est-à-dire une définition dans laquelle l’unité est définie indirectement en donnant une valeur exacte à une constante fondamentale reconnue. « Nous définissons comme constante fondamentale d’une théorie physique tout paramètre dont cette théorie ne peut prédire la valeur », précise Jean-Philippe Uzan2. Cette valeur ne peut donc être obtenue qu’empiriquement, par une mesure. Les progrès de l’instrumentation ont d’ores et déjà permis des mesures suffisamment précises pour que l’on décide d’établir conventionnellement des valeurs exactes pour certaines d’entre elles. Ainsi, après la valeur de c, la vitesse de la lumière, fixée depuis 1983, c’est au tour de h, la constante de Planck, de e, la charge électrique de l’électron, de k, la constante de Boltzman, et de NA, la constante d’Avogadro, d’être désormais gravées dans les tables du SI.

La Conférence générale des poids et mesures (CGPM) a ainsi fourni une feuille de route très détaillée sur la manière dont les différentes constantes fondamentales impliquées dans le nouveau SI devraient être remesurées, avant de fixer leurs valeurs numériques de manière définitive. Par exemple, pour la constante de Planck, la CGPM a exigé deux méthodes indépendantes, chacune mise en œuvre dans plusieurs laboratoires de métrologie à travers le monde. La première est fondée sur une balance de Kibble (dite aussi « balance du watt »), qui permet d’équilibrer des masses avec des forces électromagnétiques. La seconde consiste à compter les atomes d’une sphère de silicium de 10 centimètres de diamètre pour définir la constante d’Avogadro, puis en déduire une valeur de la constante de Planck en utilisant d’autres constantes fondamentales connues.

Là encore, les discussions ont été tendues. « Les deux méthodes ne donnent pas exactement le même résultat. Du coup, certains auraient préféré retarder un peu l’échéance pour adopter le nouveau système », relève Christian Bordé, président du Comité science et métrologie de l’Académie des sciences. Pour autant, « les différentes mesures sont toutes dans les marges d’erreur fixées par le Comité consultatif des masses et des grandeurs associées », précise François Nez, du Laboratoire Kastler-Brossel (LKB)3, et membre du Comité des données pour la science et la technologie (Codata). Une façon de dire qu’il faut bien finir par trancher.

Pour la petite histoire, c’est une équipe française du Laboratoire commun de métrologie LNE-Cnam qui a fourni la valeur de la constante de Boltzmann (k) avec l’incertitude relative la plus faible, soit 0,57x10-6, inférieure d’un facteur trois à l’état de l’art antérieur. Si bien que la valeur obtenue par les physiciens français contribuera pour 55 % de la valeur de k, qui sera in fine gravée dans le marbre. Par ailleurs, la France contribue à la valeur de h grâce à la balance de Kibble du Laboratoire national de métrologie et d’essais (LNE) de Trappes (Yvelines), et la mesure d’autres constantes fondamentales au LKB.

Précisément, ces ajustements fins sont l’œuvre du Codata, chargé de tenir à jour la liste et la valeur des constantes fondamentales de la physique depuis 1966. « Notre travail consiste à réaliser la synthèse des différentes mesures jugées valides pour déterminer les constantes fondamentales. Leurs valeurs les plus probables sont obtenues par un ajustement de type “moindres carrés” à partir de toutes les mesures et des relations de la physique qui relient ces constantes. On garantit ainsi la cohérence de l’ensemble », explique François Nez. Cohérence que le Comité international des poids et mesures a jugée suffisante fin 2017 lors de sa 106e session, prenant acte que les conditions fixées pour procéder à la révision du SI étaient remplies, ce qui a ouvert la voie à l’adoption du nouveau système par la CGPM prévue en novembre.

Des valeurs non calculables

« La valeur numérique de n’importe quelle constante dépend complètement du système d’unités choisi », rappelle toutefois Jean-Philippe Uzan. Par exemple, les physiciens des hautes énergies ont parfois recours aux unités de Planck, pour lesquelles les valeurs des constantes h, c et G sont par convention toutes fixées à 1, ce qui simplifie considérablement l’écriture des équations décrivant les lois physiques… mais donne des unités peu pratiques dès qu’on quitte le domaine de l’infiniment petit.

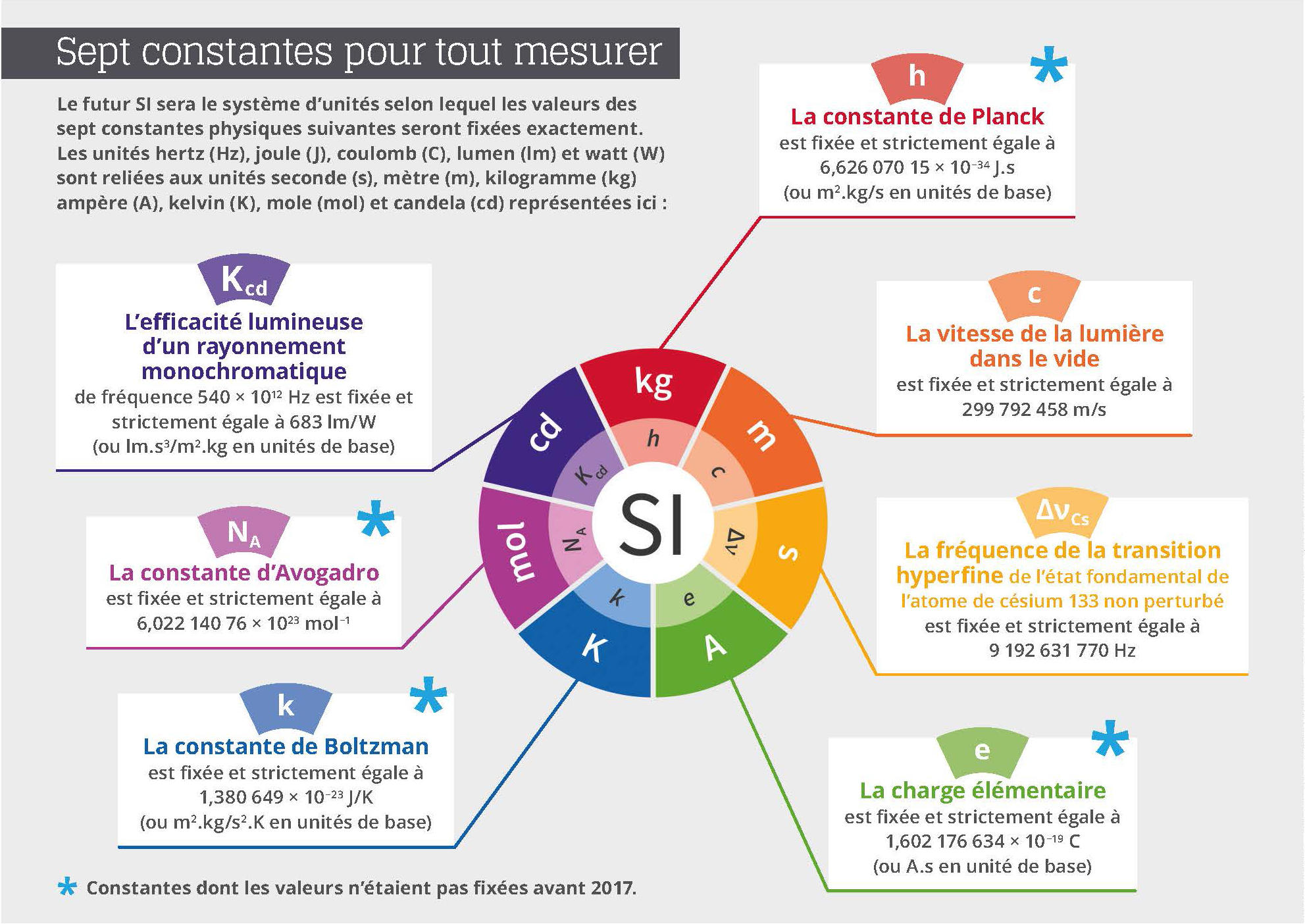

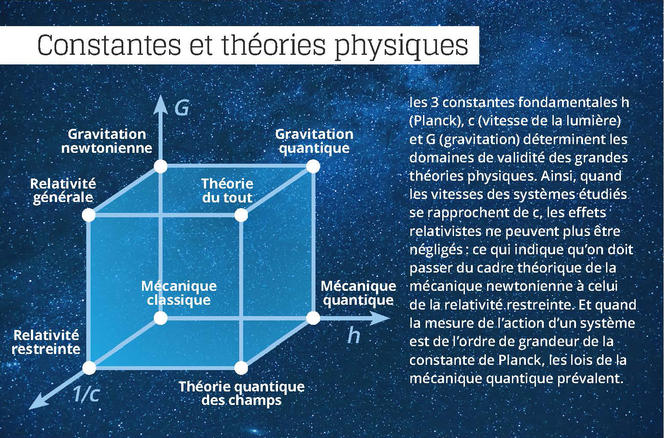

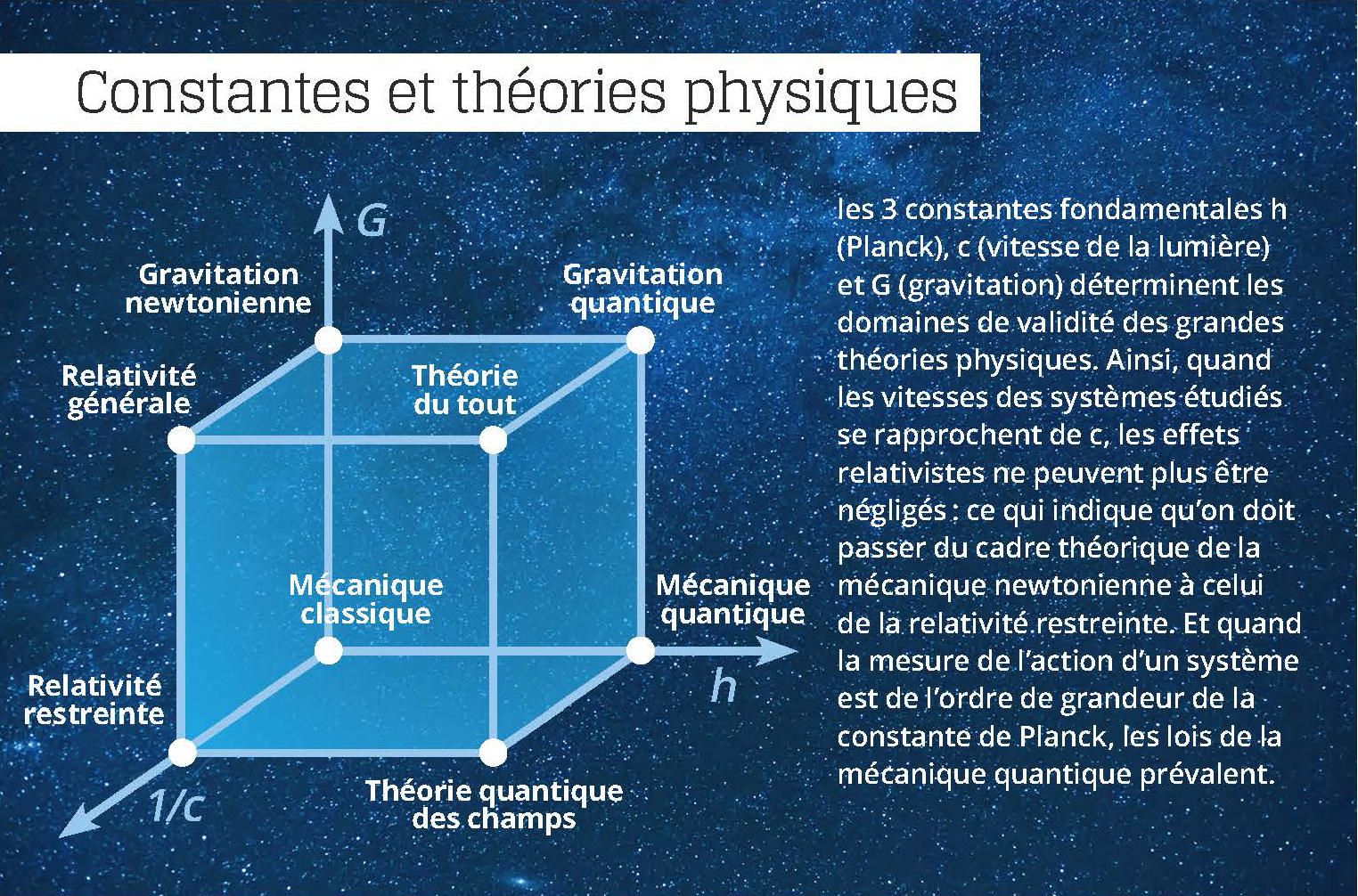

Le physicien et épistémologue Jean-Marc Lévy-Leblond4 note que « ces constantes universelles ne jouent pas seulement un rôle d’étalon dans la définition et la mesure des quantités physiques. Elles sont en outre utilisées comme normes de validité pour les théories physiques. Cet aspect se résume souvent dans des assertions telles que : “la relativité galiléenne est obtenue à partir de la relativité einsteinienne quand la constante c tend vers l’infini”, ou encore : “la mécanique quantique se ramène à la mécanique classique lorsque la constante de Planck tend vers zéro”. »

Les constantes « exactes » fixée par le SI ne sont en fait qu’un sous-ensemble de la trentaine que l’on retrouve dans les équations décrivant les lois physiques qui régissent notre Univers : cela va de la constante de gravitation aux masses des particules élémentaires en passant par les constantes de couplage des différentes forces de la nature. Ne pouvant pas être calculées, ces constantes fondamentales soulignent aussi les limites de nos théories physiques. « La plupart des physiciens sont convaincus qu’une future théorie des particules fondamentales expliquera (ou du moins devrait expliquer) la diversité de leurs masses à partir de quelques constantes d’un niveau plus profond, que ce soit les masses de constituants plus élémentaires, ou une certaine longueur caractéristique, relève ainsi Jean-Marc Lévy-Leblond. Quand on aura construit cette théorie, ces masses sortiront complètement du tableau des constantes fondamentales, et leur statut deviendra celui de quantités dérivées. »

Synthétiser des concepts

Le nombre et le statut des constantes auxquelles ont recours les physiciens reflètent l’évolution des théories physiques en rendant explicite l’unité de certains phénomènes physiques. « En établissant des ponts entre des quantités autrefois jugées incommensurables, les constantes permettent l’émergence de nouveaux concepts, remarque Jean-Philippe Uzan. Par exemple, c fait la synthèse entre espace et temps, la constante de Planck h permet de relier les concepts d’énergie et de fréquence et la constante gravitationnelle G crée un lien entre matière et espace-temps. » Une unification conceptuelle qui change le statut des constantes en question et peut même aboutir à l’abandon de certaines grandeurs et unités. « La découverte par Joule du fait que chaleur et énergie étaient deux formes d’énergie a fait que la constante de Joule, qui exprime la proportionnalité entre travail et chaleur, a perdu tout sens physique et qu’elle est devenue un simple facteur de conversion entre unités mesurant la chaleur (calories) et le travail (joule). De nos jours la calorie est devenue obsolète. » ♦

_______________________________

Pour aller plus loin

« Sur mesure, les 7 unités du monde », exposition au musée des Arts et Métiers, à Paris, du 16 octobre 2018 au 5 mai 2019. Elle explore en cinq chapitres l’omniprésence de la mesure dans notre quotidien, son histoire, sa symbolique, la complexité de l’acte de mesurer à travers la profusion des instruments présentés et enfin ses applications dans de nombreux secteurs d’activités. Des vidéos invitent le visiteur à « rencontrer » chercheurs et spécialistes pour comprendre pourquoi et comment sont définies les sept unités fondamentales qui nous permettent de quantifier le monde. Conçue par le Conservatoire national des arts et métiers avec le Laboratoire national de métrologie et d’essais , et dont le CNRS est partenaire, elle vient en écho à la 26e réunion de la Conférence générale des poids et mesures qui, du 13 au 16 novembre 2018 à Versailles, officialisera les nouvelles définitions du kilogramme, de l’ampère, du kelvin et de la mole.

« Tous mesureurs, tous mesurés. La science au cœur de la société », collogue organisé par le CNRS les 18 et 19 octobre, au siège de l'organisme (3 rue Michel-Ange, 75016 Paris). Au grogramme : une réflexion interdisciplinaire sur le rôle et les enjeux de la mesure pour les sciences et un espace « démo » présentera aux visiteurs innovations, expériences et dispositifs autour de la mesure.

https://mesures.sciencesconf.org

- 1. Unité CNRS/Sorbonne Université.

- 2. «Varying Constants, Gravitation and Cosmology», Jean-Philippe Uzan, «Living Rev. Relativ.», 2011, 14: 2. https://doi.org/10.12942/lrr-2011-2

- 3. Unité CNRS/ENS/UPMC/Collège de France.

- 4. «Sur la nature conceptuelle des constantes physiques», J.-M. Lévy-Leblond, «Cahiers philosophiques», 2013, vol. 135 (4) : 92-112.