Vous êtes ici

Trouble dans la cosmologie

Temps de lecture : 12 minutes

La cosmologie est en crise ! Au cœur du problème : la vitesse d’expansion de l’Univers qui, tel un gigantesque ballon de baudruche enfle encore et encore depuis 13,8 milliards d’années. Quand les astrophysiciens mesurent avec leurs télescopes le taux actuel de cette expansion, connue sous le nom de constante de Hubble (ou H0), ils trouvent une valeur incompatible avec celle prédite par le modèle standard de la cosmologie, la théorie qui décrit le mieux pour l’instant l’histoire de l’Univers, depuis son origine (le Big Bang) et les premiers atomes jusqu’à aujourd’hui, en passant par les premières étoiles et galaxies. Ce désaccord n’est donc pas anodin : il pourrait signifier que ce modèle, qui fait jusqu’ici consensus, est à revoir. Rien de moins. Sauf si une erreur s’est glissée dans les mesures. Le débat fait rage actuellement chez les scientifiques qui tentent par tous les moyens de résoudre la « tension de Hubble » comme ils l’ont baptisée.

Méthodes de mesure

C’est l’astronome américain Edwin Hubble qui a été le premier à estimer la valeur de la constante qui porte aujourd’hui son nom. En 1929, il observe que les galaxies s’éloignent de nous, et ce d’autant plus vite qu’elles sont lointaines – le rapport entre la vitesse de fuite d’une galaxie et sa distance donne H0. La découverte, qui implique que l’Univers est en expansion, est au fondement même de l’idée du Big Bang et marque le début de la cosmologie moderne. D’où l’importance pour les astronomes de mesurer précisément la valeur de ce paramètre. D’autant que pour venir compliquer encore plus l’affaire, les astrophysiciens savent aussi, depuis vingt-cinq ans, que l’expansion cosmique va en accélérant, sous l’effet d’une mystérieuse énergie noire, qui représenterait deux tiers du contenu de l’Univers et dont la nature reste inconnue. Depuis les premières observations historiques, l’amélioration des techniques a permis d’affiner considérablement la mesure de la constante. Deux méthodes sont principalement utilisées aujourd’hui pour la déterminer.

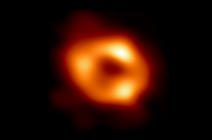

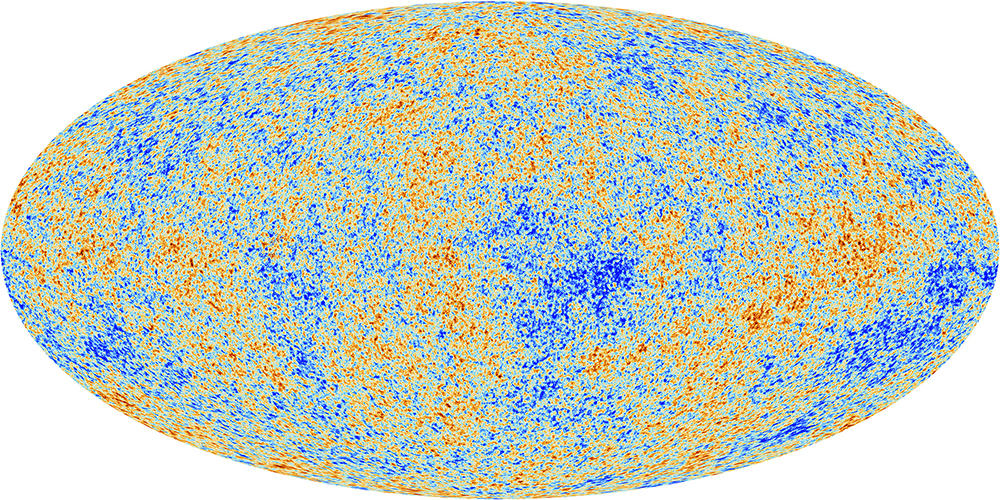

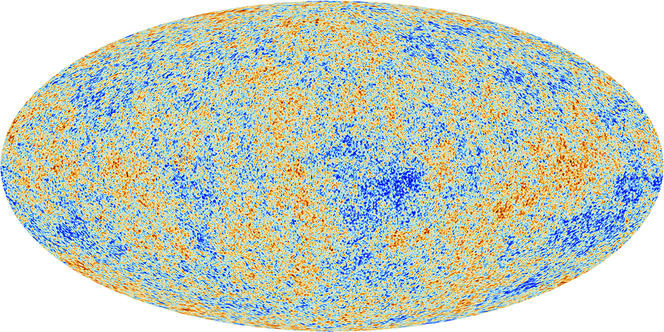

La première repose sur l’analyse du fond diffus cosmologique, première lumière émise par l’Univers, lorsque celui-ci était âgé de 380 000 ans. Ce rayonnement est toujours visible aujourd’hui et on a pu le cartographier en détail, notamment grâce au satellite européen Planck. En reconstituant ainsi les conditions qui régnaient dans l’Univers primordial, on a alors pu prédire, dans le cadre du modèle cosmologique, le taux d’expansion qu’on devrait observer aujourd’hui. Résultat : selon les données de Planck publiées en 2020, H0 est égale à 67,4 kilomètres par seconde par mégaparsec (Mpc) – un parsec correspondant à une distance de 3,26 années-lumière. Cela veut dire que sur une telle distance, l’Univers grandit de 67,4 km toutes les secondes. Et donc qu’une galaxie aussi distante s’éloigne de nous à cette vitesse.

La seconde méthode, elle, consiste à mesurer directement H0 en observant les galaxies autour de nous. Pour cela, il faut déterminer à la fois la vitesse d’éloignement d’un grand nombre de ces objets et aussi leur distance, comme l’a fait en son temps Edwin Hubble. La première étape, la vitesse d’éloignement, ne pose pas de problème, grâce au décalage vers le rouge du spectre lumineux des galaxies : plus l’une d’entre elles s’éloigne vite et plus ce décalage spectral est important.

Chandelles standards et échelle des distances

En revanche, la seconde étape qui consiste à mesurer la distance d’un astre est, elle, plus difficile. Pour y parvenir, les astronomes utilisent ce qu’ils appellent des chandelles standards. « Ce sont des objets dont on connaît la luminosité absolue. En comparant celle-ci à l’intensité lumineuse reçue sur Terre, on peut déterminer la distance qui les sépare, et donc la distance de sa galaxie », explique Mickaël Rigault, de l’Institut de physique des deux infinis de Lyon1. Les céphéides, des étoiles variables dont la fréquence de pulsation lumineuse est reliée à leur luminosité absolue – une loi établie en 1908 par l’astronome américaine Henrietta Leavitt –, constituent de telles chandelles. Si tant est, bien sûr, qu’on étalonne au préalable la luminosité intrinsèque de certaines d’entre elles en mesurant directement leur distance par une méthode géométrique, comme la parallaxe. C’est avec ces étoiles que Hubble a obtenu une estimation de la vitesse d’expansion cosmique.

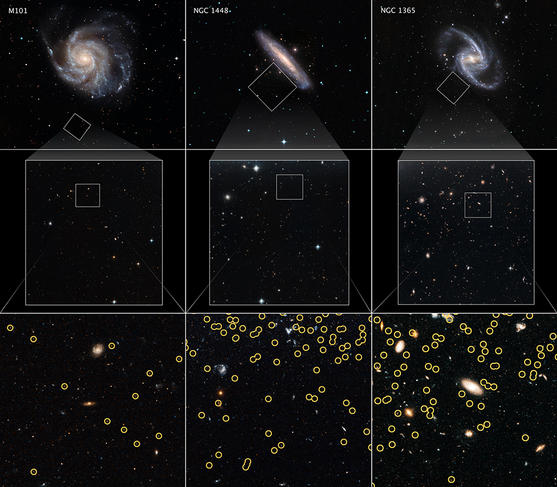

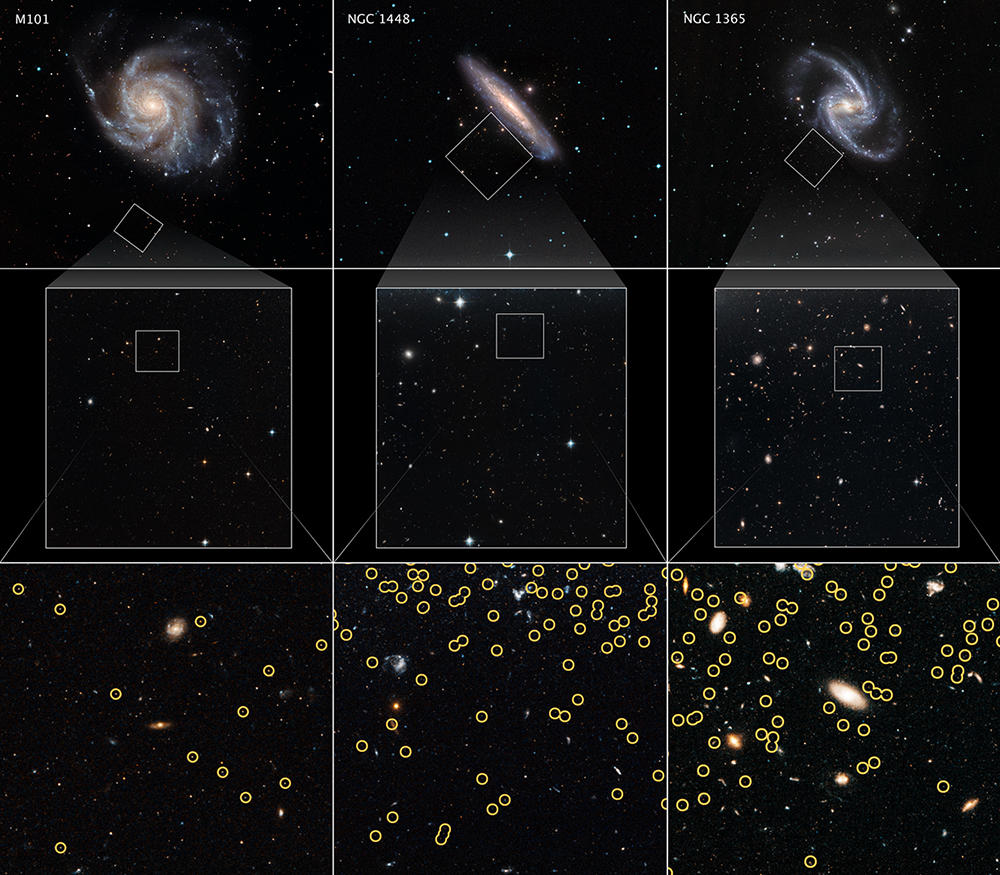

Les astronomes d’aujourd’hui ont repris cette même technique mais ils l’ont améliorée en utilisant un deuxième type de chandelles standards, plus lointaines encore que les céphéides : les supernovas dites de « type Ia », des explosions d’étoiles en fin de vie qui deviennent subitement aussi lumineuses que des milliards de soleils pendant quelques semaines. Tout comme pour les céphéides, la luminosité exacte de ces supernovas doit être calibrée. Pour ce faire, on utilise des céphéides présentes dans des galaxies proches où sont aussi observées des supernovas.

« De cette manière, on construit une sorte d’échelle des distances cosmologiques où chacun des barreaux permet de mesurer la distance d’objets de plus en plus lointains et ainsi de déterminer la constante de Hubble avec une grande précision », résume Mickaël Rigault. Dernière en date, la mesure de H0, obtenue par la collaboration Shoes menée par l’Américain Adam Riess, qui utilise cette méthode de l’échelle des distances, donne ainsi une valeur de 73 km/s/Mpc.

Écart inexplicable et grain de poussière cosmique

À première vue, l’écart avec la mesure issue de l’analyse du fond diffus cosmologique semble faible. Mais si on prend en compte les incertitudes, les deux estimations sont irréconciliables. « Il y a quelques années encore, le doute était permis sur la réalité de cette anomalie. Mais les mesures de H0 sont devenues aujourd’hui si précises qu’il existe moins d’une chance sur un million pour que ce désaccord soit dû au hasard. C’est très excitant, car cela pourrait signifier que le modèle de la cosmologie est incomplet et que nous devons envisager une nouvelle physique », avance Vivian Poulin-Détolle, du Laboratoire Univers et particules de Montpellier2.

Un constat renforcé par le fait que d’autres mesures obtenues par des méthodes indépendantes arrivent à une valeur de H0 compatible avec celle déterminée grâce aux céphéides et aux supernovas. C’est notamment le cas de l’expérience Holicow qui traque des quasars lointains, galaxies au noyau très actif et extrêmement lumineux. Lorsqu’une grosse galaxie se trouve sur la ligne de visée entre nous et un quasar, celle-ci dévie la lumière de l’astre au point d’en faire apparaître des images multiples, par un effet dit de « lentille gravitationnelle ». Quand le quasar émet un flash de lumière, celui-ci est visible sur les images mirages mais avec un léger retard les unes par rapport aux autres car les trajets empruntés par la lumière ne sont pas de la même longueur. En mesurant ce retard, on peut alors estimer H0, sans recourir à un étalon de distance. Résultat de Holicow : 73,3 km/s/Mpc, soit très proche de la mesure de Shoes.

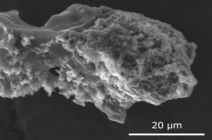

Reste « qu’avant de changer le modèle standard de la cosmologie, qui parvient à prédire de nombreuses observations, il faut s’assurer que cette tension ne vient pas d’erreurs de mesure », prévient Mickaël Rigault. Les astronomes savent bien en effet que les astres qu’ils utilisent comme chandelles standards ne sont pas des objets parfaits. Ainsi l’aspect terne de l’une d’entre elles n’est pas nécessairement dû à son éloignement. La poussière cosmique peut aussi être en cause, faisant paraître des étoiles plus lointaines qu’elles ne le sont vraiment.

Sans oublier que ces objets peuvent connaître des variations dues à leur âge ou à leur métallicité (leur contenu en atomes plus lourds que l’hélium). Tous ces effets sont pris en compte et corrigés par les astrophysiciens. Mais ces derniers ne sont pas à l’abri d’erreurs ou d’effets inconnus qui leur auraient échappé.

Nouvelles mesures à la rescousse

D’ici à cinq ans, de nouvelles observations pourraient permettre d’y voir plus clair. Grâce au Zwicky Transient Facility (ZTF), un relevé astronomique de tout le ciel de l’hémisphère Nord réalisé à l’observatoire Palomar en Californie, un catalogue de 3 000 supernovas a été constitué, ce qui permettra de mesurer H0. « C’est dix fois plus que ce qui est fait aujourd’hui avec Shoes. Qui plus est, tous ces objets ont été détectés avec le même instrument, contrairement aux autres catalogues qui ont été établis en une vingtaine d’années à partir de différentes observations. De quoi s’affranchir de nombreuses sources d’erreurs possibles », se réjouit Mickaël Rigault, responsable de ZTF pour la France.

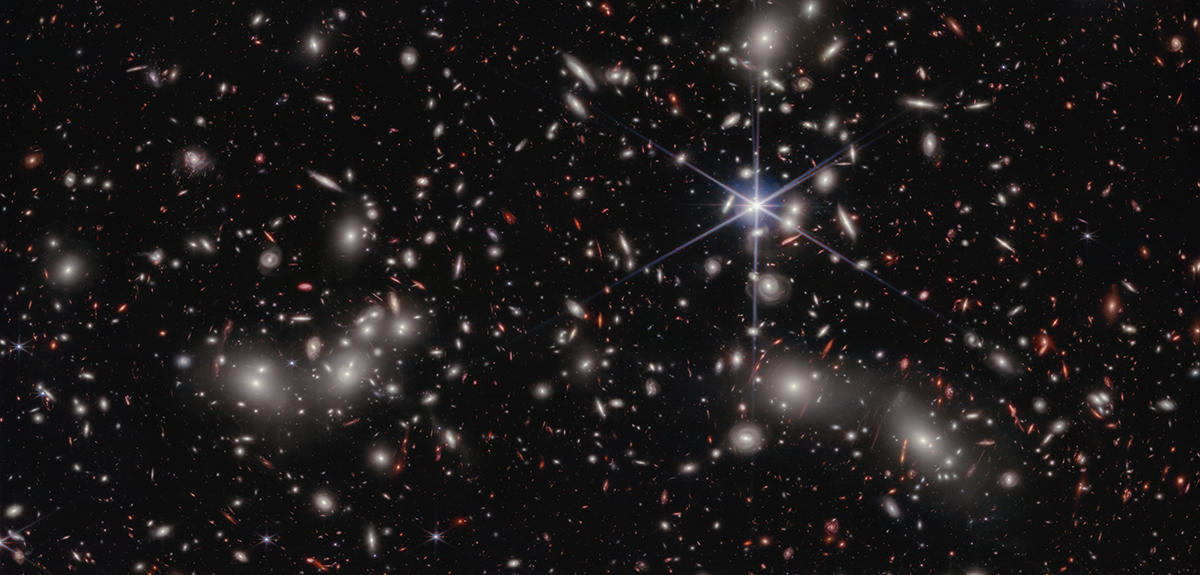

L’étape suivante sera d’étalonner la luminosité des supernovas grâce à des étoiles géantes rouges, un nouveau type de chandelles standards que certains utilisent à la place des céphéides. Pour cela, l’équipe de Mickaël Rigault a fait une demande d’observation sur le télescope spatial James Webb. Si cette demande est acceptée, les astronomes pourront alors déterminer la valeur de H0. Et si le résultat confirme la mesure de Shoes, alors cela ferait plus encore pencher la balance du côté d’une nouvelle physique, au-delà du modèle standard.

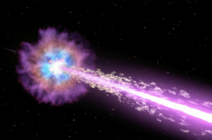

Les astronomes attendent également beaucoup de la détection des ondes gravitationnelles. En 2017, l’observation par Ligo et Virgo de telles ondes issues de la fusion de deux étoiles à neutrons, associée à la détection de lumière par les télescopes de ce même événement, a fourni une nouvelle manière de mesurer H0 – les ondes gravitationnelles permettant de déduire la distance de la source et la lumière sa vitesse d’éloignement. Avec un seul événement de ce type enregistré, la précision n’est pas encore suffisante mais dans un futur proche on s’attend à en détecter de nombreux autres. La nouvelle mesure obtenue sera alors clé pour trancher le débat.

Réflexion autour de nouveaux scénarios

Mais d’ores et déjà, sans attendre le fin mot de l’histoire, les théoriciens se penchent sur de nouveaux scénarios cosmologiques qui permettraient d’expliquer la tension. « Les modèles qui sont aujourd’hui favorisés font l’hypothèse d’un ingrédient supplémentaire qui aurait été présent dans l’Univers jeune, vers 380 000 ans après le Big Bang, et qui aurait donné un coup de fouet à l’expansion de l’Univers », confie Vivian Poulin-Détolle. Plusieurs pistes sont évoquées : l’existence d’un nouveau type de neutrino, le fait que les lois de la gravitation étaient différentes dans l’Univers primordial, ou encore la possibilité que l’énergie noire ait joué un rôle essentiel à cette époque.

C’est cette dernière idée que creuse le chercheur français. Récemment, il a proposé un modèle faisant appel à une énergie noire précoce qui aurait été plus grande par le passé, contribuant à l’expansion de l’Univers pour 10 %, avant de devenir l’énergie noire dont on mesure les effets aujourd’hui. Selon son concepteur, cette solution théorique aurait laissé des traces claires dans la première image de l’Univers, le fond diffus cosmologique, que les successeurs de Planck, l’Atacama Cosmology Telescope, installé au Chili, et le South Pole Telescope, situé au pôle Sud, pourraient facilement repérer dans les prochaines années.

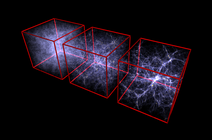

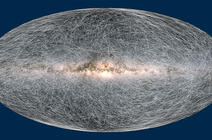

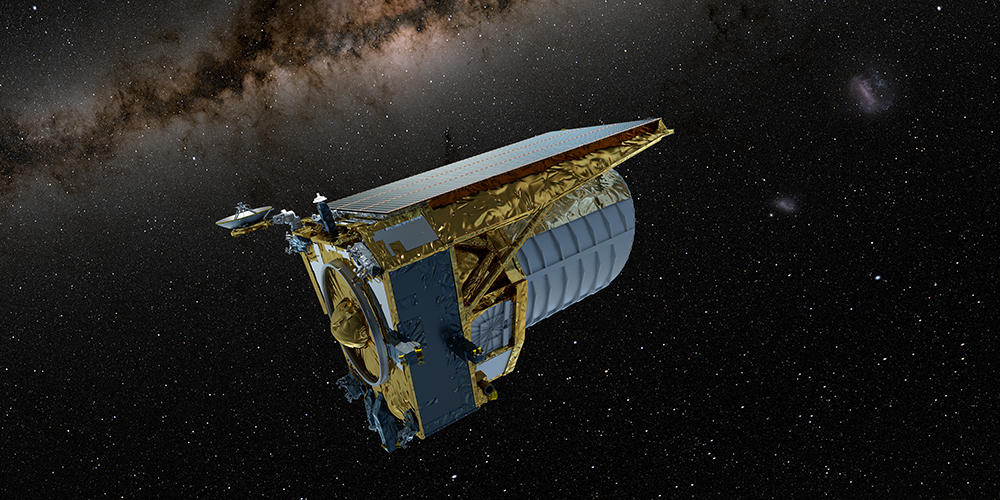

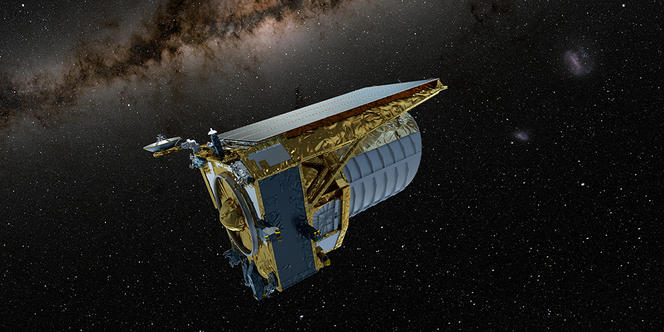

Et d’autres observations encore pourraient donner du grain à moudre aux partisans d’une nouvelle physique. Dans l’espace et au sol, le télescope européen Euclid, dont le lancement est prévu en juillet prochain, et le Vera Rubin Observatory, un télescope américain installé au Chili, qui débutera ses observations un an plus tard, cartographieront le ciel avec une précision inédite. À eux deux ils catalogueront plusieurs milliards de galaxies de manière à révéler dans le détail la façon dont elles sont organisées dans l’Univers.

Car en plus de la tension de Hubble, une autre anomalie commence à poindre, certes beaucoup moins forte : les observations semblent indiquer que les grandes structures galactiques (galaxies et amas de galaxies) sont moins concentrées que ne le prédit le modèle standard. Avec ces grands relevés, on sera fixé une fois pour toute. Et on aura une preuve de plus que les cosmologistes doivent revoir leur copie. « La fissure ouverte par la constante de Hubble est une véritable opportunité. Le modèle standard a beau très bien fonctionner, ses ingrédients principaux (l’énergie noire et la matière noire), qui composent 95 % de l’Univers nous sont inconnus. Grâce à cette crise, nous sommes peut-être sur le point de lever le mystère de leur nature fondamentale », conclut Vivian Poulin-Détolle. ♦

Voir aussi

Auteur

Julien Bourdet, né en 1980, est journaliste scientifique indépendant. Il a notamment travaillé pour Le Figaro et pour le magazine d’astronomie Ciel et Espace. Il collabore également régulièrement avec le magazine La Recherche.