Vous êtes ici

Des machines enfin intelligentes ?

En moins d’une décennie, les ordinateurs, qui s’étaient jusque-là contentés de se substituer à nos matériels de bureau, dispositifs de communication, outils graphiques, lecteurs/éditeurs de médias et appareils de loisirs, se sont mis à disputer au cerveau humain la capacité de battre des champions de poker, traduire correctement des textes, reconnaître des visages, conduire des voitures, tenir une conversation (presque) sensée, voire anticiper nos désirs. Des progrès réels et fulgurants qui pourraient annoncer l’âge d’or maintes fois reporté de l’intelligence artificielle (IA), une discipline dont les déceptions semblaient à la mesure des espoirs suscités. Les GafamFermerAcronyme formé des initiales des géants du Net, Google, Amazon, Facebook, Apple et Microsoft., dont la valorisation est intimement liée à ces progrès, investissent aujourd’hui massivement dans les laboratoires d’intelligence artificielle. Ils nous promettent pour bientôt des machines non seulement capables de trier, d’analyser et d’interpréter, mieux que nous le pouvons, les masses de données que nous produisons en continu, mais aussi de nous aider à prendre nos décisions quand il s’agit de choisir un partenaire ou une musique, voire d’agir pour nous comme robots ou véhicules autonomes.

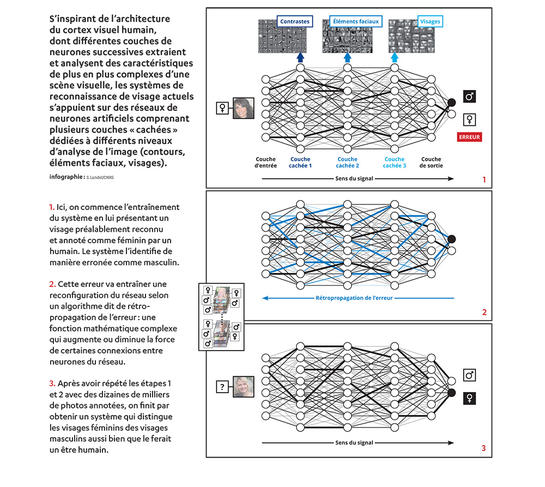

Mais d’où vient au juste cette brusque, soudaine et parfois inquiétante bouffée d’intelligence des machines ? « Les problématiques pratiques de l’IA actuelle sont les mêmes que celles définies il y a soixante ans : il s’agit de simuler, d’articuler des tâches d’apprentissage, de perception/classification, de raisonnement, de décision et finalement d’action, tempère Sébastien Konieczny, chercheur au Centre de recherche en informatique de Lens.1 C’est essentiellement à l’essor récent des méthodes d’apprentissage et de classification associées au deep learningFermerLe deep learning ou apprentissage profond est une classe d’algorithmes d’apprentissage automatique utilisant plusieurs couches cachées de réseaux de neurones capables d’extraire/analyser/classer des caractéristiques de plus en plus abstraites des données qui leur sont présentées. que l’on doit la plupart des résultats actuels. Il y a eu une rupture technique, dont les résultats sont incontestables et spectaculaires. Mais les algorithmes sur lesquels ces progrès s’appuient – modélisation statistique, réseaux de neurones, apprentissage automatique, etc. – sont développés depuis une trentaine d’années. »

L’IA : des objectifs vieux de soixante ans

En effet, dès août 1955, à l’initiative de John McCarthy, un professeur de mathématiques spécialiste des machines de Turing, Claude Shannon, inventeur de la théorie de l’information, Marvin Minsky, futur cofondateur du laboratoire d’Intelligence artificielle du Massachusetts Institute of Technology (MIT), et Nathaniel Rochester, créateur de l’IBM 701 – le premier ordinateur commercial généraliste –, utilisaient pour la première fois les termes « intelligence artificielle » dans un appel à la communauté scientifique. Les principaux objectifs pratiques de l’IA étaient posés : robots autonomes, compréhension et traduction de l’écrit et de la parole, vision artificielle, aide à la décision et résolution de problèmes mathématiques.

Dans les premiers temps, partant du constat que l’ordinateur est avant tout un système de manipulation de symboles, les chercheurs tentent de modéliser et d’émuler l’intelligence à partir des notions de symbole et de représentation interne du monde. Mobilisant les progrès de la logique mathématique et de la linguistique, cette approche symboliqueFermerL’approche symbolique est une démarche de l’intelligence artificielle qui consiste à modéliser les tâches intellectuelles par la manipulation, par application de règles logiques, des symboles représentant des connaissances ou des processus cognitifs élémentaires. reste dominante dans l’intelligence artificielle jusqu’aux années 2000.

Elle aboutit notamment à la mise au point des premiers systèmes experts de diagnostic médical, des premiers joueurs électroniques – la victoire de Deep Blue sur le champion du monde d’échecs Gary Kasparov en est l’apothéose – ainsi qu’à quelques tentatives peu convaincantes de traitement automatique du langage naturel.

Des méthodes symboliques aux méthodes numériques

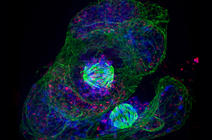

L’un des gros inconvénients des approches symboliques est qu’elles gèrent très mal les données bruitées : il ne faut pas d’erreur dans les données qu’on présente au système. En fait, ce problème de l’apprentissage a été abordé et en partie résolu par un autre courant de recherche de l’IA baptisé connexionnisme. Celui-ci prend pour modèle le cerveau biologique et tente de reproduire certaines de ses facultés, notamment visuelles, en simulant numériquement le comportement de réseaux de neuronesFermerUn réseau de neurones est un algorithme simulant numériquement le fonctionnement d’un réseau d’unités de calcul, les neurones formels, reliées entre elles par des connexions modifiables. Représentation simplifiée des neurones biologiques, ces neurones formels sont en fait des fonctions mathématiques qui, à partir des valeurs numériques reçues en entrée (connexions entrantes), calculent une valeur numérique de sortie (connexion sortante). formels ; en s’inspirant également de la structure en couches hiérarchiques des neurones du cortex visuel humain, ce qui aboutira aux algorithmes de deep learning. Dès les années 1970, on savait comment entraîner un réseau de neurones à reconnaître les objets d’une image grâce à l’algorithme de rétro-propagation d’erreur : une méthode numérique qui permettait d’améliorer le taux de bonnes reconnaissances du système en ajustant, à chaque erreur de classification, le poids des connexions entre chaque neurone du réseau.

Yann LeCun, aujourd’hui directeur du laboratoire d’intelligence artificielle de Facebook, l’avait démontré en développant dès 1989 un dispositif de reconnaissance des codes postaux manuscrits basé sur le deep learning : pour peu que l’on dispose d’un échantillon d’exemples suffisamment important à présenter à un réseau de neurones, celui-ci finit par égaler la performance d’un être humain, du moins en théorie…2

« On savait depuis les années 1980 que ces méthodes fonctionnaient, seulement elles réclamaient une puissance de calcul et une quantité de données considérables, qui sont restées longtemps hors de notre portée. Tout a changé au milieu des années 2000 : avec l’augmentation de la capacité des processeurs, il est devenu possible d’effectuer dans un temps raisonnable les calculs nécessités par les algorithmes de

deep learning, explique Jérôme Lang, directeur de recherche au Laboratoire d’analyse et modélisation des systèmes pour l’aide à la décision3 et médaille d’argent 2017 du CNRS. L’autre changement majeur, c’est Internet et l’accroissement exponentiel de la masse de données qu’il a rendue disponible. Par exemple, pour entraîner un système de reconnaissance visuelle, il faut lui présenter le plus grand nombre possible de photos annotées : tandis qu’il fallait se démener pour constituer des échantillons de quelques centaines de clichés indexés par des étudiants, on peut aujourd’hui assez facilement accéder à des centaines de millions de photographies annotées par les internautes via les “Captcha”. »

L’irrationnelle efficacité des données

Les résultats les plus spectaculaires de l’intelligence artificielle, ceux qu’aucun spécialiste n’osait espérer au début des années 2000, ont été obtenus dans les domaines de la reconnaissance visuelle – de la reconnaissance de visage à l’analyse de scènes –, de la reconnaissance vocale ou musicale, et dans celui du traitement automatique des langues – de la traduction à l’extraction automatique de sens. Or le point commun de ces systèmes, c’est que leur « intelligence », ou du moins leur performance, croît avec la taille du corpus à partir duquel ils ont été entraînés. Le problème posé par ces dispositifs est qu’une fois entraînés, ils fonctionnent comme une boîte noire : ils donnent de bons résultats mais, contrairement à ce que permettent les systèmes symboliques, ne donnent aucune indication sur le « raisonnement » qu’ils ont suivi pour y arriver. Un phénomène que trois chercheurs employés par Google ont appelé dès 2009 « l’irrationnelle efficacité des données ».

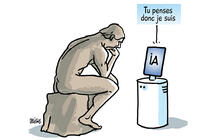

Cela explique l’avantage décisif qu’ont pris les Gafam dans ces domaines, ainsi que la frénésie qu’ont ces derniers à nous soutirer des données contre des promesses d’intelligence. Certains gourous technologiques extrapolent même l’émergence imminente d’une conscience artificielle, d’une intelligence superhumaine faite de machines qui inventeront et créeront d’elles-mêmes, pour nous… et éventuellement contre nous.

« Ces “prédictions” sont faites par des personnes éloignées de la recherche ou qui ont quelque chose à vendre, souligne Sébastien Konieczny. Les chercheurs en IA n’ont jamais prétendu recréer l’intelligence – dont il faudrait déjà qu’on donne une définition opérationnelle –, notre but est que des machines réalisent mieux que nous des tâches considérées comme intelligentes car nous seuls étions jusqu’alors capables de les réaliser, comme le classement de milliers de photos ou de morceaux de musique. Les seules choses que l’on maîtrise aujourd’hui, ce sont des tâches goal oriented ; une machine qui soit capable de définir ses buts, ça on ne sait pas faire. Alors la conscience… »

À lire aussi :

- Peut-on faire confiance à l'intelligence artificielle ?

- Demain, un ordinateur inspiré de notre cerveau ?

- Stéphane Mallat, bâtisseur de ponts mathématiques et informatiques