Vous êtes ici

L’art et l’archéologie, nouveaux horizons de l’IA

L’intelligence artificielle (IA) s’est imposée en quelques années comme un outil essentiel pour trier et gérer le flot d’images qui circulent en ligne. Nous sommes à présent habitués à ce que des algorithmes reconnaissent la présence de visages, ou fassent la différence entre un chien et un chat. La prochaine étape vise à dépasser ces descriptions très prosaïques. Maks Ovsjanikov, professeur au Laboratoire d’informatique de l’École polytechnique1 (LIX) spécialisé dans l’étude de données 3D et géométriques, entraîne ainsi ses algorithmes qui mettent à la disposition des archéologues et des historiens de l’art des solutions automatiques et reproductibles d’analyse des œuvres et artefacts.

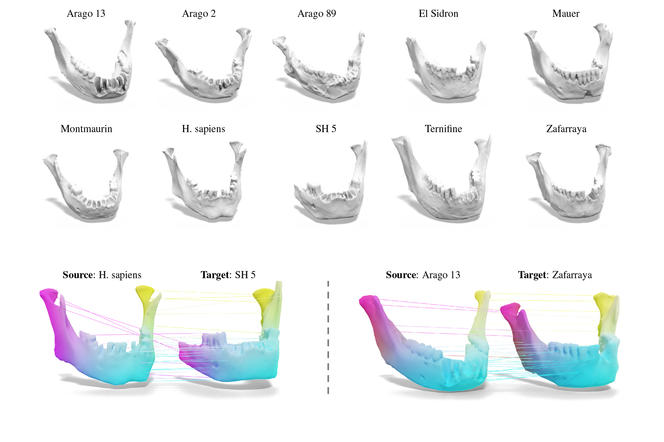

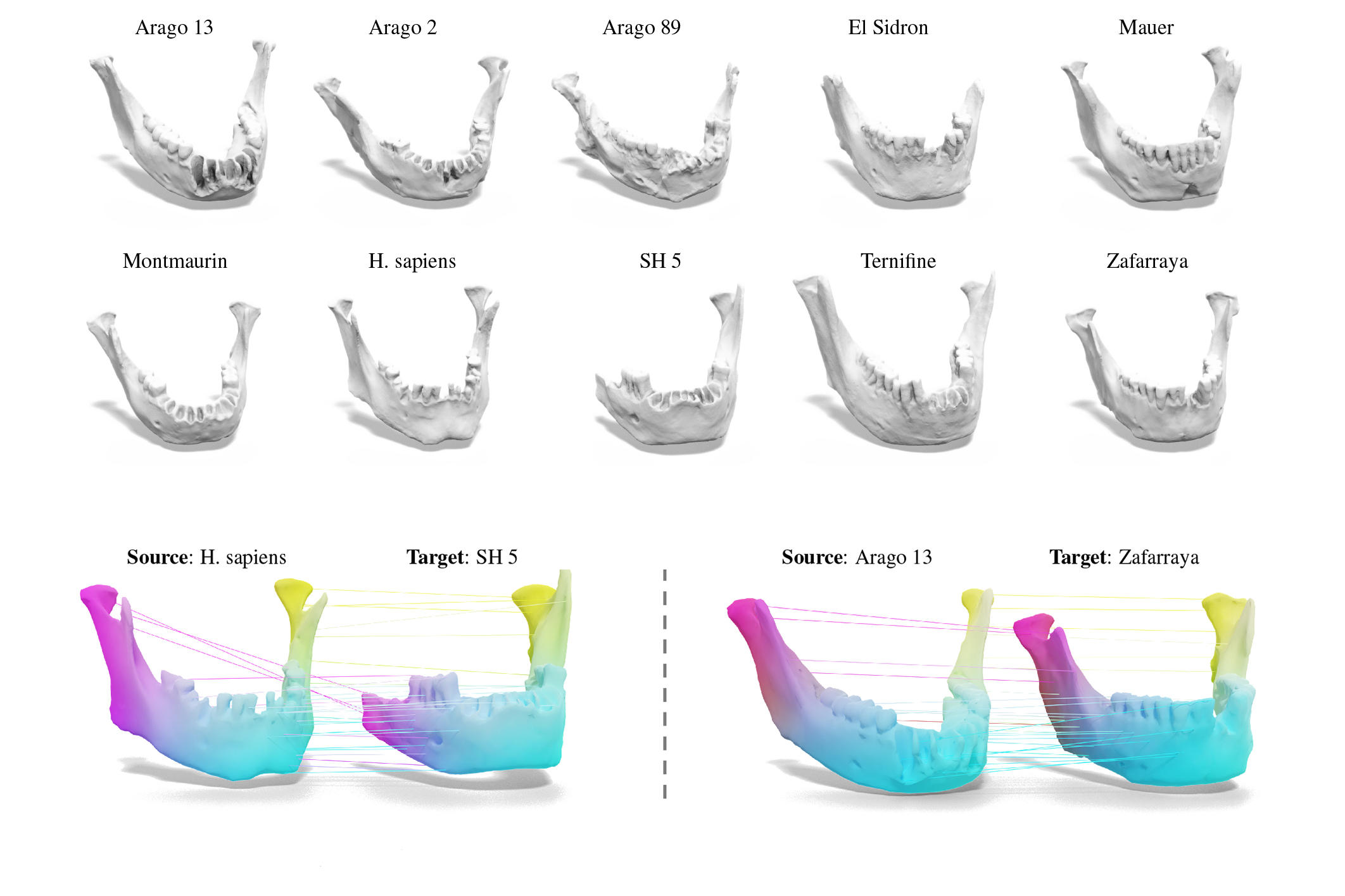

Classer des mandibules préhistoriques

« Concrètement, mon travail consiste à trouver des points communs et des différences entre des objets en trois dimensions, et à combler leurs éventuelles parties manquantes », explique Maks Ovsjanikov, médaille de bronze du CNRS en 2018. Le jeune chercheur a d’abord été sollicité par les équipes travaillant sur le site préhistorique majeur de la caune de l’Arago, où a été découvert l’Homme de Tautavel. Les scientifiques, dont les préhistoriens Henry et Marie-Antoinette de Lumley, étaient confrontés à des problèmes d’identification de dix mandibules humaines. Avec une occupation remontant jusqu’à il y a 600 000 ans, ces os sont trop anciens pour contenir de l’ADN et trop abîmés pour être clairement attribués à l’une des nombreuses espèces du genre Homo à s’être succédé dans et autour de la grotte.

Les chercheurs possédaient déjà de nombreuses données 3D sur les mandibules, que Maks Ovsjanikov et ses collaborateurs ont utilisées pour tenter de repérer, grâce à des algorithmes, des similitudes et des différences géométriques souvent difficiles à détecter et qui auraient pu échapper à l’œil expert de préhistoriens. Ils rendent l’analyse plus efficace et éliminent le biais que peut introduire l’annotation subjective, même par un expert. « Plutôt que d’effectuer à la main un travail laborieux de marquage des points d’intérêt sur des données 3D, je propose une méthode automatique et robuste basée sur l’apprentissage non supervisé, avance Maks Ovsjanikov. Cette approche “nettoie” en plus les artefacts géométriques qui apparaissent lorsque ces os passent au scanner. Le cas de Tautavel reste cependant très difficile, car il n’y a pas assez de mandibules pour établir des statistiques. Le travail n’est pas terminé, mais il marque déjà un grand pas dans la bonne direction. »

Un test de Turing émotionnel

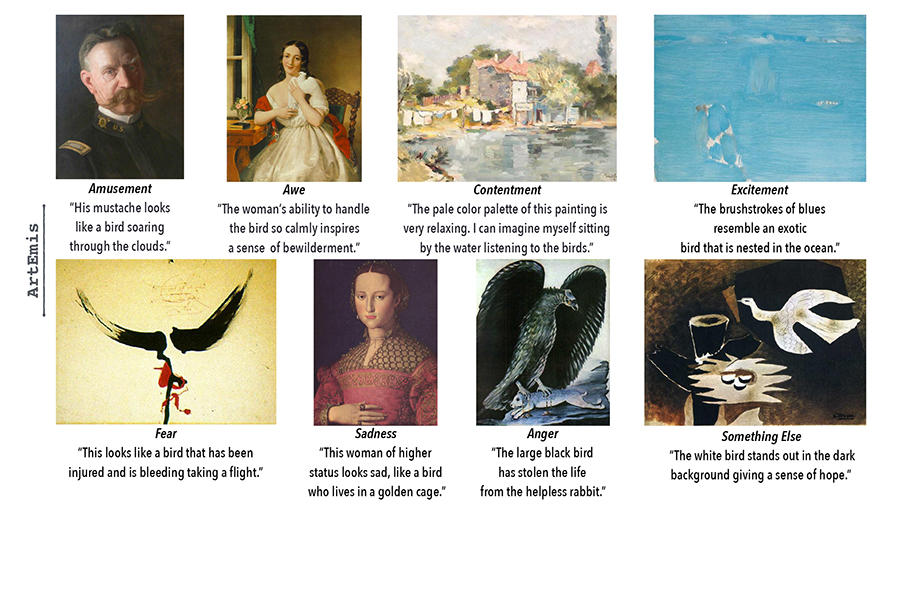

Maks Ovsjanikov s’intéresse également aux images en 2D. Il a ainsi fondé, avec des collègues de l’université de Stanford et de l’université des sciences et technologies du roi Abdallah (Kaust) en Arabie saoudite, le projet ArtEmis. Les algorithmes y apprennent à interpréter les émotions ressenties face à des œuvres d’art. « J’essaye de trouver et de quantifier ce qui rend un objet unique. C’est presque une question philosophique, s’amuse Maks Ovsjanikov. Les choses sont relativement simples avec une photographie dont on décrit le contenu, mais comment appréhender une œuvre d’art ? Et si elle est abstraite ? Il nous faut une analyse poussée sur la relation subjective entre les images et les spectateurs. »

Afin de disposer d’un jeu de données suffisamment large, les chercheurs ont demandé à un vaste panel de personnes, rémunérées via une plateforme de service de microtravail, de noter leur émotion dominante devant une œuvre et d’expliquer pourquoi ils l’ont ressentie.

Beaucoup de réponses étaient liées à l’impact personnel des images : « cela me rend triste/heureux » ; ou à un continuum de pensée : « il y a un oiseau, les oiseaux me font penser à la liberté, donc le tableau me fait penser à la liberté. » 455 000 réponses ont ainsi été obtenues pour 90 000 œuvres d’art. Ces données ont ensuite servi à entraîner les algorithmes, afin qu’ils commentent les œuvres comme l’auraient fait des humains. On leur a soumis ensuite de nouvelles images qui n’avaient pas été préalablement présentées aux participants du panel.

Ces réponses ont ensuite été intégrées à un sondage, que les chercheurs appellent un test de Turing émotionnel, où des sujets humains devaient déterminer si l’analyse provenait d’un algorithme ou d’un humain. La moitié du temps, les utilisateurs n’ont pas été capables de distinguer les énoncés des machines de ceux des humains.

Vers des robots esthètes ?

Ces résultats n’ont pas encore trouvé d’applications à court terme, même si les chercheurs imaginent des méthodes pour modifier des images afin de leur donner un impact émotionnel choisi. Les artistes contemporains travaillant avec des algorithmes pour générer, plus ou moins automatiquement, des œuvres pourraient également s’approprier ce genre de travaux.

« Le monde n’est pas que la liste des objets que nous voyons, il faut prendre en compte l’effet qu’ils ont sur nous, souligne Maks Ovsjanikov. Si nous voulons créer des robots et des algorithmes capables de communiquer comme un être humain, il faudra intégrer différentes formes de subjectivité. Or, pour l’instant, très peu de travaux existent sur ces questions complexes. »

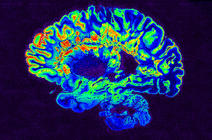

D’ici à ce que ces applications émergent, Maks Ovsjanikov et ses collaborateurs s’intéressent également au domaine biomédical. S’il n’est pas question de remplacer l’expertise et le pouvoir de décision d’un médecin, l’analyse des formes peut en effet servir d’aide au diagnostic, pour différencier des tissus organiques ou analyser une tumeur. « C’est très intéressant de trouver comment travailler en symbiose avec d’autres chercheurs, et développer des méthodes automatiques qui leur sont utiles, conclut Maks Ovsjanikov. La qualité et la quantité des données 3D issues de la recherche ne cessent d’augmenter, il faut parvenir à leur donner un sens. » ♦

- 1. Unité CNRS/École polytechnique.

Voir aussi

Auteur

Diplômé de l’École supérieure de journalisme de Lille, Martin Koppe a notamment travaillé pour les Dossiers d’archéologie, Science et Vie Junior et La Recherche, ainsi que pour le site Maxisciences.com. Il est également diplômé en histoire de l’art, en archéométrie et en épistémologie.