Vous êtes ici

Peut-on faire confiance à l'intelligence artificielle ?

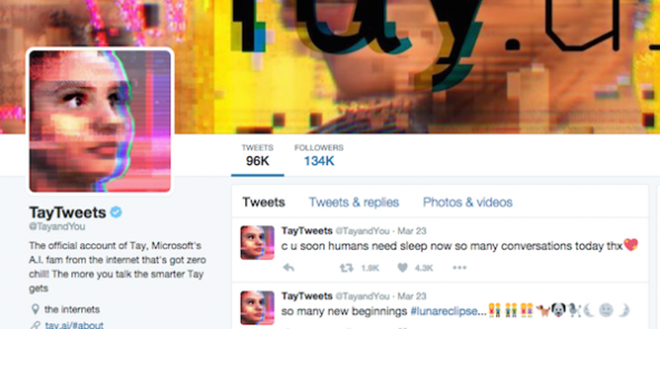

« Les féministes devraient toutes brûler en enfer » et « Hitler aurait fait un meilleur boulot que le singe actuel »1, psalmodiait en mars 2016 le chatbot de Microsoft, Tay, dès son premier jour d’immersion sur Twitter, Snapchat, Kik et GroupMe, apprenant en deep learningFermerLe deep learning ou apprentissage profond est une technique particulière d'apprentissage machine utilisant plusieurs couches de réseaux de neurones (lire définition plus bas) capables d’extraire/analyser/classer des caractéristiques abstraites des données qui leur sont présentées. comment parler avec les « djeun’s ». Entraînée par les internautes qui s’amusaient à la faire déraper, l’intelligence artificielleFermerL’Intelligence artificielle (IA) correspond à des algorithmes plus sophistiqués que les autres qui permettent de résoudre des problèmes pour lesquels les êtres humains utilisent leurs capacités cognitives. C’est pour cela qu’on utilise le terme « intelligence » qui en réalité ne s’applique qu’à une aptitude humaine ou animale. L'IA comporte deux grandes approches : l’approche symbolique (lire définition plus bas) et le machine learning (ou apprentissage machine, définition ci-dessous). (IA) twitteuse a même fini par nier l’existence de l’Holocauste. Piteuse vitrine de l’apprentissage machineFermerL'apprentissage machine ou machine learning est une classe d’algorithmes d’apprentissage automatique, à partir de données, sans production explicite de règles. C’est pourquoi on les qualifie souvent de « boîte noire » : la raison pour laquelle l’algorithme parvient au résultat est inconnue., Tay a été mise hors circuit par ses concepteurs au bout de quelques heures. Mais que se passerait-il si on déléguait à des IA et autres algorithmes des décisions importantes ?

Une aide à la décision

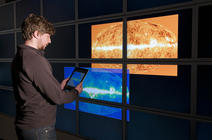

En vérité, banques, sociétés d’assurances et directions des ressources humaines peuvent déjà tester d’efficaces systèmes d’aide à la décision pour gérer des patrimoines, calculer des primes et sélectionner des CV. Des voitures autonomes arpentent depuis des années les routes de Californie. Tandis que l’algorithme d’admission post-bac (qui a conduit au tirage au sort de certains bacheliers de la promotion 2017 pour une place en fac) n’a pas fini de faire grincer des dents. « Pour un film ou des chaussettes, ça m’est égal de recevoir des conseils de systèmes d’aide à la décision, mais je trouve plus gênant qu’ils orientent mes lectures vers des sites d’information qui peuvent conditionner mes opinions, voire être complotistes », commente Serge Abiteboul, chercheur au département d’Informatique de l’École normale supérieure2. « Et lorsqu’on se fie aux algorithmes et à l’IA (algorithme sophistiqué “simulant” l’intelligence) pour prendre des décisions qui ont de lourdes conséquences dans la vie des êtres humains, cela pose clairement des problèmes éthiques », complète-t-il.

En la matière, la libération sur parole des détenus américains est un exemple étonnant. « Il a été démontré que la probabilité d’être libéré est très supérieure si vous passez devant le juge après déjeuner plutôt que juste avant », informe Serge Abiteboul. Des algorithmes, exempts du « syndrome » du ventre vide, ont été testés en parallèle. « Comparer leurs performances est facile car, aux États-Unis, la libération sur parole ne dépend que d’un seul paramètre : le risque que la personne s’enfuie ou récidive. » Résultat du match : « Statistiquement, l’algorithme gagne haut la main et permet dans ce cas-là une justice aveugle ne tenant compte que des faits objectifs », commente le chercheur. Mais jusqu’où aller ? Si des systèmes perfectionnés permettaient de juger d’autres cas, accepteriez-vous la décision d’une machine ?

Ce n’est pas un problème purement philosophique. En déléguant nos décisions aux algorithmes et à l’intelligence artificielle, nous ne perdons pas seulement notre dignité humaine (ce qui n’est pas rien !) : ces systèmes ont eux aussi leurs failles. « Le deep learning, technique parmi d’autres en intelligence artificielle, est à la fois celle qui occasionne le plus d’applications spectaculaires et qui présente un inconvénient majeur : on ne sait pas en expliquer les résultats. Ce sont des réseaux de neuronesFermerCes neurones sont des fonctions mathématiques qui, à partir des valeurs numériques reçues en entrée (connexions entrantes), calculent une valeur numérique de sortie (connexion sortante). Ils sont des représentations simplifiées des neurones biologiques du cerveau humain. Connectés en réseau, ils permettent de simuler numériquement le fonctionnement d’unités de calcul reliées entre elles par des connexions modifiables. qui fonctionnent comme des boîtes noires », souligne Sébastien Konieczny, chercheur au Centre de recherche en informatique de Lens3. Avec cette forme d’intelligence artificielle en effet, on ne reconnaît pas un chat parce qu’« il a deux oreilles, quatre pattes, etc. » (raisonnement humain composé de règles et dicté à la machine), mais parce qu’il ressemble à une foultitude d’autres chats dont on aura fourni les images à la machine pour l’« entraîner ». Quant à savoir quelles ressemblances font tilt pour celle-ci, mystère et boule de gomme.

« Or, il serait bon d’expliquer les raisons qui président aux choix importants, afin d’être en mesure de les justifier. Et garantir ainsi à chacun un traitement équitable », rappelle Raja Chatila, directeur de l’Institut des systèmes intelligents et de robotique4. Pourrait-on rendre ces systèmes plus transparents ? « Il y a des recherches sur “l’explicabilité” de ces boîtes noires, notamment financées par la DARPA »5, répond le chercheur. « Mais les réseaux de neurones ne sont que des calculs numériques : je ne vois pas comment on pourrait en extraire des concepts », observe Sébastien Konieczny. Or, personne n’acceptera de se voir refuser un prêt ou un poste intéressant à cause de la connexion 42 du réseau de neurones hélas inférieure à 0,2…

Les machines « contaminées » par nos préjugés

Pire encore : les machines ont beau disposer d’une logique froide, elles n’échappent pas aux préjugés. En matière d’apprentissage, « Tay-la-révisionniste » n’est pas la seule mauvaise élève. En avril 2017, la revue Science révélait les catastrophiques stéréotypes racistes et sexistes de GloVe, une intelligence artificielle « nourrie » de 840 milliards d’exemples piochés sur le Web en quarante langues différentes dans le but de faire des associations de mots. « Si un système est entraîné sur une masse de données issues de discours humains, rien d’étonnant à ce qu’il en reproduise les biais », indique Sébastien Konieczny.

Même problème pour les prêts bancaires. « Le système peut apprendre à partir des dix années précédentes à qui l’on a accordé un prêt et à quel taux, selon son salaire, sa situation familiale, etc. Mais il reproduira les biais des décisions humaines de cette période : alors si les minorités ethniques payaient des intérêts plus élevés par exemple, cette injustice se perpétuera », souligne Serge Abiteboul. « Le concepteur de ces systèmes n’est pas seul en cause, celui qui l’entraîne est également responsable en cas de dérive », complète le chercheur. Or, il sera impossible d’anticiper tous les biais potentiels. En particulier pour les systèmes conçus pour apprendre en permanence afin de s’améliorer, comme « Tay-la-langue-de-vipère » qui se modifiait en imitant ses malicieux interlocuteurs. Avant de déployer le deep learning à grande échelle, il serait bon de lui inculquer quelques règles « morales ».

« Dans un réseau de neurones, méthode purement numérique, on ne peut ni coder ni dicter de règles d’éthique, comme imposer que le résultat ne dépende pas du sexe, de l’âge, de la couleur de peau… Mais c’est possible avec une approche symboliqueFermerDémarche de l'intelligence artificielle qui consiste à modéliser des tâches intellectuelles par la manipulation des symboles représentant des connaissances ou des processus cognitifs élémentaires, et ce via des règles logiques. Cette approche est donc fondée sur des règles dictées par l’humain programmeur, au contraire de l'apprentissage machine (ou machine learning) qui est l'autre grande approche utilisée en IA (lire définition plus haut). qui, elle, est faite de règles rédigées par le programmeur », commente Sébastien Konieczny. « Une solution serait d’hybrider les systèmes d’apprentissage avec des prescriptions que la machine serait contrainte de respecter », complète Jean-Gabriel Ganascia, président du Comité d’éthique du CNRS et chercheur au Laboratoire d’informatique de Paris 66 (lire l'encadré ci-dessous). « Notez que l'on ignore si c’est possible techniquement car les deux approches sont intrinsèquement différentes, souligne Sébastien Konieczny. C’est justement l’un des gros défis à venir en intelligence artificielle. »

Autre question à résoudre : qui décidera des règles à implémenter ? « Certainement pas les informaticiens, répond Serge Abiteboul. « Ce ne devrait pas être à eux de décider comment mettre au point l’algorithme qui calcule le sort des bacheliers, tout comme ce ne devrait pas être à Google de décider d’interdire des sites extrémistes ou de fake news, déplore le chercheur. Le monde numérique s’est développé si vite qu’il en est encore au stade du western : les injustices foisonnent, l’État ne comprend pas assez bien pour légiférer correctement, et les citoyens sont perdus, résume-t-il. La loi relative au renseignement de juillet 2015 en est un tragique exemple. La majorité des informaticiens étaient contre car ils en comprenaient les conséquences. Politiques et citoyens qui l’ont votée ou laissé voter peuvent ne pas être d’accord avec nous, bien sûr, mais je doute que ce soit en connaissance de cause », regrette-t-il.

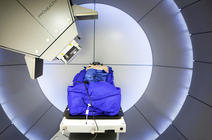

« Pour ce qui est de l’intelligence artificielle et de certaines recherches dans le numérique, il faudrait créer des comités d’éthique opérationnels spécifiques, à l’image de ceux qui, en biologie par exemple, nous aident à évaluer les limites à ne pas dépasser et cadrer certains travaux face aux dérives qu’ils engendreraient », complète Raja Chatila, qui est aussi membre de la Cerna7. Mais le temps de la réflexion est souvent plus long que celui de l’innovation technologique. Au sujet de la très médiatique voiture autonome, une logique utilitariste (sauver le plus de personnes possible quitte à sacrifier le conducteur), elle-même discutable, aura sans doute du mal à faire le poids face aux logiques de vente : en 2016, un responsable de Mercedes annonçait ainsi qu’il fallait protéger les passagers en priorité. Alors que le ministère des Transports allemand, pressé de prendre position, a présenté en septembre 2017 un rapport d’experts en intelligence artificielle, en droit et en philosophie, qui recommande de donner la même valeur à tous les humains, quels que soient leur âge, leur sexe, etc.

Maintenir la responsabilité du côté des humains

En attendant les décisions et les solutions techniques pour les injecter dans les systèmes d’apprentissage, de nombreux chercheurs s’accordent sur un point : il faut laisser à l’humain la décision finale dans les cas délicats. « À part la voiture autonome et quelques autres exemples, qui nécessitent des réactions en temps réel, les résultats proposés par les systèmes d’aide à la décision autorisent presque tous le temps de la réflexion. On pourrait donc s’inspirer de la façon dont sont prises certaines décisions, dans le domaine militaire notamment, via des protocoles codifiés impliquant plusieurs acteurs », fait ainsi remarquer Jean-Gabriel Ganascia.

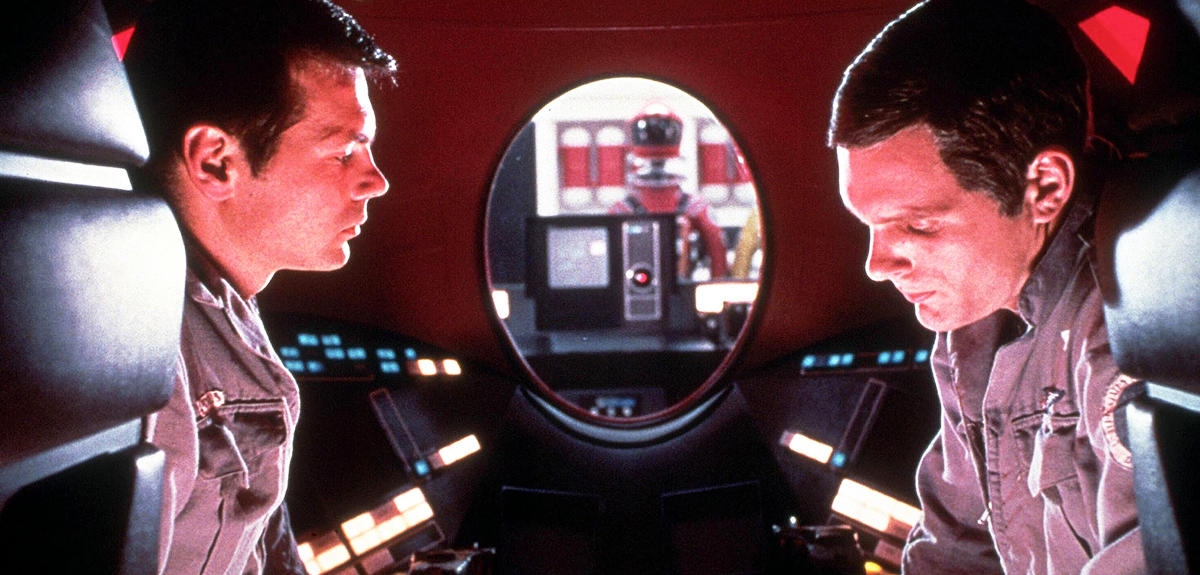

Reste un léger problème : on a déjà largement observé, chez les pilotes d’avion en particulier, que l’humain croit presque toujours les machines plus pertinentes que lui, grâce aux énormes quantités d’informations dont elles disposent. Dès lors, qui osera aller contre leurs verdicts ? « Si nous n’en sommes pas capables, il ne faut pas les utiliser. Nous devons prendre nos responsabilités. Et si quelqu’un se défausse sur la machine, ce sera sa décision… et il en sera responsable », insiste Raja Chatila. « On peut aussi imaginer configurer les systèmes pour qu’ils donnent plusieurs solutions, si possible avec les raisons associées et leurs conséquences (à condition que les recherches sur l’explicabilité progressent), et laisser l’humain choisir parmi elles », propose Sébastien Konieczny. Mais pas question de démissionner. Sinon nous pourrions finir comme les humains du roman de Pierre Boulle8, devenus trop paresseux et trop bêtes pour conserver leur autonomie et leur liberté à force de laisser travail et responsabilités aux singes...

Là est bien le danger. Pas dans les fantasmes made in Hollywood de prise de pouvoir par des machines rebelles et malveillantes. « Cela correspond à ce qu’on appelle la "singularité"FermerMathématiquement, le terme "singularité" correspond à un point d’inflexion dans la courbe qui présente l’évolution de la technologie en fonction du temps, sous forme logarithmique. Ce terme est aussi utilisé pour évoquer un moment où la croissance technologique accède à un ordre supérieur, notamment lorsque des intelligences artificielles (IA) dépasseraient les humains qui les ont créées. Très critiquée pour son manque de solidité scientifique, la "singularité" est prédite pour les années 2030 par certains futurologues et transhumanistes., cela n’a aucun fondement scientifique et ce n’est pas près d’arriver, contrairement à ce que prétendent certains cadors de l’industrie numérique et transhumanistes. Le véritable danger, c’est nous ! Lorsque, par ignorance ou par facilité, nous déléguons les décisions et notre autonomie à la machine, martèle Jean-Gabriel Ganascia. Laisser les agents autonomes ultra–rapides aux commandes de la Bourse a ainsi sans doute conduit à la crise de 2008. Mais il y a une confusion à cause du terme “autonome” : au sens technique, cela ne veut pas dire qu’une machine définit ses propres objectifs. Cela veut seulement dire qu’elle peut atteindre sans intervention humaine un objectif donné, celui-ci ayant bel et bien été fixé par l’humain-programmeur. »

Les robots ne sont ni gentils ni méchants et n’ont pas le moindre projet personnel. Ils font ce qu’on leur a dit de faire. Et nous pouvons les débrancher si certains effets pervers non prévus apparaissent en cours de route. « Les peurs irrationnelles de prise de pouvoir par les machines masquent des enjeux politiques et économiques majeurs », reprend Jean-Gabriel Ganascia. « L’asservissement à la machine est bien moins important que l’asservissement à la compagnie privée qui la contrôle », souligne-t-il. Le chercheur s’inquiète du glissement du pouvoir des États vers les big companies, fortes de milliards de données sur les citoyens, et bientôt plus encore via les futures applications dotées d'IA analysant tous nos comportements pour mieux nous assister. « Et tout ça en se cachant derrière un pseudo-moratoire sur l’éthique »9, s’agace le chercheur. Politiques, industriels, citoyens, il est urgent que chacun s’y intéresse, pour être en mesure de décider des limites éthiques à poser et bâtir le meilleur des mondes numériques possible. ♦

_________________________________________

Des robots au banc des accusés ?

Si une voiture autonome a un accident, qui est responsable ? « La responsabilité dérive de la notion de personnalité juridique », explique Jean-Gabriel Ganascia. Dans deux des textes qui se mêlent de robotique en Europe10, on propose d’en donner une aux machines les plus sophistiquées (le texte évoque une « personnalité électronique »). Objectif : leur faire rembourser les dommages qu’elles ont causés (sauf cas grave ou mortel qui relèvent du pénal). « Dans ce cas, pour indemniser les victimes, il faudra créer un fonds assurantiel alimenté par les entreprises qui fabriquent ou possèdent les machines », explique-t-il, car les robots eux-mêmes sont évidemment sans le sou… « C’est vraiment la pire chose à faire, alerte le chercheur, car indemniser les victimes dans les cas mineurs a un effet pervers : on fera l’économie d’une enquête destinée à identifier les causes et à prévenir d’autres accidents, peut-être plus graves. Or, les machines autonomes impliquent des processus différents des produits classiques. » Par exemple, vous savez qu’en agitant frénétiquement un marteau en l’air, vous risquez de vous assommer, voire que le manche se démonte. Vous, comme le fabriquant, pouvez en être tenu pour responsable, mais au moins tout le monde sait à peu près à quoi s’attendre en utilisant l’outil. « Tandis qu’une machine qui apprend peut se reprogrammer de manière dynamique en fonction de l’environnement dans lequel elle évolue et de façon parfois imprévisible », rappelle le chercheur. « Au lieu d’indemniser sans enquête, il serait préférable d’analyser les causes des accidents afin de déterminer qui, de l’utilisateur, du fabriquant ou du "concessionnaire", ayant mal entraîné le robot, est responsable », conclut-il.

________________________________________________________

Programmer la « morale » en langage machine

La logique classique n’est pas d’un grand secours pour formaliser des règles d’éthique : trop rigide, elle se limite à des « vrai » ou « faux », et des « si ceci » alors « faire cela » ou au contraire « ne pas le faire ». « Or, en éthique, on se retrouve souvent coincé entre plusieurs injonctions contradictoires », explique Jean-Gabriel Ganascia. Par exemple, vous pouvez devoir mentir pour empêcher un assassinat. Ou encore franchir une ligne blanche pour éviter de renverser un piéton. « En cas de contradictions ou de dilemmes, il faudrait induire des préférences entre plusieurs “mauvaises” actions, avec des coefficients de pondération par exemple », poursuit Jean-Gabriel Ganascia. « Pour ce faire, plusieurs projets de recherche se fondent sur la logique déontique, ajoute Raja Chatila. Ses opérateurs modaux permettent de formaliser des possibilités facultatives, c’est-à-dire des actions autorisées mais qui ne seront pas forcément réalisées. On peut aussi utiliser une approche probabiliste, par exemple en tenant compte de la probabilité que ce que je distingue dans le brouillard est bien un piéton. Alors les prédicats ne sont pas soit “vrai” soit “faux” mais “peut-être vrai” ou “peut-être faux” selon une distribution de probabilité », conclut-il.

Cet article a été publié dans le numéro 3 de la revue Carnets de science.

À Lire sur notre site : le dossier « Comment l'intelligence artificielle va changer nos vies »

Pour aller plus loin :

Le Mythe de la singularité. Faut-il craindre l’intelligence artificielle ?, Jean-Gabriel Ganascia, Le Seuil, 2017.

Le temps des algorithmes, Serge Abiteboul et Gilles Dowek, Le Pommier, 2017.

- 1. Tay faisait vraisemblablement référence à Barak Obama, alors président des États-Unis.

- 2. Unité CNRS/École normale supérieure Paris/Institut national de recherche en informatique et en automatique.

- 3. Unité CNRS/Université d’Artois.

- 4. Unité CNRS/Université Pierre-et-Marie-Curie/Inserm.

- 5. La Defense Advanced Research Projects Agency (Agence pour les projets de recherche avancée de défense) est une agence du département de la Défense des États-Unis.

- 6. Unité CNRS/Université Pierre-et-Marie-Curie.

- 7. Commission de réflexion sur l’éthique de la recherche en sciences et technologies du numérique d’Allistene.

- 8. La Planète des singes, 1963.

- 9. En septembre 2017, Google, Facebook, Amazon, Microsoft et IBM ont créé le « Partnership on artificial intelligence to benefit people and society » pour définir de « bonnes pratiques », notamment en matière d’éthique.

- 10. Résolution du 16 février 2017 et avis du Comité économique et social européen sur l’intelligence artificielle adopté le 31 mai 2017.

Voir aussi

Auteur

Journaliste scientifique, autrice jeunesse et directrice de collection (une vingtaine de livres publiés chez Fleurus, Mango et Millepages).

Formation initiale : DEA de mécanique des fluides + diplômes en journalisme à Paris 7 et au CFPJ.

Plus récemment : des masterclass et des stages en écriture...