Vous êtes ici

Rendre les robots plus saisissants

À quoi peut bien servir un robot qui parle comme un livre ou qui visse plus vite que son ombre s’il n’est pas assez adroit pour nous tendre un parapluie sans nous assommer ou nous servir un verre sans broyer ni laisser glisser la bouteille ? Bien qu’on sache désormais fabriquer des robots plus forts, plus rapides et paraissant aussi intelligents que nous, leur sens du contact et leur dextérité laissent, en effet, encore à désirer. Et pour cause : « Les techniques robotiques ont généralement été utilisées pour construire des machines spécialisées : machines de nettoyage, manipulateurs, robots de soudage. Les vrais problèmes d’interaction avec une machine autonome ont rarement été abordés, rappelle Daniel Sidobre du Laboratoire d’analyse et d’architecture des systèmes du CNRS (Laas). Il est toujours plus simple d’installer une porte automatique que de programmer un robot pour ouvrir une porte standard. » Mais, quand il s’est agi de conférer à leurs créatures tact et doigté, les roboticiens se sont vite rendus à l’évidence : rien n’égale les qualités de la main humaine, en particulier le toucher.

Faire sortir les robots de leur cage

Tout a commencé lorsque l’idée de faire descendre les robots des chaînes de montage pour les faire interagir avec des êtres humains a cessé d’être un sujet de science-fiction pour devenir un vrai défi technique. Une fois réglé le délicat mais incontournable problème d’évitement des collisions entre la machine et l’homme, les chercheurs ont pu passer à la première étape d’une réelle interaction humain-robot : l’échange manuel d’objets. Et là, ils se sont aperçus que, même équipés de capteurs visuels performants et dotés d’une planification très précise de leurs mouvements, les robots ne parvenaient pas à correctement effectuer cette tâche pourtant élémentaire. « Dans le cadre de démonstrations pour le projet européen Cogniron(link is external), nous avions proposé à des personnes non préparées de saisir un objet tendu par un robot : dans environ 20 % des essais, l’échange échouait, explique Daniel Sidobre. Les informations transmises semblaient différentes de celles échangées par deux humains se passant un objet, ce qui nous a incités à étudier ces interactions. »

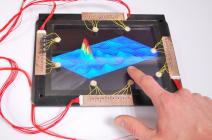

Pour le projet européen Dexmart(link is external), l’équipe du Laas a donc conçu un dispositif électronique capable de capturer les efforts d’interaction transmis lors d’une passation d’objet entre deux êtres humains. Baptisé « le Bidule », ce bâton-relais intelligent enregistre simultanément les accélérations successives et les forces de contact qui s’exercent sur lui lorsqu’il passe de main en main. L’objet pouvait ainsi être considéré comme une sorte d’organe du toucher délocalisé. Grâce aux données collectées, on a pu comprendre l’enchaînement des mouvements qui caractérisent l’échange manuel d’objet. « La détection de la saisie repose sur la détection d’une variation de force, car, lorsque l’homme saisit l’objet, il transmet au robot un effort, précise Daniel Sidobre. L’instant de déclenchement de l’ouverture de la pince doit donc correspondre à l’instant où l’humain serre l’objet. » Implémentée sur le robot Jido(link is external), cette modélisation a permis de rendre les passations d’objets plus naturelles et plus fiables.

Du toucher de bâton à la prestidigitation

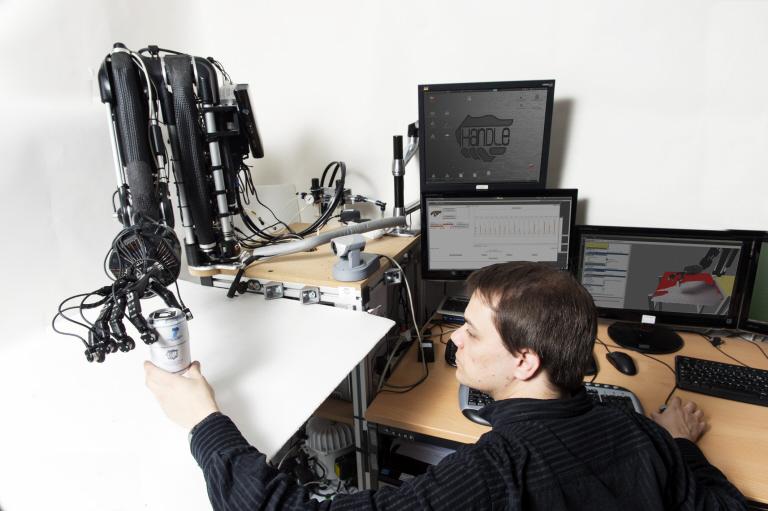

Les travaux menés au sein du Laas avaient pour but d’améliorer l’aptitude des machines à se saisir d’objets. Mais, pour nous être sympathiques, les futurs robots de compagnie devront faire bien mieux que de nous tendre gentiment des bâtons. Or, pour effectuer les tâches les plus triviales, ne serait-ce que prendre un verre et transvaser son contenu dans un autre verre, nous exploitons sans nous en rendre compte la capacité qu’a notre main d’effectuer des manipulations fines. C’est ce constat qui a justifié le lancement du projet européen Handle(link is external), dont l’objectif était, cette fois, de concevoir une main artificielle capable de prouesses similaires à celles d’une main humaine.

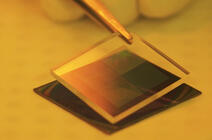

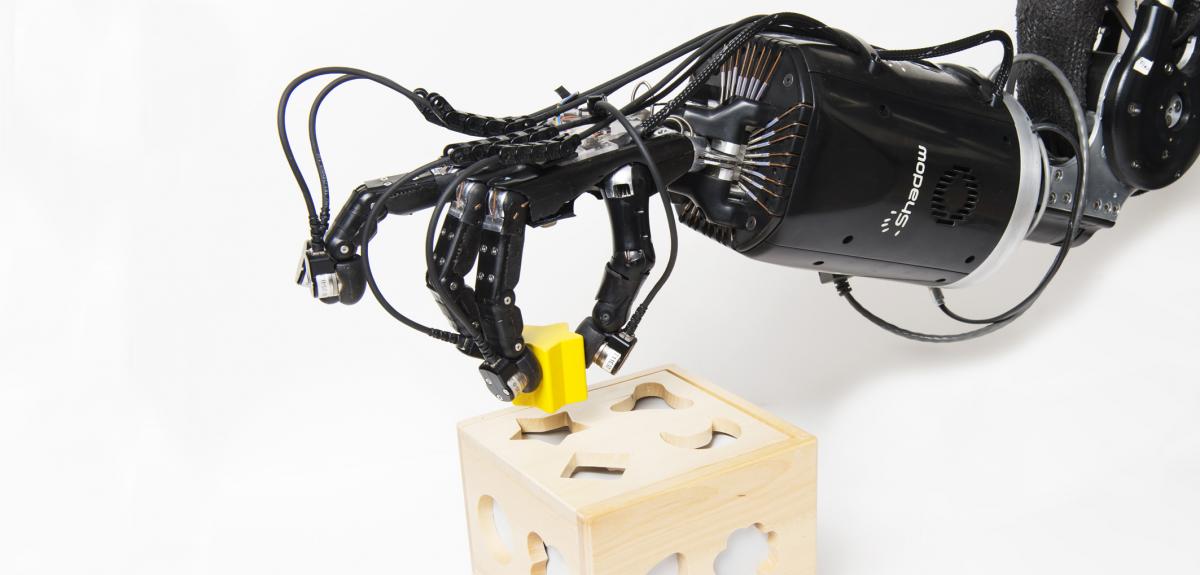

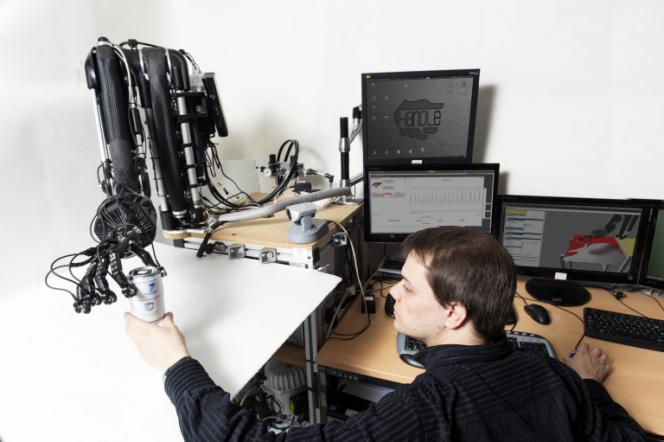

« Nous avons utilisé une main robotique à cinq doigts fabriquée par la société anglaise Shadow, dont les articulations répliquaient, à quelques simplifications près, celles de la main humaine, décrit Véronique Perdereau, coordinatrice du projet Handle et professeur de robotique à l’Institut des systèmes intelligents et de robotique (Isir)1. En plus d’une caméra, nous avons ajouté, à l’extrémité des doigts, des capteurs supplémentaires mesurant les forces de pression exercées dans six directions : la main pouvait ainsi connaître à tout moment la localisation des points de contact et la force qui s’y exerçait, cela afin de lui permettre d’effectuer des manipulations fines. » Par manipulations fines, on désigne les mouvements indépendants des doigts qui permettent le déplacement d’objet à l’intérieur de la main : comme quand on se saisit d’un stylo en le pinçant entre le pouce et l’index, qu’on le fait ensuite glisser le long des doigts, puis basculer entre l’index et le majeur pour le placer en position d’écriture. « Bien que très courantes, ces manipulations sont excessivement difficiles à reproduire en robotique, contrairement à une simple pince qui va juste se fermer puis se rouvrir pour amener l’objet d’un endroit à un autre », commente la chercheuse.

33 configurations pour une main

Les premières recherches menées pour le projet Handle ont ainsi consisté à enregistrer et analyser les postures et les mouvements naturels de la main humaine lors de la saisie et de la manipulation de divers objets. « Nous avons découvert que toute action de la main peut être décomposée en un enchaînement ordonné de 33 configurations canoniques, comme on décompose un film image par image », indique Véronique Perdereau À l’issue de ce travail exploratoire, il a été possible d’associer des classes de manipulation sur certains types d’objet à des enchaînements précis qui ont été intégrées dans une base de données exploitable par le robot. Ainsi, lorsque la main « voit » un objet à l’aide de la caméra, une fois identifiée sa forme externe, elle sélectionne dans sa base de données une méthode de saisie pertinente consistant en une séquence préplanifiée de configurations. Les mouvements de la main sont ensuite ajustés au fur à mesure de l’action en fonction des informations reçues par les capteurs visuels et tactiles. « Lorsqu’on saisit un objet, on a besoin d’ajuster en permanence la force qui lui est appliquée, prévient Véronique Perdereau. Si on n’a aucun autre retour d’information que la position, on ne peut rien tenir. » Chacun peut d’ailleurs évaluer l’importance du toucher lorsqu’il tente de lacer ses chaussures avec des gants : la perception tactile est suffisamment dégradée pour rendre la tâche bien plus ardue. Les capteurs sensoriels qui tapissent le bout de nos doigts et de nos phalanges nous permettent de savoir à chaque instant, sans même en prendre conscience, ou placer nos doigts et quelle force appliquer pour serrer, lâcher ou faire passer un objet de doigt en doigt.

La main robotique ainsi rendue aussi agile qu’intelligente se révèle aujourd’hui capable de saisir une canette de soda et de la basculer doucement pour en verser le contenu, ou bien d’attraper une ampoule sans la casser et la visser sur un culot. Reste à greffer cette main sur un robot autonome, ce qui pourrait encore demander un certain temps, car la puissance de calcul nécessaire à la planification des manipulations est gigantesque et doit être assurée par de gros ordinateurs que l’on ne peut pas encore intégrer au robot. « Bien que ces travaux relèvent encore de la recherche fondamentale, nous avons l’objectif d’une application dans l’assistance aux tétraplégiques ou aux personnes âgées, par exemple pour attraper des objets tombés par terre, affirme la roboticienne. Il existe, en effet, une demande spécifique dans cette population qui a besoin d’une aide mais qui ne souhaite pas forcément une présence humaine permanente à ses côtés. »

La peau comme filtre amplificateur

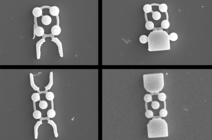

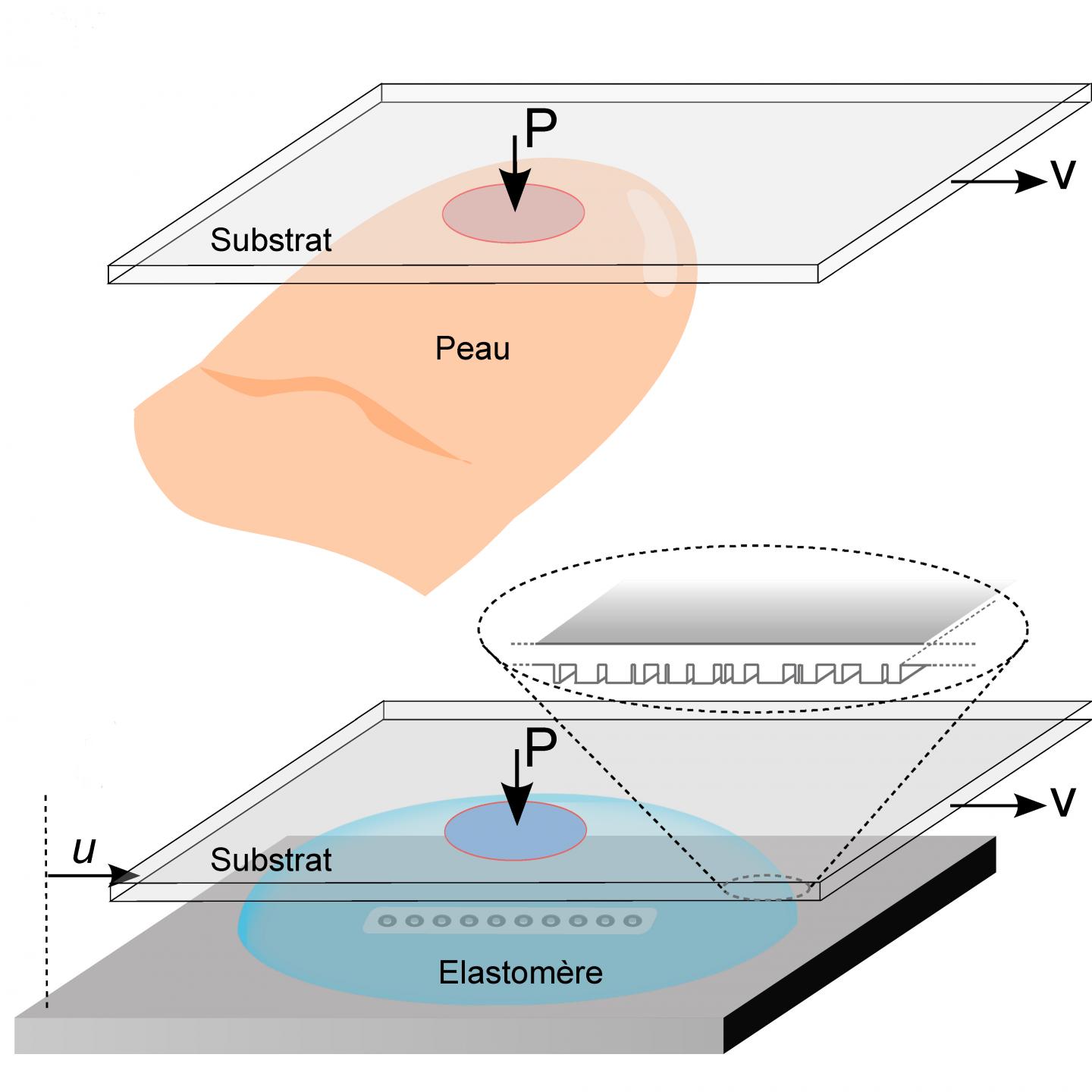

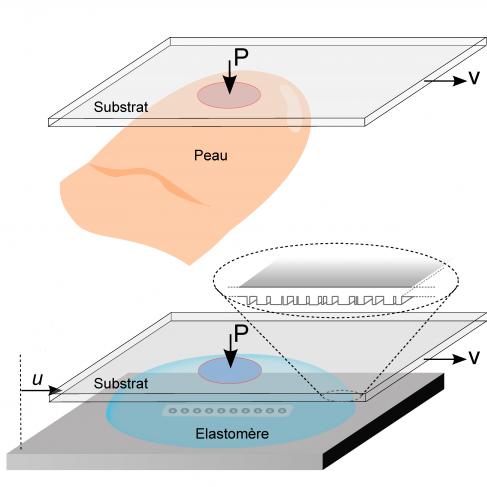

Mais le sens du toucher sert bien plus qu’à simplement mesurer et localiser les forces de pression exercées au contact d’un objet. Il nous informe aussi sur la texture de surface des objets touchés. Et ce avec une précision qui va bien au-delà de la capacité individuelle des capteurs naturels de la peau. « Afin de comprendre la nature et l’importance de ce phénomène, nous avons utilisé une approche biomimétique qui consistait à modéliser le fonctionnement de l’extrémité d’un doigt », précise Alexis Prevost, biophysicien au Laboratoire Jean-Perrin2. Avec son équipe, il a donc recréé un doigt tactile artificiel en plaçant, sous une calotte en élastomère imitant les caractéristiques mécaniques de la peau, des microcapteurs de force simulant les mécanorécepteurs sous-cutanés. Il a ensuite enregistré les réponses de ces capteurs quand le dispositif parcourait, en l’effleurant, une sorte de code-barres en relief. « Nous avons pu constater qu’en transmettant les vibrations produites par le frottement contre la surface avant même qu’ait lieu le moindre traitement neuronal, la peau agissait comme un filtre mécanique effectuant un premier traitement de l’information tactile », poursuit Alexis Prevost.

Mieux, en fabriquant un second dispositif où la peau artificielle était cette fois recouverte d’un réseau régulier de microsillons simulant les empreintes digitales, les chercheurs ont constaté une amplification notable des réponses des capteurs. Tout se passe comme si les empreintes faisaient résonner les stimuli tactiles, permettant ainsi de discriminer des défauts de surface qui ne seraient pas perceptibles par une peau lisse. « Nos résultats indiquent que la connaissance des propriétés intrinsèques des capteurs couplée à la simple mesure de leurs réponses ne suffit pas pour cerner la texture fine d’un objet, souligne le biophysicien. Il est également capital de connaître les conditions d’exploration tactiles – vitesse de frottement, pression appliquée, position du capteur, coefficient de frottement, etc. ». Bref, pour rendre les robots vraiment touchants, il convient d’abord d’appréhender les bases biologiques du toucher.

La robotique pour valider la neurobiologie

« On sait depuis longtemps que, pour explorer la surface des objets, notre main adopte habituellement des comportements stéréotypés, décrits sous le nom de procédures exploratoires, dont les caractéristiques dépendent du type d’information collecté », note Alexis Prevost. Il est vrai qu’on n’effleure pas de la même manière une étoffe dont on veut connaître la texture et une pièce de un euro qu’on cherche à retrouver, au milieu de dizaines d’autres, au fond de sa poche. Car le toucher est un sens interactif : à la différence de la vue ou de l’ouïe, pour lesquels le stimulus extérieur est en quelque sorte « livré » aux capteurs sensoriels, le toucher est une perception que le sujet doit déclencher activement, par exemple en bougeant ses doigts sur le support dont il veut identifier la forme ou la texture.

À l’aide d’un modèle du réseau neuronal de la perception tactile établi à partir d’enregistrements microneurographiques précédemment effectués sur l’homme, les chercheurs Jérémie Pinoteau et Luca Leonardo Bologna ont donc, sous la direction d’Angelo Arleo, neuroscientifique du Laboratoire de neurobiologie des processus adaptatifs3, implémenté un modèle « neurobotique » simulant la boucle cerveau-bras-main-doigt qui permet l’exploration tactile fine. Ils ont pour cela équipé le doigt d’un bras robotique avec un prototype de peau artificielle lui-même relié au réseau de neurones qu’ils avaient élaboré. « Nous avons eu recours à une tâche de lecture en braille pour mesurer les performances de notre modèle et de son implémentation car, durant le balayage d’une ligne gravée en braille, la perception tactile fine, la prise de décision et les processus de contrôle moteur fin coopèrent pour optimiser la reconnaissance tactile des caractères », précisent les chercheurs. Les doigts d’un lecteur de texte en braille effectuent en effet, la plupart du temps inconsciemment, des séquences d’accélération-décélération-retour en arrière au fur à mesure qu’ils recueillent les perceptions tactiles, ce que les chercheurs appellent une boucle sensorimotrice.

Le doigt qui lit

Conçu dans le cadre du projet européen Sensopac(link is external), ce système robotique s’est révélé capable de reconnaître correctement la quasi-totalité des lettres en braille qui lui étaient présentées. Et surtout, les doigts, capteurs et neurones artificiels, ainsi testés dans des conditions de lecture réelle, ont manifesté une activité analogue à celle auparavant enregistrée chez l’homme. Validant ainsi la pertinence neurobiologique de cette modélisation robotique. « En plus de contribuer au développement d’interfaces robotiques haptiques utilisables dans la vie courante, notre étude avait comme objectif d’élucider les principes régissant le codage nerveux de l’information tactile et sa transmission, ce qui pourrait contribuer à la mise au point de prothèses dotées de sensibilité tactile », conclut Angelo Arleo.

Jadis négligés par les ingénieurs qui n’avaient pas les moyens techniques – ni forcément le besoin immédiat – de les simuler correctement, la main et le toucher sont devenus en quelques années un nouveau Graal pour la robotique. Profitant des découvertes et des modélisations proposées par les neurobiologistes, les biophysiciens ou les psychologues, les roboticiens ont réalisé des progrès considérables au cours des dix dernières années. Mais si, moyennant l’aide de puissants ordinateurs capables de prendre en charge leur intelligence et leur mémoire, on sait désormais fabriquer des mains qui peuvent lire le braille ou nous servir un verre, il y a encore loin de la coupe aux lèvres. Et nous devrons nous contenter encore pendant un certain temps de cohabiter avec des machines qui, même sympathiques et utiles, resteront plus proches de R2D2 que de C3PO…